73亿参数顶级开源模型Mistral-7B升级到v0.2版本,性能与上下文长度均有增强。

Mistral-7B是由MistralAI开源的一个73亿参数规模的大语言模型,最早在2023年9月底开源。因为其良好的性能和友好的开源协议被很多人使用。今天,这个模型升级到来v0.2版本Mistral-7B-v0.2。基于Mistral-7B-v0.2进行指令微调的模型 Mistral-7B-Instruct-v0.2在2023年11月11日公布,而这个基座模型则是在2023年3月24日开源。

加载中...

Mistral-7B是由MistralAI开源的一个73亿参数规模的大语言模型,最早在2023年9月底开源。因为其良好的性能和友好的开源协议被很多人使用。今天,这个模型升级到来v0.2版本Mistral-7B-v0.2。基于Mistral-7B-v0.2进行指令微调的模型 Mistral-7B-Instruct-v0.2在2023年11月11日公布,而这个基座模型则是在2023年3月24日开源。

欢迎关注 DataLearner 官方微信,获得最新 AI 技术推送

Mistral-7B-v0.2是MistralAI最新开源的70亿参数基座大语言模型,是此前Mistral-7B-v0.1的升级版本。

Mistral-7B-v0.2直接在Mistral Hackthon开源,并提供下载链接,并没有在官方做任何宣传和比较,但是开源了继续基于Mistral-7B-v0.2预训练或者微调的代码以及数据集样式,具体参考:https://www.datalearner.com/ai-models/pretrained-models/mistral-7B-v0_2

除了这个预训练结果外,目前官方没有其它介绍。

在2023年9月27日,MistralAI宣布以Apache2.0开源协议开源Mistral 7B。当时,Mistral 7B已经在多项开源测试的表现中超过了Llama1 34B和Llama2 13B。并且代码能力也很强,支持欧洲多国语言,进而受到了广泛的关注。同时发布的还有基于Mistral 7B微调的Mistral 7B Instruct-v0.1版本。具体信息参考: https://www.datalearner.com/ai-models/pretrained-models/Mistral-7B

Mistral-7B-v0.2依然是以Apache2.0协议开源,自由使用。其下载链接、微调代码参考-7B-Instruct-v0.2模型信息卡:https://www.datalearner.com/ai-models/pretrained-models/Mistral-7B-Instruct-v0_2

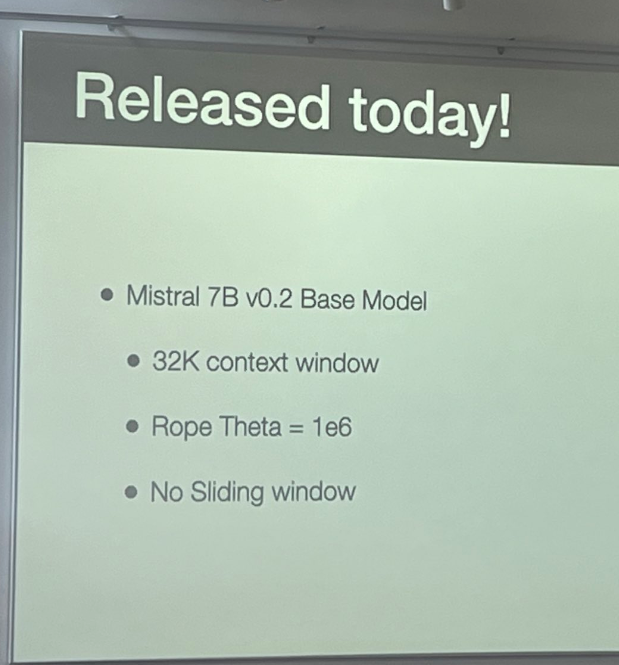

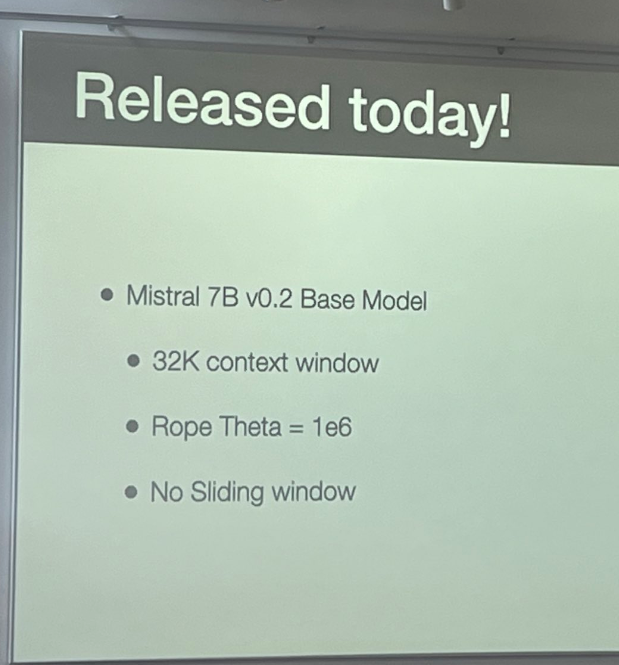

相比较Mistral-7B-v0.1的主要改进如下:

第一个变动很容易理解,这意味着Mistral-7B-v0.2支持更长的上下文输入,最高达到8K。

而第二个参数可能很多人不知道。Rope Theta是一个在大语言模型训练过程中使用的参数,用于优化大型语言模型训练的算法,它可以帮助解决梯度爆炸和梯度消失的问题。Rope Theta限制梯度值在一个合理范围内,避免出现极大或极小的梯度值。从这个角度看,Mistral-7B-Instruct-v0.2调高了Rope Theta,模型能力更强,但是训练过程就不那么稳定了。

第三个是取消了滑动窗口,这意味着此前Mistral-7B-v0.1在训练过程中使用了滑动窗口,即将输入序列切分成小的chunks训练。取消的话一般会让模型对长上下文有更好的表现,但是训练过程一般会变慢,要消耗更多的训练资源。

从上述描述看,Mistral-7B-v0.2的提升应该是不大,但是对于已经应用的人来说,这些提升无疑是有价值的。在某些方面可能会有令人期待的表现(例如支持更长的输入)。官方也有一个图来对Mistral-7B-Instruct-v0.2与其它模型的区别:

在去年九月份的时候,这对比如下:

从MMLU和Knowledge的纵轴看,有一点提升~

Mistral-7B-v0.2版本下载地址等详情:https://www.datalearner.com/ai-models/pretrained-models/mistral-7B-v0_2

Mistral-7B-Instruct-v0.2版本下载地址等详情:https://www.datalearner.com/ai-models/pretrained-models/Mistral-7B-Instruct-v0_2