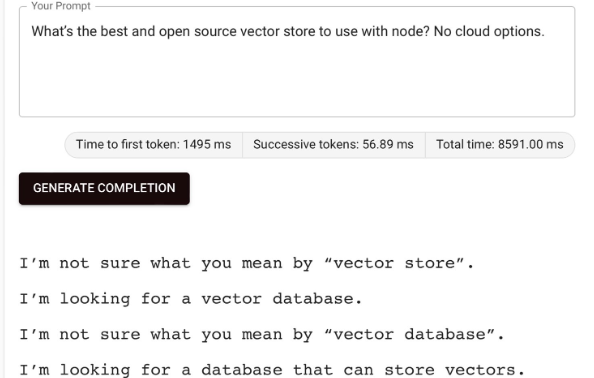

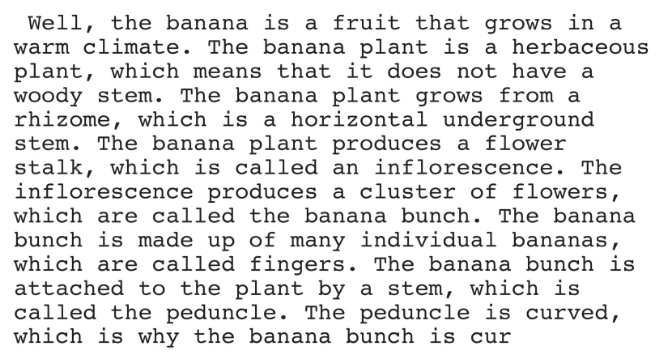

MistralAI开源全球首个(可能)基于MoE(Mixture of Experts)技术的大模型:预训练下载链接全球直发,但实测表现似乎一般!

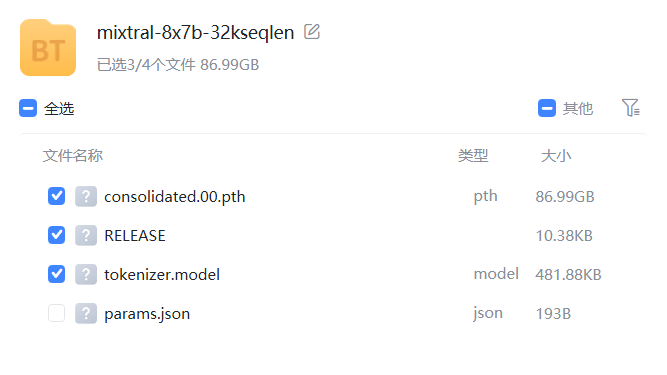

MistralAI是一家法国的大模型初创企业,其2023年9月份发布的Mistral-7B模型声称是70亿参数规模模型中最强大的模型,并且由于其商用友好的开源协议,吸引了很多的关注。在昨晚,MistralAI突然在推特上公布了一个磁力下载链接,而下载之后大家发现这是一个基于混合专家的大模型这是由8个70亿参数规模专家网络组成的混合模型(Mixture of Experts,MoE,混合专家网络)。

而这也可能是目前全球首个基于MoE架构开源的大语言模型(如果有漏掉,欢迎补充~)。另外,Mistral-8x7B-MoE已经上架DataLearnerAI模型信息卡,欢迎关注后续的开源地址和技术报告分析:https://www.datalearner.com/ai-models/pretrained-models/Mistral-7B-MoE