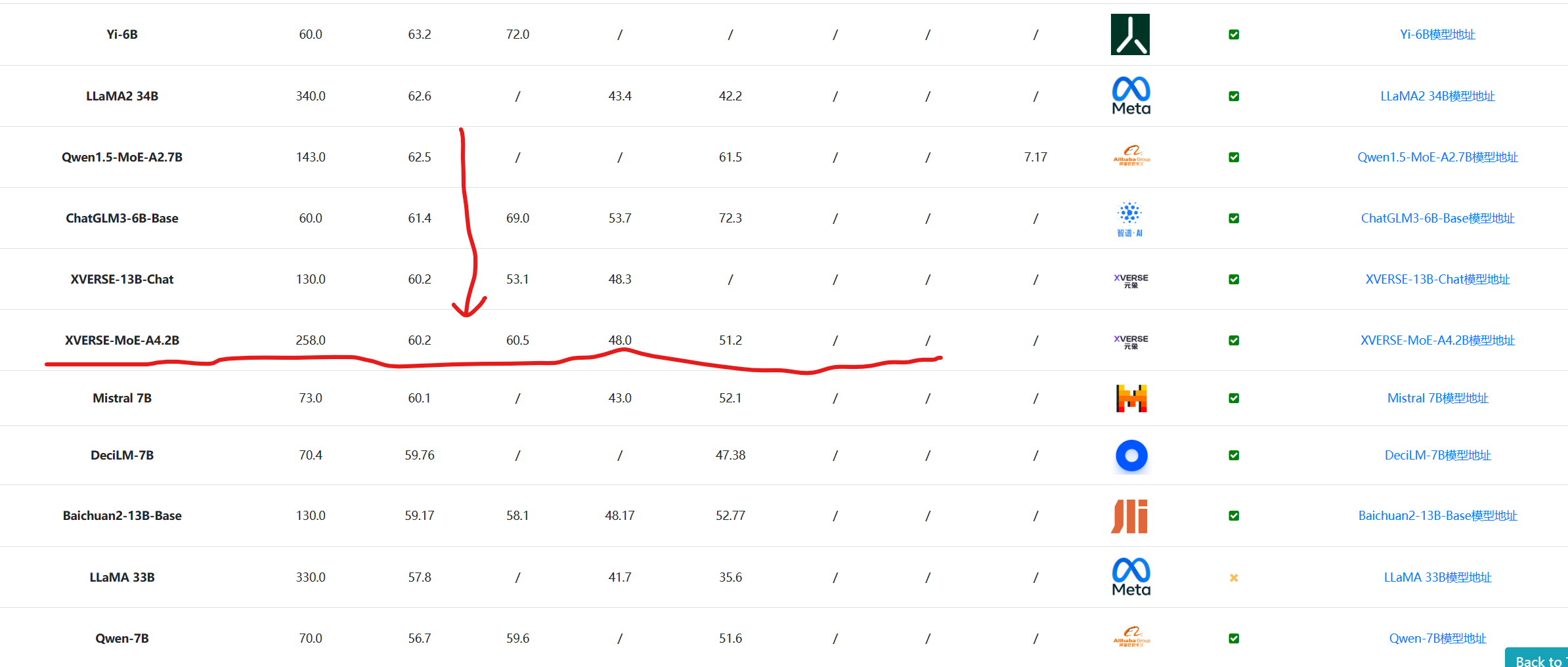

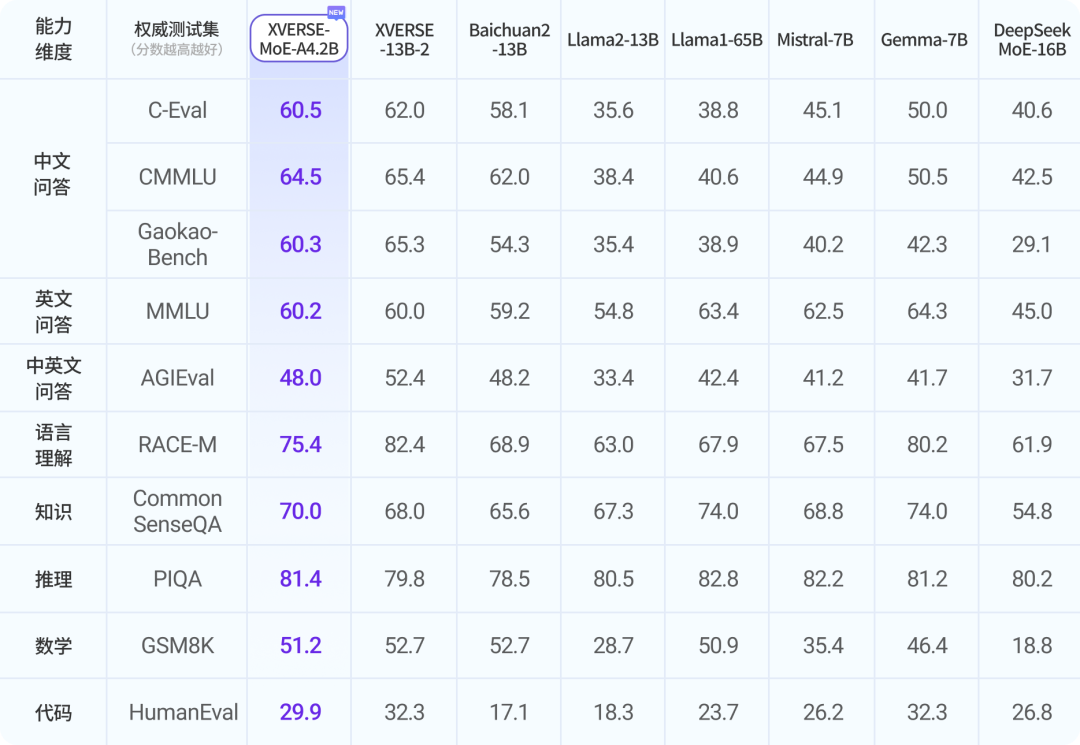

国产MoE架构模型大爆发!深圳元象科技XVERSE开源256亿参数MoE大模型XVERSE-MoE-A4.2B,评测结果接近Llama1-65B

混合专家架构大模型是当前最火热的一个大模型技术发展方向。三月底,业界开源了多个混合专家大模型,包括DBRX、Qwen1.5-MoE-A2.7B等。而在四月初,又一家国产大模型企业开源了一个全新的MoE架构的模型,即深圳元象科技XVERSE开源的XVERSE-MoE-A4.2B。该模型参数256亿,推理时仅激活42亿参数,效果与当前主流的130亿参数的规模差不多。

XVERSE-MoE-A4.2B模型简介

混合专家架构的大语言模型在最近一段时间集中爆发!在2023年,Mixtral 8×7B MoE模型发布之后,MoE架构模型吸引了大量的注意。

目前,根据DataLearnerAI收集的模型数据,国产开源的MoE架构模型并不多,目前只有阿里的通义千问、DeepSeek的DeepSeek LLM等,有相应的模型开源,但总参数规模都不超过200亿。

而深圳元象科技XVERSE本次开源的MoE架构的大模型,总参数量256亿,(此前,XVERSE也是国内最早开源600亿参数规模的大模型,XVERSE-65B,详情参考:,该模型也是Apache2.0协议开源,可以说XVERSE在模型开源方面一直做的比较积极)。