月之暗面开源了一个全新的160亿参数规模的MoE大语言模型Moonlight-16B:其训练算力仅需业界主流的一半

月之暗面(Moonshot AI)是此前中国大模型企业中非常受关注的一家企业。旗下的Kimi大模型和产品因为强悍的性能、超长的上下文以及非常快速的响应引起了广泛的关注。不过,此前MoonshotAI的策略一直是闭源模型,但是产品免费。也许是受到了DeepSeek的压力,月之暗面在2025年2月23日首次开源了旗下的一个小规模参数的大语言模型Moonlight-16B。

Moonlight-16B模型简介

Moonlight-16B是一个大规模的混合专家(MoE)模型,参数数量160亿。官方开源的模型名字是Moonlight-16B-A3B,因为它是160亿参数的大模型,但是每次推理仅激活其中的24亿参数,所以加了一个A3B,A是激活Activation,3B是24亿的参数。

根据官方开源的模型参数,Moonlight-16B-A3B有64个专家和2个共享专家,每次推理的时候每个token会激活其中6个专家。

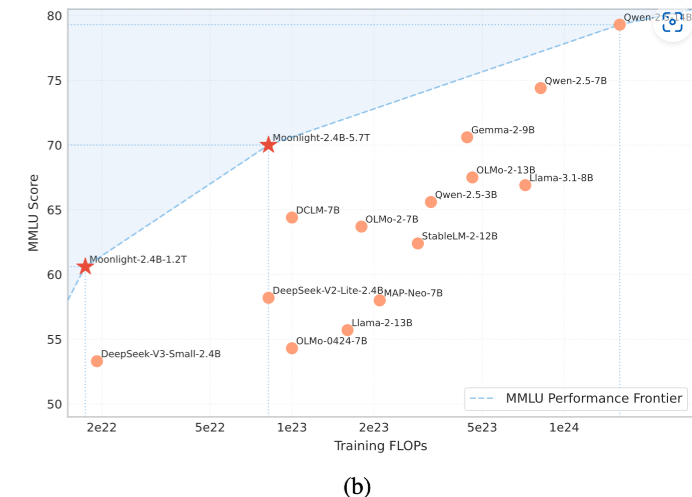

Moonlight的另一个关键创新点是其使用了Muon优化器,这是一种基于矩阵正交化的优化算法,能够大大提高训练过程的效率和稳定性。通过结合MoE架构和Muon优化器,Moonlight模型不仅提高了训练效率,还展现了强大的性能。根据官网的数据,Moonlight模型在训练中使用了5.7万亿tokens的训练数据,但是因为使用了Muon优化器,所需的训练计算量比传统方法减少了50%。