可能比runway更好!StabilityAI最新开源文本生成视频大模型:Stable Video Diffusion,可以生成最多20帧的视频,但不可商用

在深度学习和计算机视觉的发展历程中,视频生成技术一直是一个极具挑战和创新的领域。而发布了一系列开源领域最强图像生成模型Stable Diffusion系列模型背后的企业StabilityAI最近又开源了一个的文本生成视频大模型Stable Video Diffusion模型,这个模型可以生成最多20帧的视频。

加载中...

在深度学习和计算机视觉的发展历程中,视频生成技术一直是一个极具挑战和创新的领域。而发布了一系列开源领域最强图像生成模型Stable Diffusion系列模型背后的企业StabilityAI最近又开源了一个的文本生成视频大模型Stable Video Diffusion模型,这个模型可以生成最多20帧的视频。

欢迎关注 DataLearner 官方微信,获得最新 AI 技术推送

SVD全称Stable Video Diffusion,是StabilityAI最新的开源文本生成视频大模型。这个模型是基于Stable Diffusion 2.1进行初始化,然后通过在图像模型中插入时空卷积和注意力层来构建这个视频生成模型的架构,最终在1.52亿视频数据集上训练得到。

SVD模型是一种潜在视频扩散模型,用于高分辨率的文本到视频和图像到视频生成。这种模型的核心思想是在已有的2D图像合成模型基础上,通过加入时序层并在高质量的视频数据集上进行微调,从而实现生成视频的能力。

SVD系列模型包含2个版本,一个是可以生成14帧576x1024图像的SVD常规模板,一个是可以生成20帧的SVD-XT的微调版本。二者除了生成视频的帧数不一样外,其它都是完全相同的。

二者的开源地址和详细信息参考DataLearner模型信息卡:

Stable Video Diffusion模型是在1.5亿短视频上训练的,而这些短视频的数据来自StabilityAI收集处理。然后Stable Video Diffusion模型通过使用Stable Diffusion 2.1的图像模型进行初始化,插入时空卷积和注意力层来构建视频模型的架构,在上述视频数据训练后得到。

StabilityAI官方没有公开Stable Video Diffusion模型的训练数据集,但是详细说明了相关处理过程。

Stable Video Diffusion模型是基于Stable Diffusion 2.1模型初始化得到的。视频模型架构主要基于latent video diffusion模型,关键架构细节如下:

这篇文章使用的视频模型架构主要基于latent video diffusion模型,关键架构细节如下:

基础框架 使用Stable Diffusion 2.1图像模型进行初始化,提供强大的视觉表示能力。

插入时空层 在图像模型的每一个空间卷积块和自注意力块之后,插入时空卷积层和时空自注意力层。

条件方式 用于文本到视频生成。使用CLIP编码的文本作为条件,融入到模型输入中。

训练策略 分三个阶段进行:图像预训练,视频预训练,高分辨率视频微调。

生成策略 使用EDM框架,相比DDPM/DDIM shifted更多noise到模型输入中。

其他细节 引入帧率微调控制;使用渐进式的vanilla指导避免生成失真。

总的来说,模型主要基于latent diffusion视频模型的经典框架,借鉴图像模型的成功经验,同时在训练策略上进行了重点优化。

SVD模型的训练分为3个阶段:

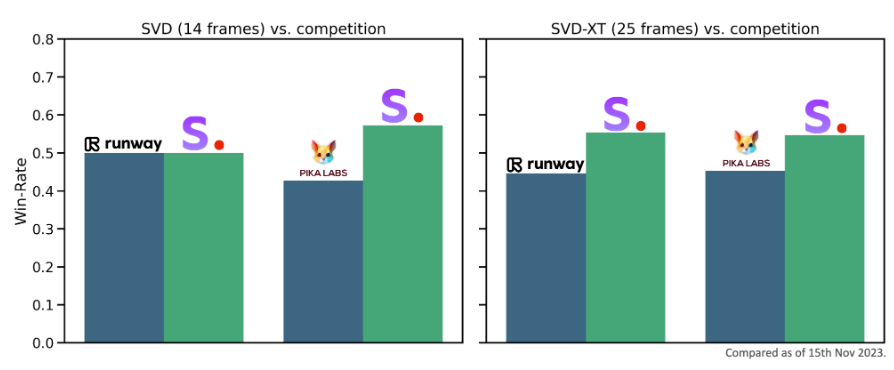

StabilityAI在很多数据集上做了一些评估,认为SVD的效果很好,下图是一个SVD与runway、pika labs效果对比结果:

可以看到,SVD模型的25帧效果是比二者都好的。普通版本则与runway差不多。

Stable Video Diffusion模型是一个质量很高的文本生成视频的大模型。从现有的效果看,视频质量很自然,美观度很高。不过有一点可惜的是这个模型只允许研究目的,不允许商用!

但总的来说: