Pika和HeyGen的开源替代品:上海人工智能实验室开源可以生成高质量最长61秒视频的LaVie文本生成视频大模型

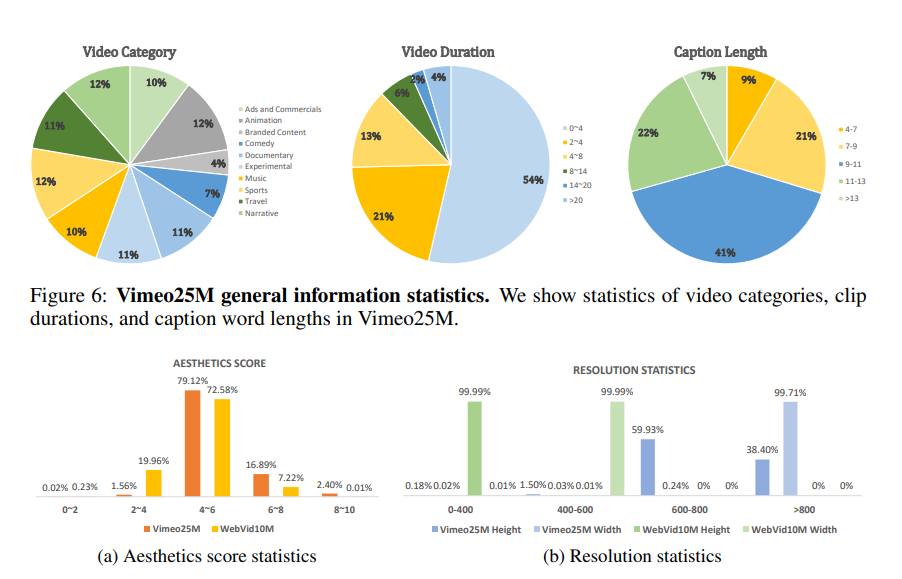

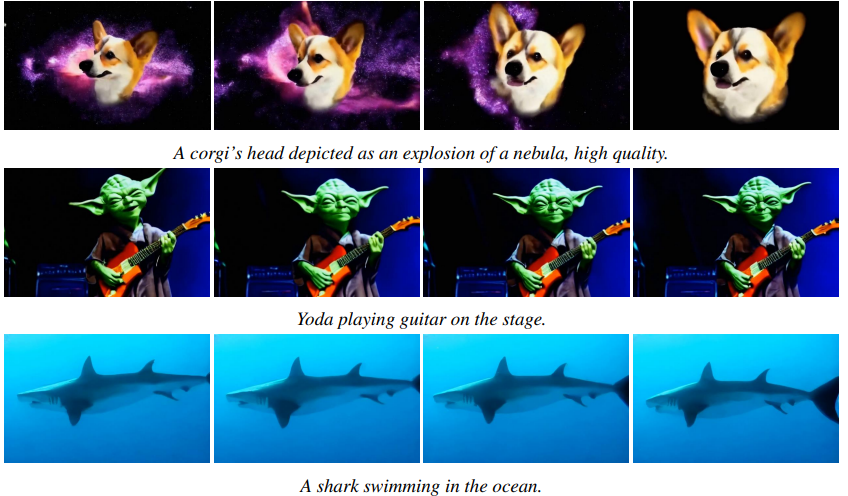

最近,初创企业Pika引起了全球的目光。这家公司发布的Pika 1.0产品可以基于生成式AI技术来创建3D动画视频或者电影级别的视频。由于其逼真的效果,引起了很多人的关注。本文则介绍一个由上海人工智能实验室开源的文本生成视频大模型LaVie。这个模型可以根据文本生成高质量的视频内容。

LaVie模型的代码和预训练结果均已开源,地址参考DataLearnerAI模型信息卡:https://www.datalearner.com/ai-models/pretrained-models/LaVie