国产大模型进展神速!清华大学NLP小组发布顶尖多模态大模型:VisCPM,支持文本生成图片与多模态对话,图片理解能力优秀!

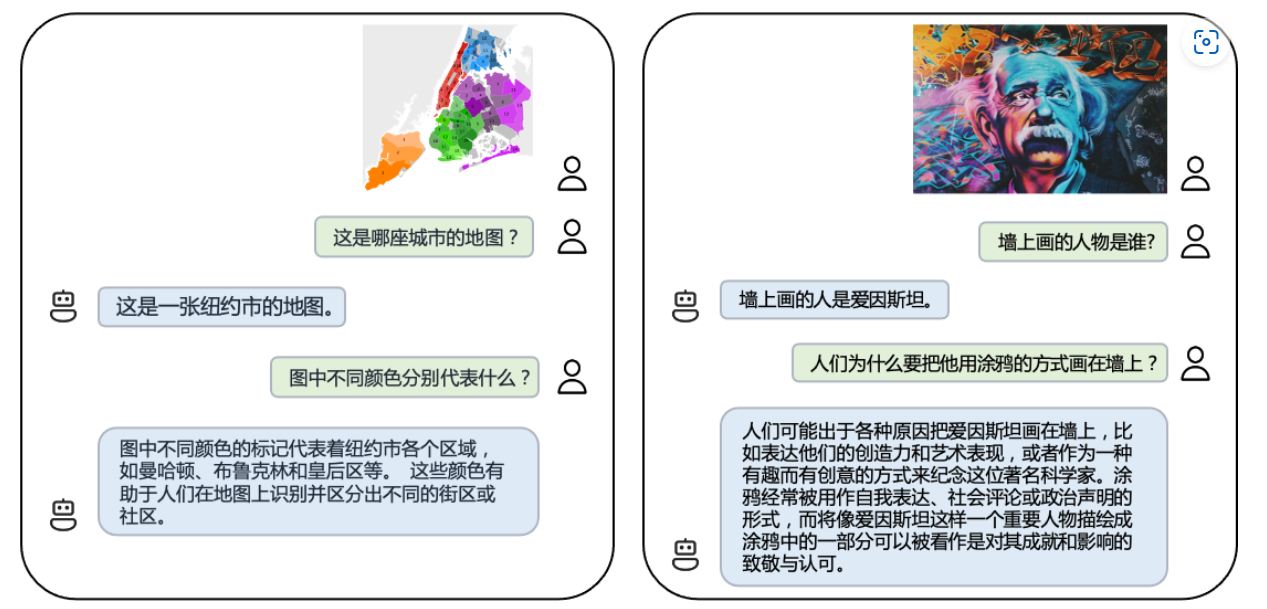

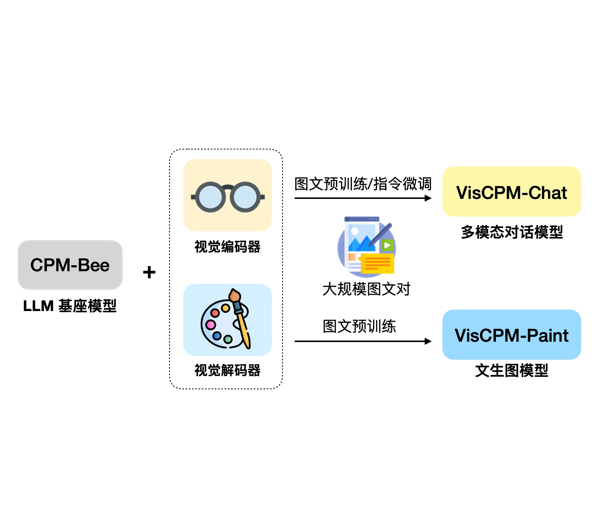

大模型的发展正在从单纯的语言模型向多模态大模型快速发展。尽管GPT-4号称也是一个多模态大模型,但是受限于GPU资源,GPT-4没有开放任何多模态的能力(参考:https://www.datalearner.com/blog/1051685866651273 )。目前大家所能接触到的多模态大模型很少。今天,清华大学NLP小组带来了新的选择,发布了VisCPM系列多模态大模型。VisCPM系列包含2类多模态大模型,分别针对多模态对话和文本生成图片进行优化。

VisCPM多模态大模型简介

VisCPM由清华大学NLP小组基于CPM-Bee-10B进行多模态扩展得到。CPM-Bee-10B是参数规模为100亿的大语言模型,也是由该小组开源,该模型的评测结果英文水平与LLaMA-13B相当,中文水平在ZeroCLUE评测排行榜上仅次于人类排名第二。是一个非常优秀的大语言模型,最重要的是免费商用授权(详情参考CPM-Bee-10B模型信息卡: )。因此,也获得了很多人的关注。