机器学习之正则化项

刚刚开始接触推荐方面模型时,在建模中总能看到“正则化项”、“正则化系数”这样的名词,一开始以为这是建模中的惯用的手法,但是随着看着文献增加,慢慢发现正则化开始变得多样而神秘,模型中到底要不要加正则化呢?到底该选哪种正则化项呢? (“正则化项(regularizer)”又叫做“惩罚项(penalty term)”)

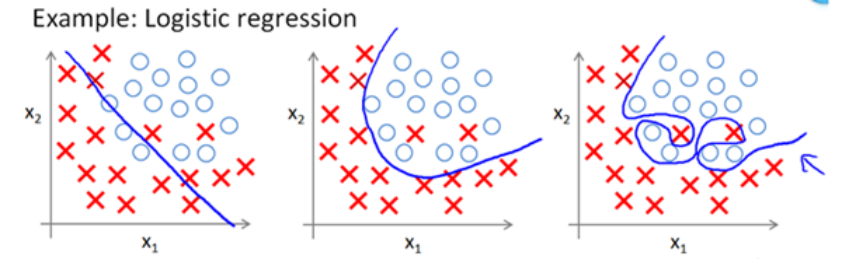

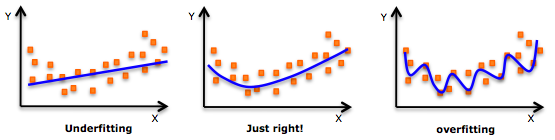

监督机器学习问题实际上就是在规则化参数的同时实现最小化误差,而最小化误差是为了让模型拟合训练数据,而规则化参数就是为了防止我们的模型过分拟合我们的训练数据。下面,我们来看一下拟合数据时的三种情况:

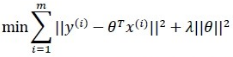

以推荐问题中的贝叶斯评估问题为例,规则化项相当于贝叶斯模型的先验概率,可以是模型参数向量的范数。 上面的λ||θ||便是正则化项,只不过这里用的是L2范数。正则化项可以是零范数、一范数、二范数、迹范数、Frobenius范数和核范数等。下面来具体看一下L0、L1、L2三种: