比OpenAI原始的Whisper快70倍的开源语音识别模型Whisper JAX发布!

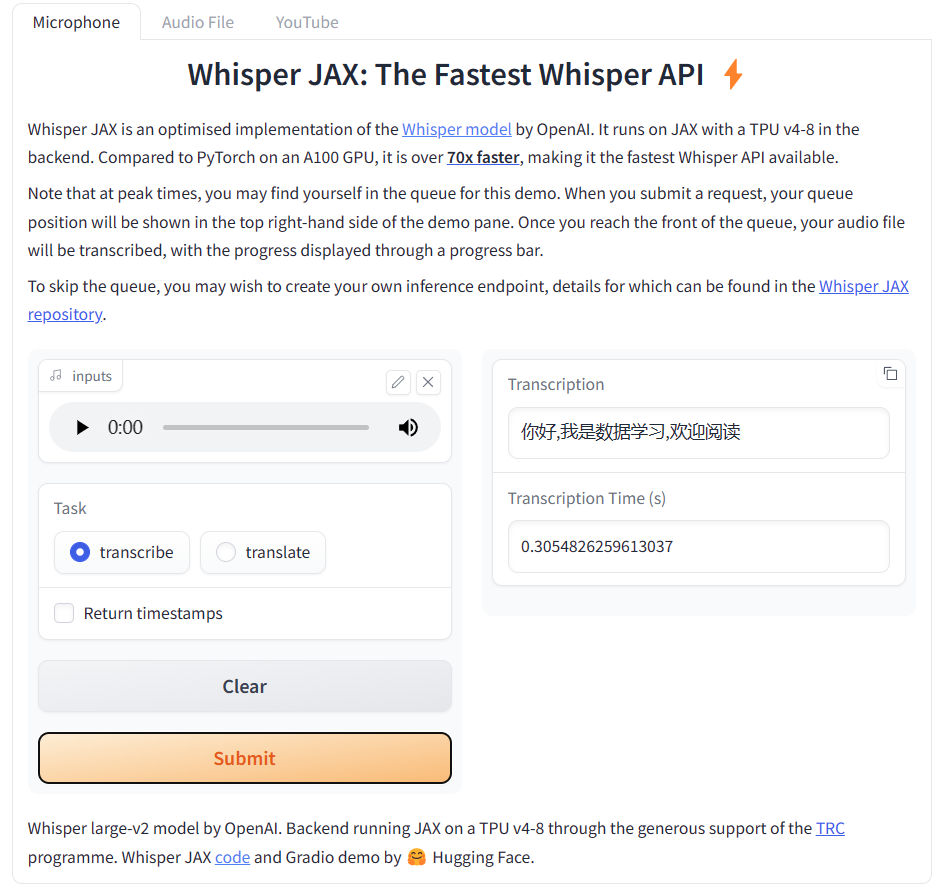

Whisper是OpenAI在2022年9月份开源的自动语音识别模型。官方宣传其英语的识别水平与人类接近。而2个月后,官方就发布了Whisper V2版本,是第一个版本继续训练2.5倍得到,且加了正则化技术。而今天,一位网友Sanchit Gandhi发布了Whisper JAX,这是对原有版本的优化结果,识别速度最高达到原始模型的70倍!

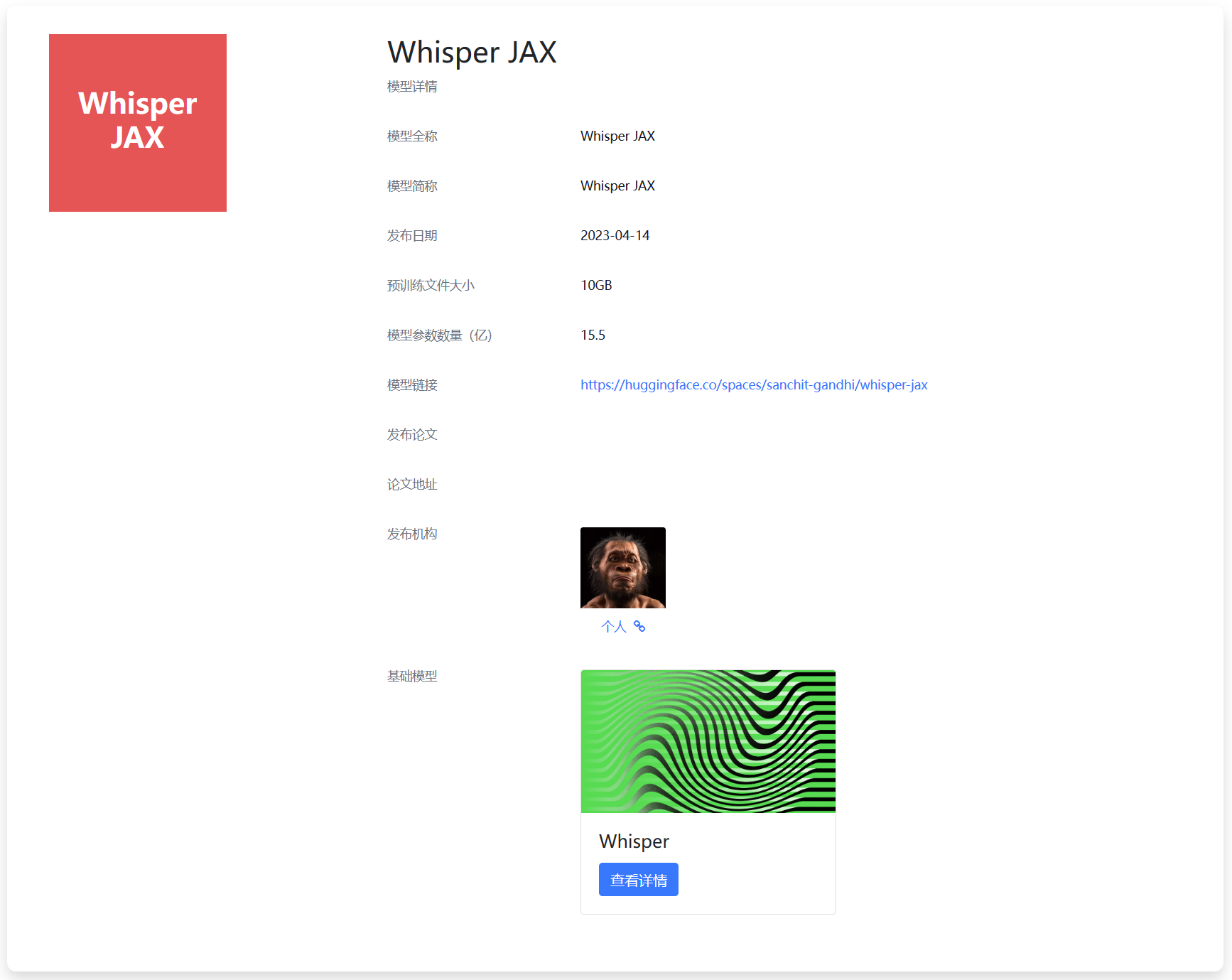

Whisper模型卡信息:https://www.datalearner.com/ai-models/pretrained-models/Whisper%20JAX

Whisper JAX性能对比

从GitHub上提供的信息看,各个版本的Whisper的参数对比结果如下: