三年后OpenAI再次发布自动语音识别和语音合成大模型(替换Whisper系列):不开源,仅提供API,英文错字率已经下降到2.46%

2025年3月20日,OpenAI推出了三款新模型——gpt-4o-transcribe、gpt-4o-mini-transcribe 和 gpt-4o-mini-tts。前面2个是自动语音识别模型(ASR),最后一个是语音合成模型(TTS)。这些模型基于 GPT-4o 架构,本文将介绍这些模型、其能力、定价、可用性等方面。

加载中...

2025年3月20日,OpenAI推出了三款新模型——gpt-4o-transcribe、gpt-4o-mini-transcribe 和 gpt-4o-mini-tts。前面2个是自动语音识别模型(ASR),最后一个是语音合成模型(TTS)。这些模型基于 GPT-4o 架构,本文将介绍这些模型、其能力、定价、可用性等方面。

欢迎关注 DataLearner 官方微信,获得最新 AI 技术推送

本次发布的三个模型均是基于GPT-4o架构,ASR模型有2个,TTS的模型1个。下面是三个模型的介绍。

gpt-4o-transcribe 模型被定位为 OpenAI 的 Whisper 模型的继任者,提供了增强的转录准确性。在英语中,它实现了 2.46% 的字错误率 (WER),这是对以前模型的显著改进。该模型基于多样、高质量的音频数据集进行训练,融入了强化学习和中间训练技术,以处理具有挑战性的条件。关键特性包括:

性能基准,例如在 FLEURS 基准上的测试,表明它在手动转录音频的语言中优于 Whisper v2 和 v3。该模型不是开源的,OpenAI称其“比 Whisper 大得多”的模型。定价为每 100 万音频输入tokens 6.00 美元,相当于每分钟约 0.006 美元。

对于注重成本效益的用户,gpt-4o-mini-transcribe 提供了一个更小、更实惠的替代方案,同时保持了与 gpt-4o-transcribe 相似的转录能力。它也提高了 WER 和语言识别能力,基于多样化的音频数据集进行训练,以处理带有口音的语言并减少幻觉。与其对应模型一样,它不是开源的,比 Whisper 大,设计用于 API 集成而非本地部署。

定价显著较低,为每 100 万音频输入tokens是3美元,约为每分钟0.003美元,是gpt-4o-transcribe的一半。

OpenAI此次发布的另一个模型是gpt-4o-mini-tts,这个模型是语音合成模型。它在文本转语音技术中引入了新的自定义级别,允许开发人员通过自然语言指令指导模型。例如,“像个疯狂科学家一样说话”或“使用平静的声音,像一位正念老师一样”,使其能够产生细致入微、逼真的语音。这种可引导性是关键特性,允许为特定上下文定制语音体验,例如:

然而,该模型仅限于使用人工预设声音,以解决语音模仿的担忧并确保符合伦理标准。

定价为每 100 万文本输入tokens是0.6美元和每100万音频输出tokens大概是12.00 美元,约为每分钟 0.015 美元。该模型基于 GPT-4o-mini 架构,通过高级蒸馏和强化学习增强,使其适合需要动态语音输出的应用。

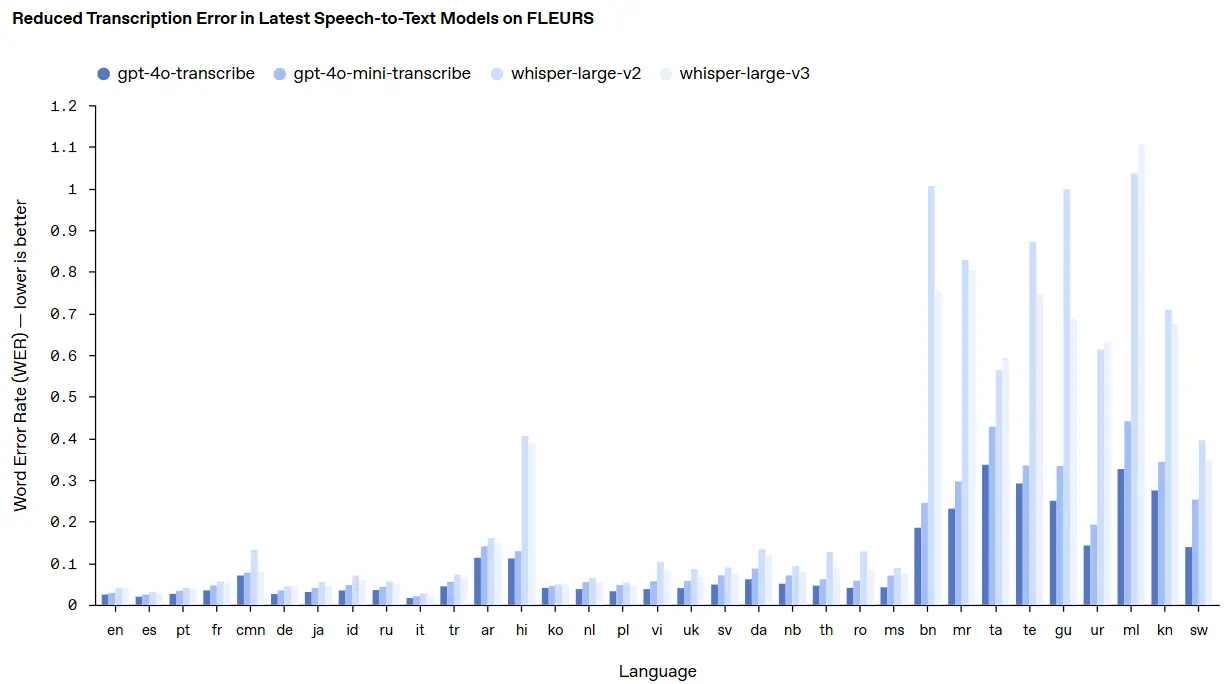

官方给出了gpt-4o-transcribe、gpt-4o-mini-transcribe等模型的错字率对比结果:

可以看到,相比较前代的whisper模型,gpt-4o-transcribe模型在不同语种上的错字率都有进步。同时,与业界其它模型对比,OpenAI的语音识别模型也具有很好的优势:

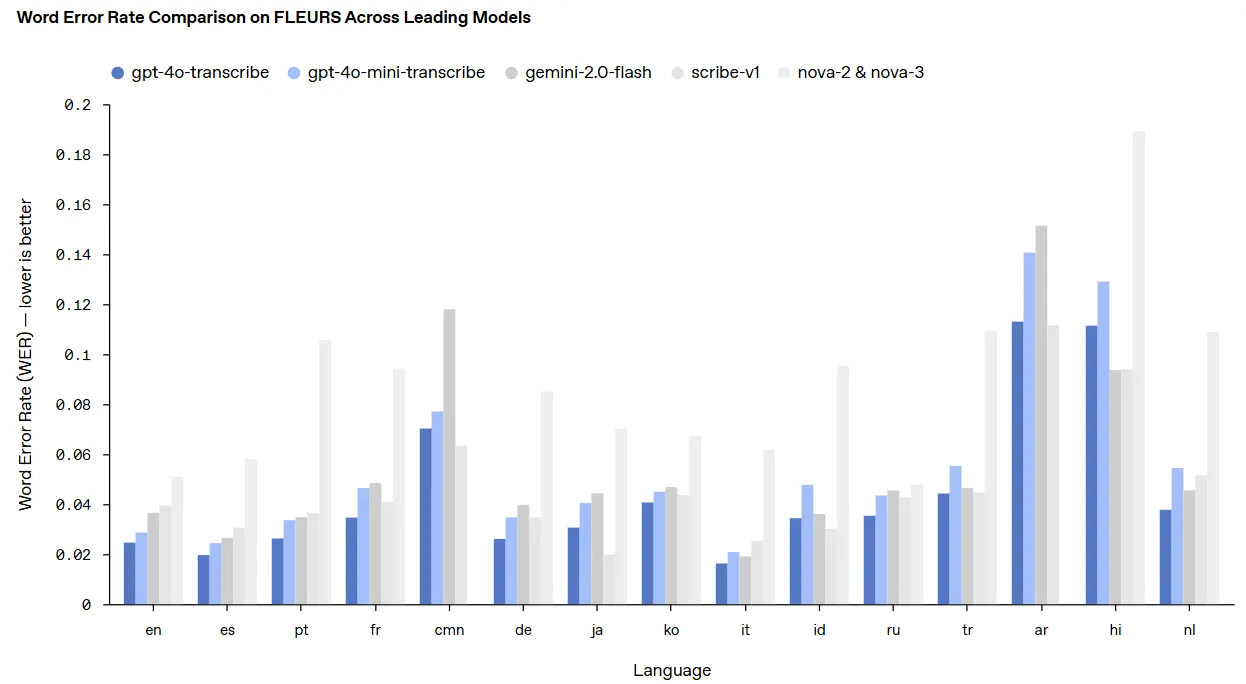

与gemini等模型对比,gpt-4o-transcribe也是非常不错的。

所有三个模型均可通过 OpenAI 的 API获取,提供开发人员将这些功能集成到其应用中的工具。此外,OpenAI 推出了一个自定义演示网站 OpenAI.fm,供个人用户测试和体验模型。

API 集成由详细的文档支持,包括语音转文本 (platform.openai.com/docs/guides/speech-to-text) 和文本转语音 (platform.openai.com/docs/guides/text-to-speech) 的指南,提供技术规范和实施示例。

OpenAI 为每个模型设定了明确的定价,需要注意的是,gpt-4o-transcribe和gpt-4o-mini-transcribe虽然是ASR模型,可以将语音转为文本,但是它也支持文本作为输入,因此这几个模型的定价就有点不一样了,我们总结如下::

文本处理相关的定价 单位是每100万tokens

音频处理相关的定价 单位是每100万tokens

可以看到,如果你做音频识别,一分钟的音频输入大概0.006美元,输出100万文本tokens是10美元(选择4o-mini的话价格一半)。如果是语音合成,那么输入文本价格是100万tokens为0.6美元,输出是大约一分钟音频0.015美元。

价格还可以,不算贵。

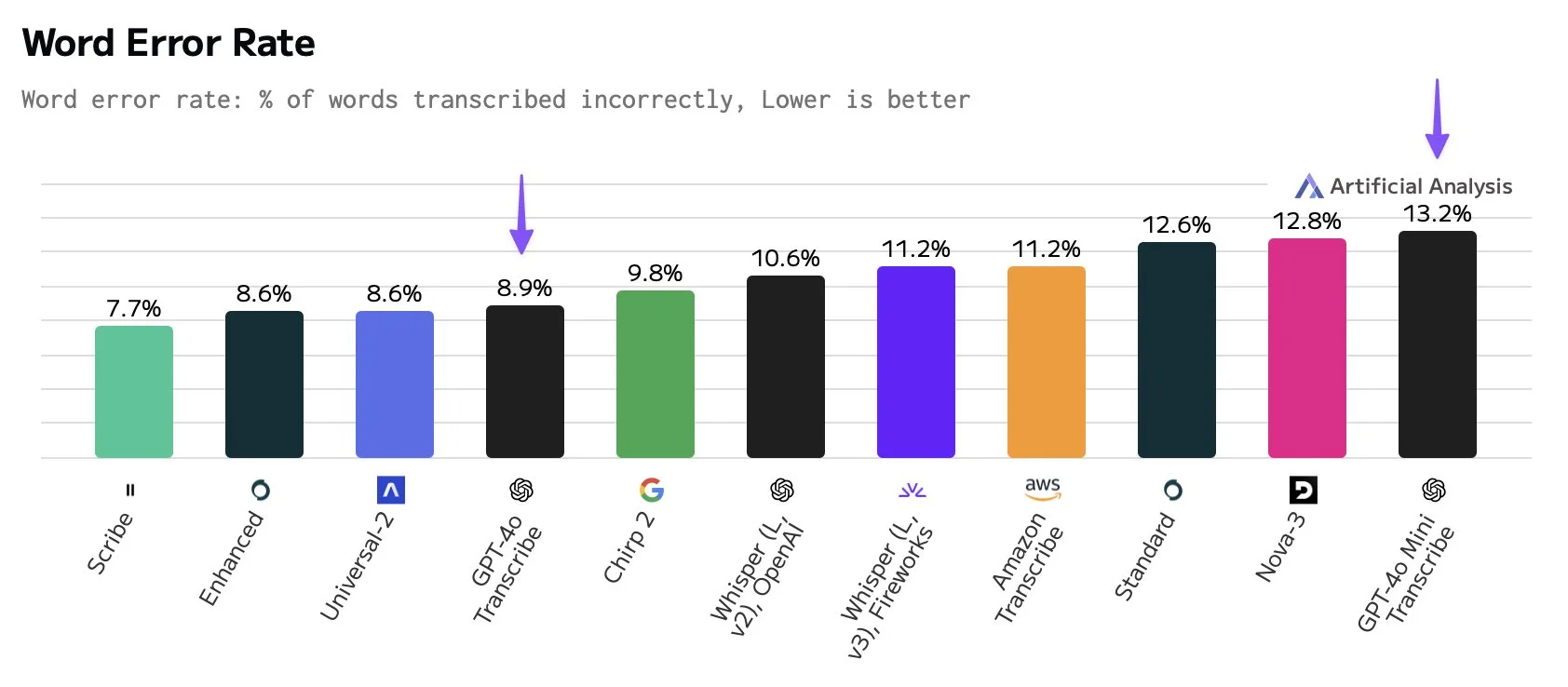

OpenAI发布的这几个模型当前市场上也有类似的服务。例如,ElevenLabs 提供 Scribe 模型,在英语中 WER 为 3.3%,定价为每小时输入音频 0.40 美元(约每分钟 0.006 美元),与 gpt-4o-transcribe 大致相当。Hume AI 提供 Octave TTS 模型,专注于句子级和词级发音和情感语调的自定义,基于用户指令而非预设声音。

上图来自Artificial Analysis,可以看到,市场竞争还是很强的。

尽管存在竞争,OpenAI的模型优点是和OpenAI的生态无缝集成。同时,像gpt-4o-mini-tts这种可引导性的语音合成,使其在需要动态和上下文感知交互的应用中非常有优势。

关于OpenAI三个模型更多信息参考DataLearnerAI模型信息卡:

gpt-4o-transcribe:https://www.datalearner.com/ai-models/pretrained-models/gpt-4o-transcribe gpt-4o-mini-transcribe:https://www.datalearner.com/ai-models/pretrained-models/gpt-4o-mini-transcribe gpt-4o-mini-tts:https://www.datalearner.com/ai-models/pretrained-models/gpt-4o-mini-tts