Google发布迄今为止公开可用的最大的多语言网络数据集MADLAD-400,覆盖419种语言

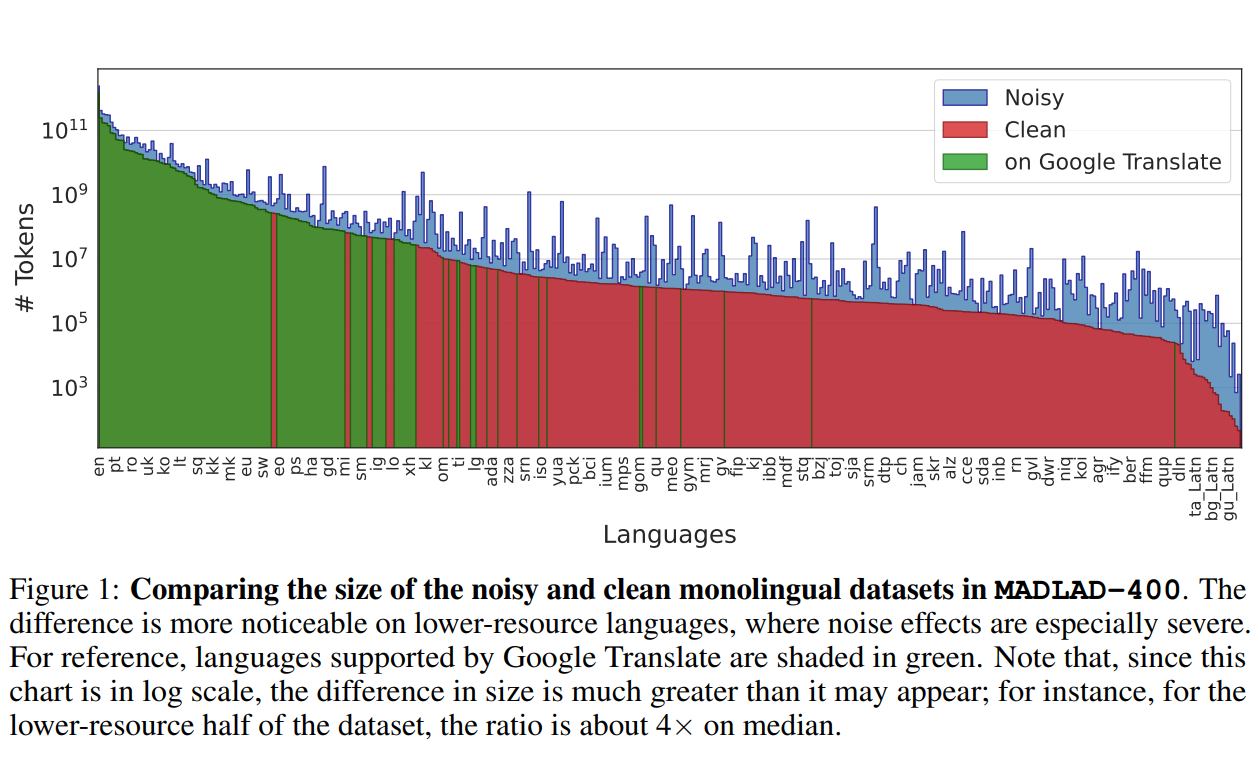

Google DeepMind与Google Research的研究人员推出了一个全新的多语言数据集——MADLAD-400!这个数据集汇集了来自全球互联网的419种语言的大量文本数据,其规模和语言覆盖范围在公开可用的多语言数据集中应该是最大的。研究人员从Common Crawl这个庞大的网页爬虫项目中提取了大量数据,并进行了人工审核,删除了许多噪音,使数据集的质量得到了显著提升。

MADLAD-400简介

根据谷歌发布的论文提示,该数据集覆盖了419种语言,远远超过了目前公开数据集通常只包括100-200种语言的情况。其中不仅包括常见语言如英语、汉语,还包括许多罕见语言,如阿尔巴尼亚语、克罗地亚语等。这对于推动全球各种语言领域的自然语言处理具有重要意义。

其次,它的数据量非常庞大,包含了5万亿个tokens!这为训练大规模多语言模型提供了所需的海量数据。模型所训练的数据量越大,其效果就越好,这个数据集满足了对大规模数据的需求。

此外,数据集是按文档划分的,而不是简单的句子级别,这更符合语言的自然分布。研究人员还经过手动审核,对存在问题的语言数据进行了过滤,以确保数据集的整体质量。