智谱AI与清华大学联合发布第三代基座大语言模型ChatGLM3:6B版本的ChatGLM3能力大幅增强,依然免费商用授权!

ChatGLM系列是智谱AI发布的一系列大语言模型,因为其优秀的性能和良好的开源协议,在国产大模型和全球大模型领域都有很高的知名度。今天,智谱AI开源其第三代基座大语言模型ChatGLM3-6B,官方说明该模型的性能较前一代大幅提升,是10B以下最强基础大模型!

ChatGLM3简介

ChatGLM系列是国产大语言模型中最强大最著名的模型之一。在第一代ChatGLM-6B在2023年3月份推出,开源推出之后不久就获得了很多的关注和使用。3个月后的2023年6月份,ChatGLM2发布,再次引起了广泛的关注。

2023年的10月27日,智谱AI联合清华大学再次发布第三代基础大语言模型ChatGLM3系列。本次发布的第三代模型共包含3个:基础大语言模型ChatGLM3-6B-Base、对话调优大语言模型ChatGLM3-6B和长文本对话大语言模型ChatGLM3-6B-32K。

如下所示:

| 模型版本 | 模型介绍 | 上下文长度 | 开源情况| DataLearner模型信息卡地址 | | ------------ | ------------ | ------------ | | ChatGLM3-6B-Base | 基础大语言模型,预训练结果 | 8K | 免费商用授权 |https://www.datalearner.com/ai-models/pretrained-models/ChatGLM3-6B-Base | | ChatGLM3-6B |基础大语言模型针对对话微调调优,适合对话 | 8K | 免费商用授权| https://www.datalearner.com/ai-models/pretrained-models/ChatGLM3-6B | | ChatGLM3-6B-32K | 对话调优的大语言模型,但是支持32K上下文| 32K | 免费商用授权 | https://www.datalearner.com/ai-models/pretrained-models/ChatGLM3-6B-32K | |ChatGLM3-3B | 对话微调版本,小规模参数,可以在手机端运行 | 8K | 不开源 |https://www.datalearner.com/ai-models/pretrained-models/ChatGLM3-3B |ChatGLM3-1.5B | 对话微调版本,小规模参数,可以在手机端运行 | 8K | 不开源 |https://www.datalearner.com/ai-models/pretrained-models/ChatGLM3-1-5B

需要注意的是,ChatGLM3的功能不仅仅局限于生成对话,在工具调优、prompt调优、代码执行等方面都有很大提升!

ChatGLM3的性能结果

根据官方的描述,ChatGLM3的性能比第二大有大幅的提高。在各项评测中的得分均有大幅提升。官方甚至宣称:

ChatGLM3-6B-Base 具有在 10B 以下的基础模型中最强的性能。

具体来说,评测结果和提升结果如下:

| 模型版本 | 评测任务 | 评测方向 | 得分 | 相比第二代提升 | ------------ | ------------ | ------------ |------------ | | ChatGLM2-6B-Base | MMLU | 自然语言理解等 | 47.9 | - | | ChatGLM2-6B-Base | GSM8K | 数学能力 | 32.4 | - | | ChatGLM2-6B-Base | C-Eval | 中文能力 | 51.7| - | | ChatGLM3-6B-Base | MMLU | 自然语言理解等 | 61.4 | 36% | | ChatGLM3-6B-Base | GSM8K | 数学能力 | 72.3 | 179% | | ChatGLM3-6B-Base | C-Eval | 中文能力 | 69| 33.5% |

上述只选取了部分的评测结果,可以看到,ChatGLM3在各方面都有较大的提升。

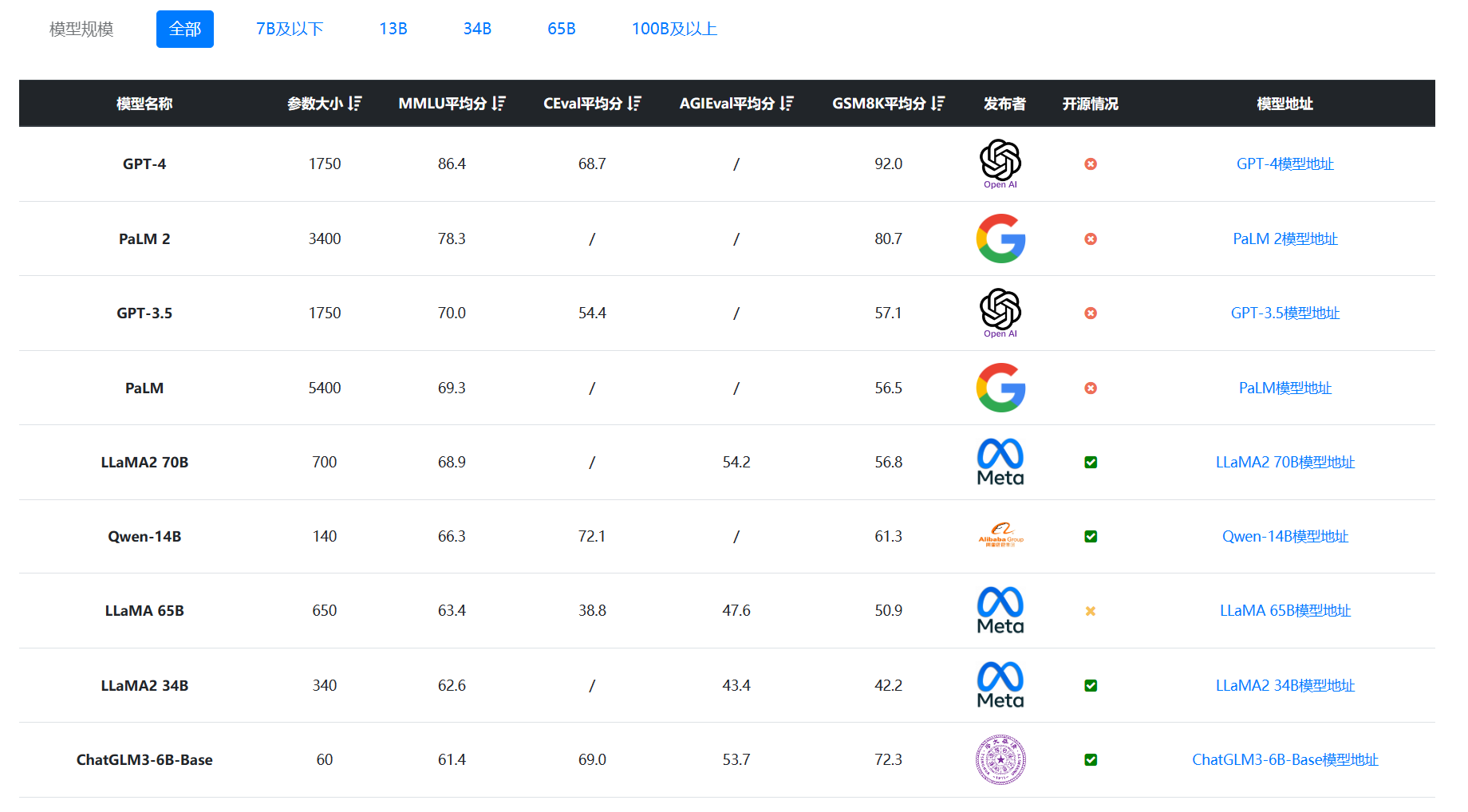

在DataLearnerAI的大模型评测综合排名中,ChatGLM3的得分也是十分优秀!下图是按照所有收集的重点模型和国产模型按照MMLU得分排序结果:

可以看到,即使按照MMLU排序,在所有规模的模型对比下,ChatGLM3-6B得分排序第9,但是前面8个模型最小的也是140亿参数规模的Qwen-14B,如果按照GSM8K排序,ChatGLM3-6B-Base甚至排到第三,超过了GPT-3.5的57.1分!十分恐怖。具体得分参考,大家可以去DataLearnerAI大模型排行看:https://www.datalearner.com/ai-models/llm-evaluation

不过,虽然官方强调,ChatGLM3系列的代码能力很强,但是目前还没有HumanEval的评分结果放出。

ChatGLM3的训练细节

虽然官方没有详细公布ChatGLM3的相关训练信息,但是也有一些基本的数据供大家参考。

首先是 ChatGLM3-6B 的基础模型的训练使用了更多且更加多样的数据,更充分的训练步数和合理的训练策略; 其次是ChatGLM3-6B针对Prompt设计做了提升,可以让模型在普通的对话外,对 Code Interpreter,Tool & Agent 等任务的输入支持更好。下图是一个案例:

<|system|>

You are ChatGLM3, a large language model trained by Zhipu.AI. Follow the user's instructions carefully. Respond using markdown.

<|user|>

Hello

<|assistant|>

Hello, I'm ChatGLM3. What can I assist you today?

具体的prompt样例参考:https://github.com/THUDM/ChatGLM3/blob/main/PROMPT.md

最后,为了支撑更长的上下文,官方对位置编码进行了更新,并设计了更有针对性的长文本训练方法,在对话阶段使用 32K 的上下文长度训练。

ChatGLM3系列的其它能力

大语言模型卷到现在,大家已经不满足基本的对话能力了,对代码执行、接口调用、AI Agent都有很强的诉求。本次官方透露,ChatGLM3系列模型除了基本对话能力的提升外还有诸多支持:

-

更强的代码执行能力,即Code Interpreter,尽管官方没有公布ChatGLM3的代码评测结果,但是应该不差,ChatGLM3的代码增强模块 Code Interpreter 根据用户需求生成代码并执行,自动完成数据分析、文件处理等复杂任务;

-

网络搜索增强WebGLM,接入搜索增强,能自动根据问题在互联网上查找相关资料并在回答时提供参考相关文献或文章链接。

-

全新的 Agent 智能体能力:ChatGLM3 本次集成了自研的 AgentTuning 技术,AI Agent水平比第二代提升1000%,关于AgentTuning,我们之前有过介绍,参考:如何提高大语言模型作为Agent的能力?清华大学与智谱AI推出AgentTuning方案。提一句,Agent能力非常依赖规划和推理,从公布的结果看,ChatGLM3在GSM8K等数学逻辑推理方面的评测结果已经超过GPT-3.5,因此对于Agent的支持理论上应该非常棒。

-

多模态能力,官方宣称多模态理解能力的CogVLM,看图识语义,在10余个国际标准图文评测数据集上取得SOTA;

-

端侧推理:ChatGLM3 本次推出可手机部署的端测模型 ChatGLM3-1.5B 和 ChatGLM3-3B,支持在手机端的调用,速度可以达到20 tokens/s,一般成年人阅读的速度是每秒2-5个单词,完全足够,而且官方宣称自己的ChatGLM3-1.5B和ChatGLM3-3B与ChatGLM2-6B水平差不多(即第二代)。

总结

ChatGLM系列是国产非常具有影响力的大语言模型系列,从3月份开源第一代到现在7个月之后迭代到第三代,发展十分迅猛。而且,在AI Agent、代码执行、多模态等方面都有非常好的布局和提升,十分值得大家关注。此外,友好的开源协议,免费的商用授权也是十分不错的。关于模型具体的开源地址和信息,大家参考DataLearnerAI的模型信息卡即可:

| 模型版本 | 模型介绍 | 上下文长度 | 开源情况| DataLearner模型信息卡地址 | | ------------ | ------------ | ------------ | | ChatGLM3-6B-Base | 基础大语言模型,预训练结果 | 8K | 免费商用授权 |https://www.datalearner.com/ai-models/pretrained-models/ChatGLM3-6B-Base | | ChatGLM3-6B |基础大语言模型针对对话微调调优,适合对话 | 8K | 免费商用授权| https://www.datalearner.com/ai-models/pretrained-models/ChatGLM3-6B | | ChatGLM3-6B-32K | 对话调优的大语言模型,但是支持32K上下文| 32K | 免费商用授权 | https://www.datalearner.com/ai-models/pretrained-models/ChatGLM3-6B-32K | |ChatGLM3-3B | 对话微调版本,小规模参数,可以在手机端运行 | 8K | 不开源 |https://www.datalearner.com/ai-models/pretrained-models/ChatGLM3-3B |ChatGLM3-1.5B | 对话微调版本,小规模参数,可以在手机端运行 | 8K | 不开源 |https://www.datalearner.com/ai-models/pretrained-models/ChatGLM3-1-5B