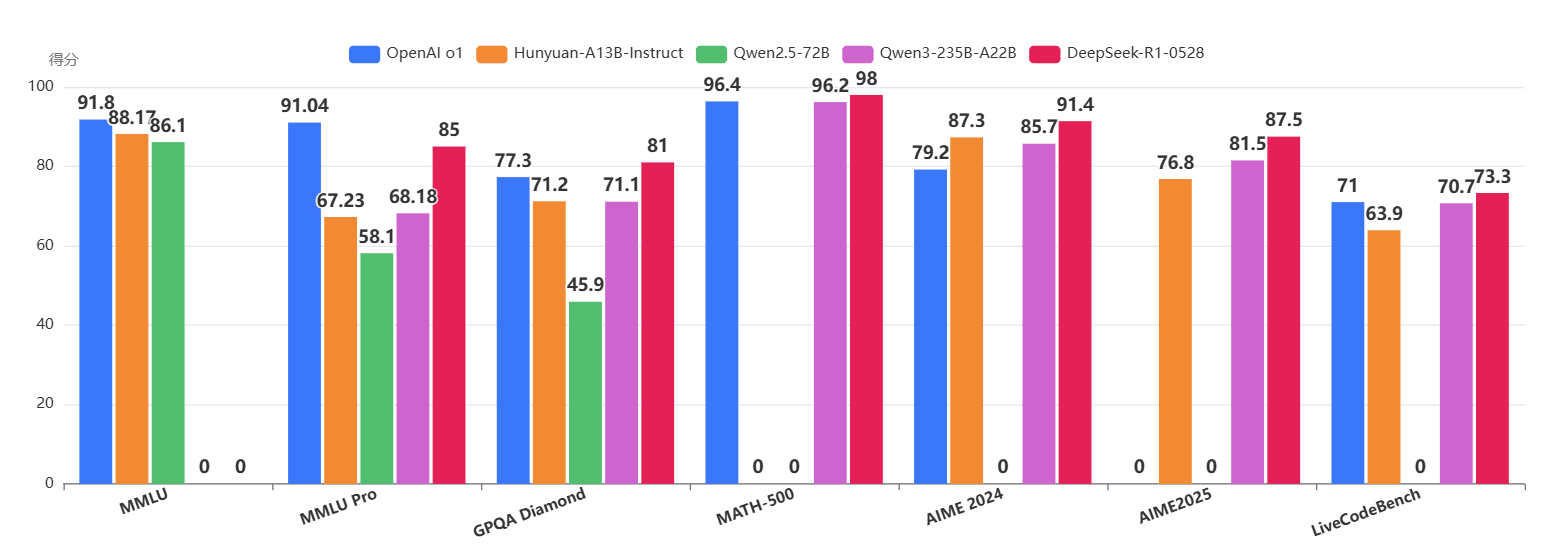

腾讯开源Hunyuan-A13B大模型:MoE架构,混合推理(支持直接回复和带推理过程后回复),原WizardLM团队打造,评测结果超Qwen2.5-72B,接近Qwen3-A22B,但参数量只有一半

2025年6月27日,腾讯发布并开源了其混元大模型系列的新成员Hunyuan-A13B。该模型定位为一个基于细粒度专家混合(MoE)架构的大语言模型。其主要特点是高效率和可扩展性,旨在为开发者和研究人员,特别是在资源受限的环境中,提供高级推理和通用应用能力。Hunyuan-A13B是由原来的微软的WizardLM团队成员打造(二代WizardLM2在2024年开源打败了所有闭源模型,仅次于最新的GPT-4,似乎这件事在微软内部引起了很大的问题,不久后撤回了这个模型,团队成员也离职了,后面加入了腾讯)。