加载中...

加载中...

几个小时前,OpenAI的研究人员披露,其一款内部实验性的大语言模型,在模拟的国际数学奥林匹克(International Math Olympiad ,IMO)竞赛2025中取得了金牌水平的成绩。这是一个里程碑式的突破,因为IMO被认为是衡量创造性数学推理能力的巅峰,远超以往任何AI基准测试。这项成就并非通过专门针对数学能力对大模型进行定制的方法实现,而是源于通用人工智能研究的根本性突破,尤其是在处理难以验证的任务和长时间推理方面。

国际数学奥林匹克(IMO)长期被视为 AI 推理能力的试金石。其挑战性在于:

OpenAI本次公布的实验性模型,正是在严格复现上述环境下进行的测试。最终,该模型在与人类选手相同的规则下解决了6道题中的5道(P1-P5),其证明过程由三位前IMO奖牌得主独立评审并达成共识,最终得分35/42,足以获得金牌(2024年金牌分数线为32分)。

此项成就的核心在于其评估标准的高度和复杂性。与以往的AI基准测试相比,IMO带来了质的飞跃:

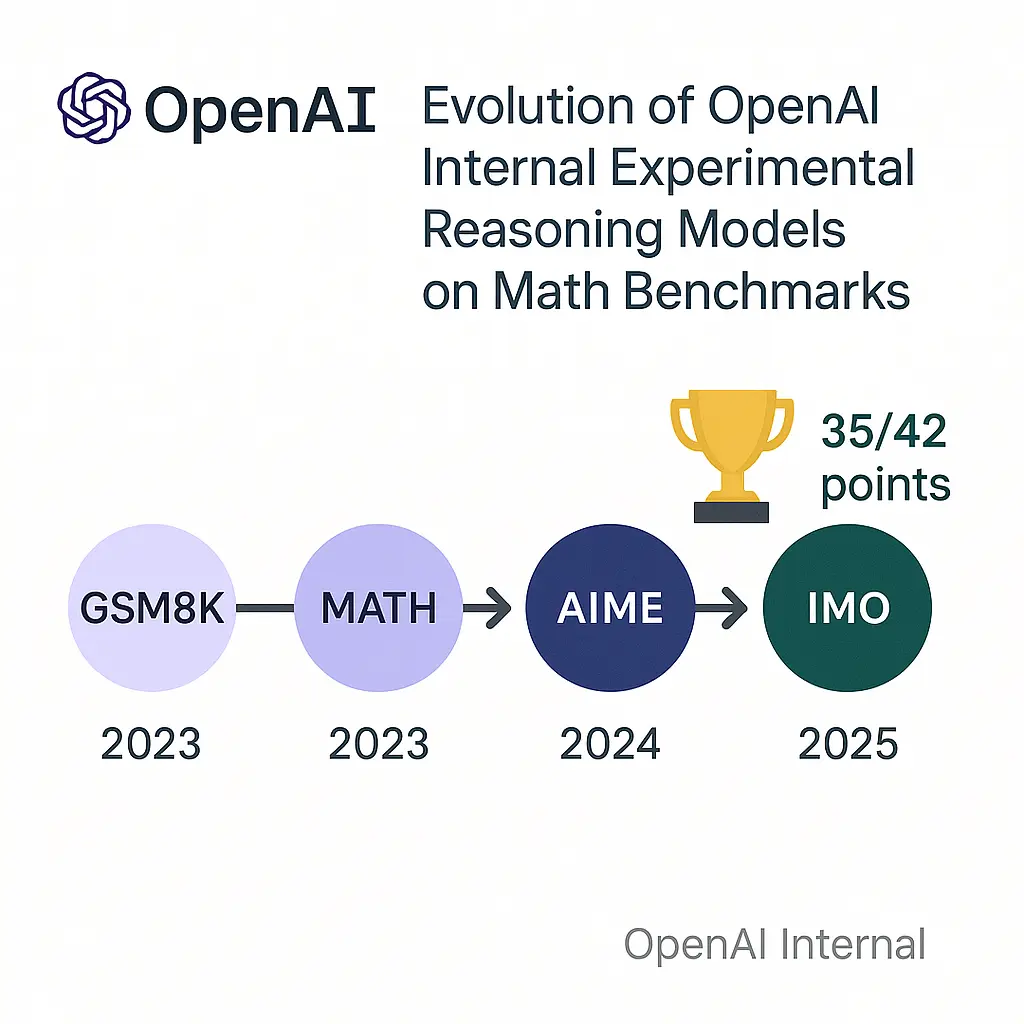

这里,我们也看一下OpenAI大模型解决数学问题的历史飞跃(即平均单题推理时长,大家也可以点击评测基准URL查看我们DataLearnerAI上面这些基准背后模型的水平):

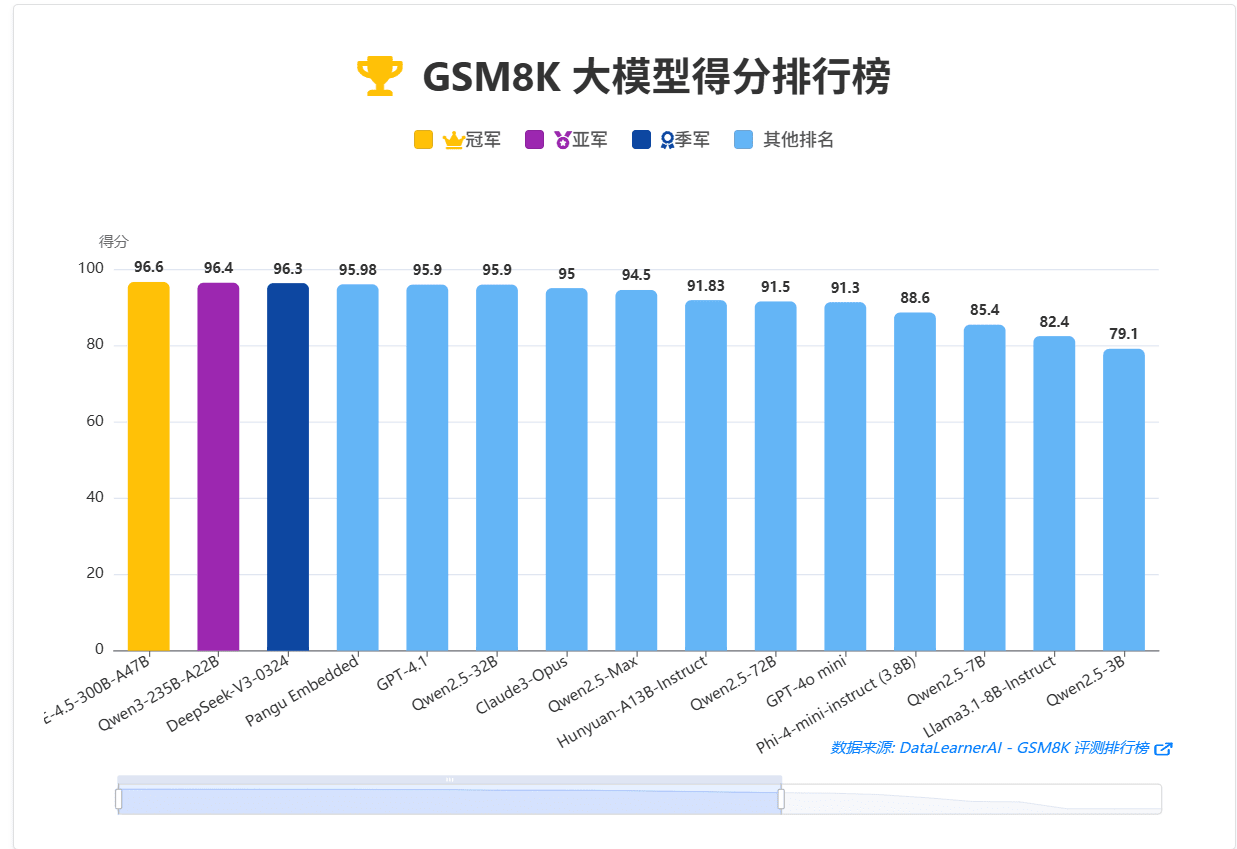

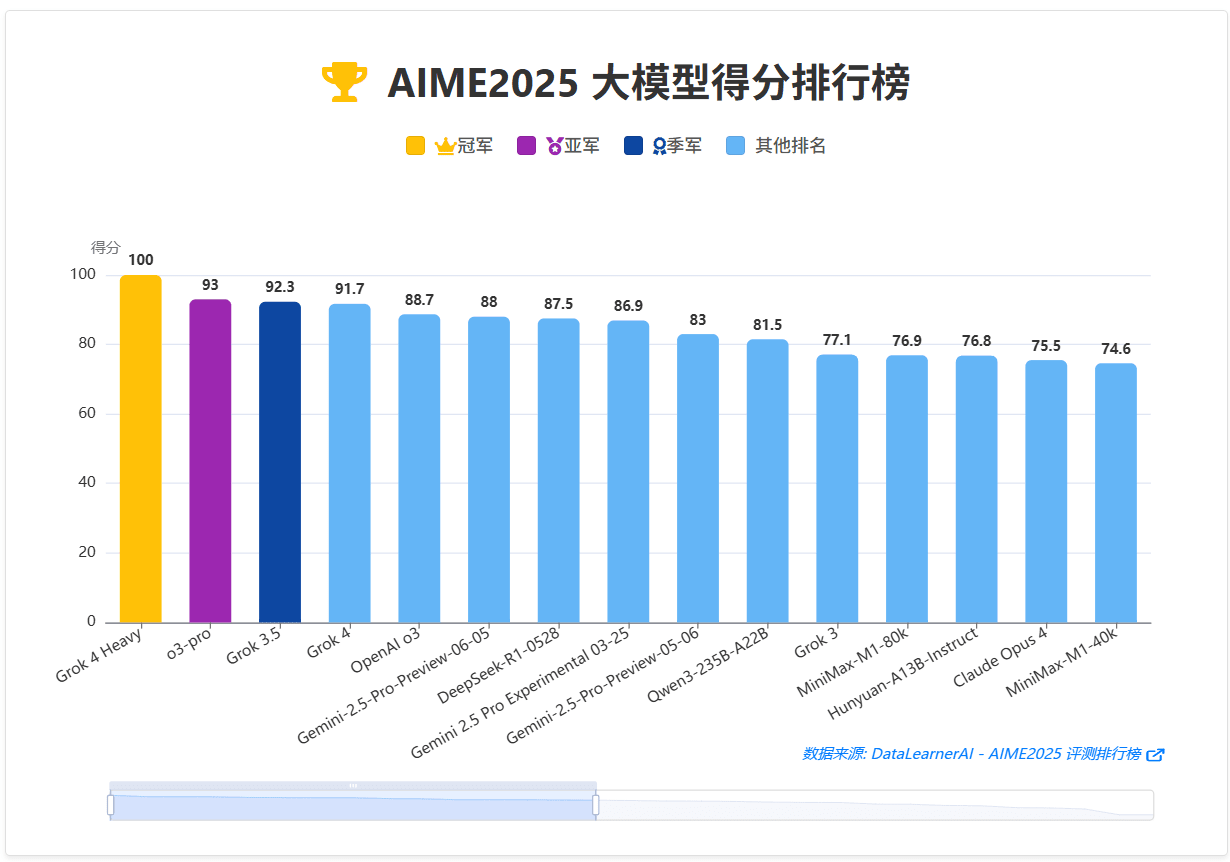

如果大家点进去这些评测其实也可以发现,早期火爆的GSM8K目前很少有新模型再去测试,因为大多数顶尖模型都可以拿到很高的分数,没有区分度。当前AIME还是比较火爆的,但是随着Grok 4 Heavy拿到满分之后,未来应该也会很少人再去测试了。

OpenAI三位核心研究员在各自的陈述中一致强调,这项成果最重要的部分并非模型在数学上的表现,而是其背后的通用方法论。

这并非一个为IMO量身定制的“偏科”模型,而是一个通用的推理引擎。其突破主要体现在以下方面:

这项工作展示了一种不依赖外部形式化工具(如代码解释器或Lean等证明助手),仅通过自然语言进行高级抽象推理的能力。研究院Sheryl也感叹大模型数学能力的提升之快:从GPT-4o在AIME测试中12%的水平,到如今的IMO金牌,仅仅过去了约15个月。

这个IMO模型是一个前沿的实验品,并非GPT-5,并且在未来数月内不会将同等级别的数学能力集成到公开发布的产品中。这揭示了其前沿研究与商业产品之间存在显著的技术代差和发布时间差。但是官方也公布了该模型的实际证明结果,大家可以去GitHub上看:https://github.com/aw31/openai-imo-2025-proofs/

尽管如此,Alexander也确认了一个好消息:GPT-5即将发布。

当AI的能力从“略低于人类专家”跨越到“略高于人类专家”的门槛时,其角色将从一个辅助工具转变为一个潜在的原创性研究伙伴。正如Sheryl和Noam所展望的,AI未来将有能力推导新的数学定理,或为科学发现做出实质性贡献。

过去,顶级AI的竞争很大程度上围绕着MMLU、GSM8K等标准化基准展开。IMO金牌的达成,为这场竞赛树立了一个新的、更高的标杆。未来的竞争焦点可能会从“谁的模型知识更广、答题更快”,转向“谁的模型能针对复杂、开放、专业的问题进行更深入、更可靠的创造性推理”。这要求AI公司展示其在解决现实世界中那些没有标准答案的难题上的能力。

总而言之,OpenAI的IMO成果不仅是一个技术里程碑,更是一个清晰的信号:前沿AI的发展重心正在从广泛的知识覆盖,深化到专精的、可验证的、类似人类的创造性推理能力。这不仅是对模型能力的重新定义,也为整个行业的演进方向设定了新的航标。