AI盛世如你所愿!昨天2个最新的开源“GPT”模型发布!

在最近的24个小时内,有2个开源的自然语言处理领域的开源预训练大模型发布。这两个模型都是类似GPT的Transformer模型,可以完成和ChatGPT类似的能力。最重要的是这2个模型完全开源!

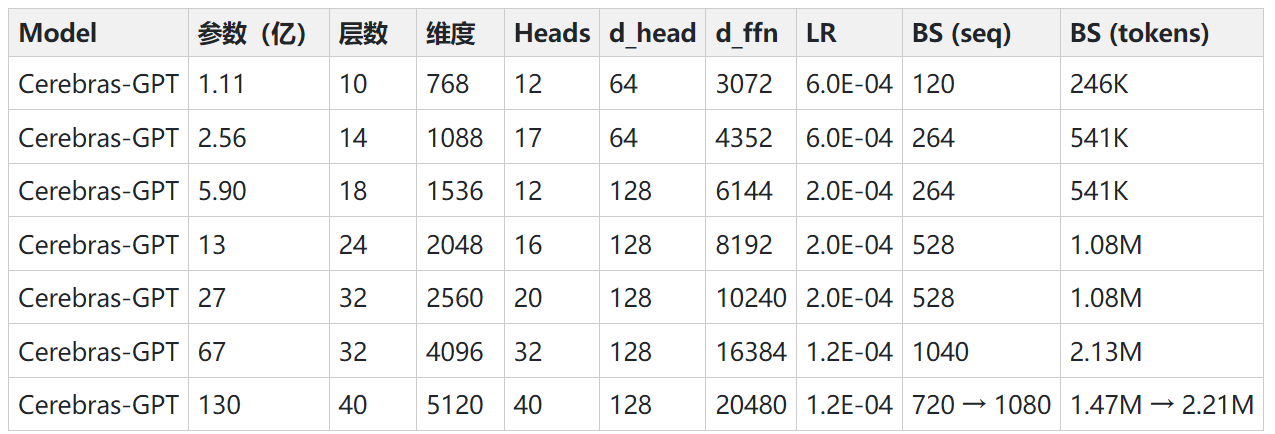

它们分别是Lightning AI公司(Lightning AI公司简介:https://www.datalearner.com/ai-organizations/Lightning-AI )发布的Lit-LLaMA和Cerebras发布的Cerebras-GPT模型。 前者是基于MetaAI开源的LLaMA模型所独立实现的可以以较低资源运行的模型,而后者则是Cerebras实现的与GPT、OPT直接竞争的大模型。

一、Lit-LLaMA简介

Lit-LLaMA是由Lightning AI发布的基于LLaMA的开源模型。官方宣称这是独立实现的模型,使用的是nanoGPT的训练框架。

Lit-LLaMA模型卡信息:https://www.datalearner.com/ai-models/pretrained-models/Lit-LLaMA