OpenAI开源最新的3D物体生成预训练模型——Point-E

三维物体的生成(3D)其实是AR/VR领域一个非常重要的技术。但是,受限于算力和现有模型的限制,三维物体的生成相比较图像生成来说效率太低。目前,最好的图像生成模型在几秒钟就可以根据文字生成图像结果,但是3D物体的生成通常需要多个GPU小时才可以生成一个对象。为此,OpenAI在今天开源了一个速度极快的3D物体生成模型——Point-E,需要注意的是,这是今年来OpenAI罕见的源代码和预训练结果都开源的一个模型。

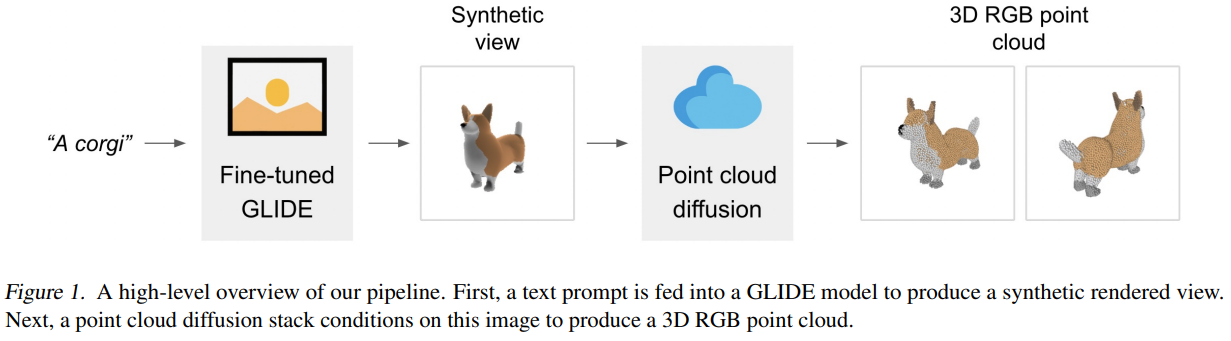

下图是一个实例:

Point-E只需要1-2分钟即可生成一个3D对象。‘

Point-E模型首先使用文本到图像的扩散模型生成一个单一的合成视图,然后使用第二个扩散模型生成一个三维点云,该模型以生成的图像为条件。虽然该方法在采样质量方面仍未达到最先进的水平,但它的采样速度要快一到两个数量级,为一些使用情况提供了实际的权衡。

下图是该模型的一个high-level的pipeline示意图: