截止目前中文领域最大参数量的大模型开源:上海人工智能实验室开源200亿参数的书生·浦语大模型(InternLM 20B系列),性能提升非常明显!

上海人工智能实验室是国内顶尖的人工智能实验室,此前在大模型领域,他们与商汤科技发布的书生·浦语系列在国内引起了很大的关注。此次,他们又开源了一个全新的200亿参数规模的大语言模型InternLM 20B,应该是截止目前中文领域开源的参数规模最大的一个大模型了。

加载中...

上海人工智能实验室是国内顶尖的人工智能实验室,此前在大模型领域,他们与商汤科技发布的书生·浦语系列在国内引起了很大的关注。此次,他们又开源了一个全新的200亿参数规模的大语言模型InternLM 20B,应该是截止目前中文领域开源的参数规模最大的一个大模型了。

欢迎关注 DataLearner 官方微信,获得最新 AI 技术推送

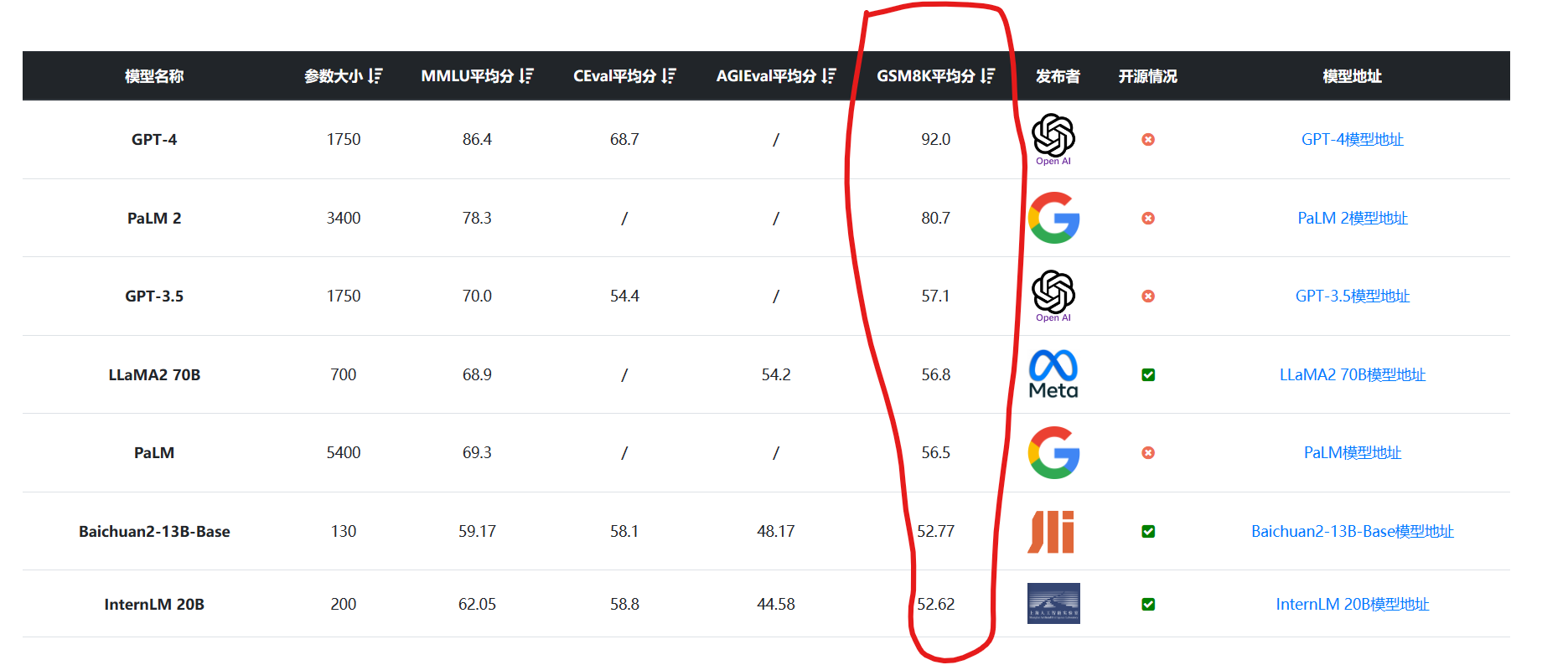

InternLM的中文是书生·浦语,这个系列的大语言模型是上海人工智能实验室与商汤科技一起训练的系列模型。在2023年6月份,他们开源了70亿参数的2个版本的模型,由于开源协议十分友好,且评测结果文档较为完善,吸引了很多人的关注。

InternLM 7B系列在上万亿tokens数据集上使用几千张GPU训练支持8K上下文长度,并在后续的更新中微调增加了代码解释和函数调用的能力。

三个月之后的9月份,他们再次开源InternLM 20B系列的2个模型,参数规模200亿。

InternLM 20B目前包含2个版本的模型,一个是基础大模型InternLM 20B(DataLeanrer模型地址:https://www.datalearner.com/ai-models/pretrained-models/InternLM-20B ),一个是针对聊天优化的InternLM Chat 20B(https://www.datalearner.com/ai-models/pretrained-models/InternLM-Chat-20B )。

InternLM20B系列在超过2.3万亿tokens上训练。数据集包含高质量的英文数据、中文数据和代码数据。其中 Chat 版本还经过了 SFT 和 RLHF 训练。

根据官方介绍,InternLM 20B 在模型结构上选择了深结构,层数设定为60层,超过常规7B和13B模型所使用的32层或者40层。

而InternLM 20B最重要的2个特性是它支持最高16K的上下文输入,同时有很强的工具调用能力!

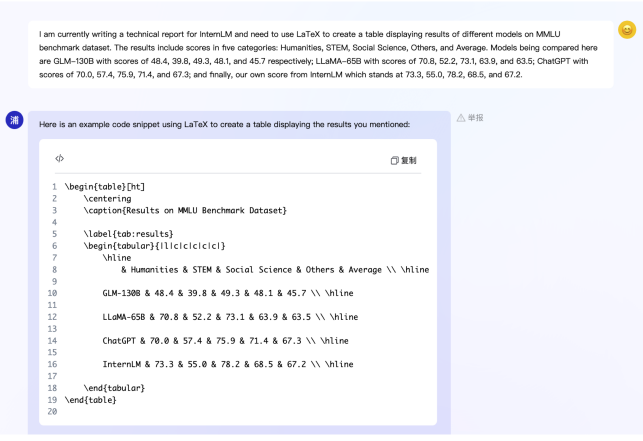

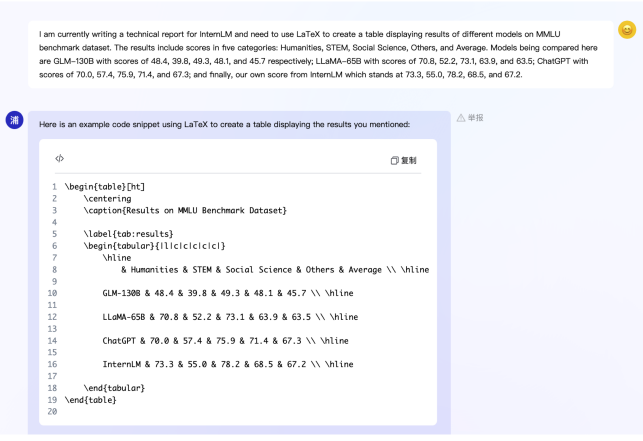

InternLM开源模型做的一个非常好的地方就是评测结果丰富程度。国内某些开源大模型虽然宣称效果很好,但是缺少很多必要的评测数据,包括著名的MMLU、AGIEval等,都信息不足。

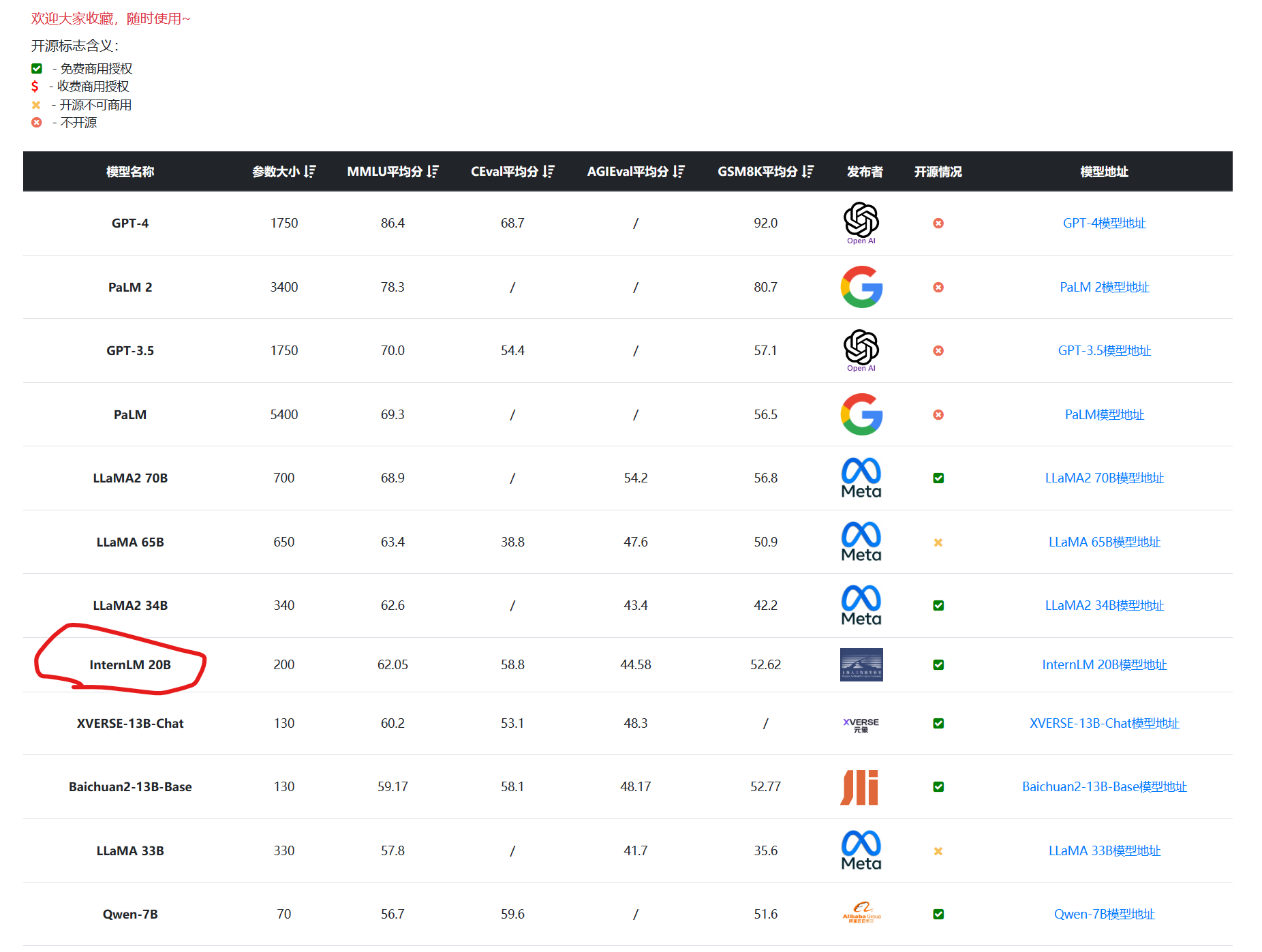

而InternLM公布了非常多的评测结果,目前也收录到了DataLearner大模型评测页面,如下是按照MMLU评分排序和GSM8K评分排序结果:

MMLU全称Massive Multitask Language Understanding,是一种针对大模型的语言理解能力的测评,是目前最著名的大模型语义理解测评之一,由UC Berkeley大学的研究人员在2020年9月推出。该测试涵盖57项任务,包括初等数学、美国历史、计算机科学、法律等。任务涵盖的知识很广泛,语言是英文,用以评测大模型基本的知识覆盖范围和理解能力。

在MMLU评分结果中,开源领域,InternLM 20B仅次于LLaMA系列的3个模型,但是这三个模型都是最低340亿参数,而且是纯英文语料训练。因此,可以说InternLM 20B在英文理解上超越了众多国产开源模型。

而在GSM8K(OpenAI发布的大模型数学推理能力评测基准,涵盖了8500个中学水平的高质量数学题数据集)中,InternLM 20B的评分仅次于Baichuan2 13B,仅有0.15分的差距,和GPT-3.5几乎一个水平,也是十分让人惊喜。

关于更像的评测对比大家参考DataLearner大模型对比评测表:https://www.datalearner.com/ai-models/llm-evaluation

InternLM 20B可以说是上海人工智能研究所发布的非常优秀的国产开源大模型了。当然,最重要的是模型完全开源,代码开源协议Apache 2.0,模型预训练结果免费商用授权,填写申请即可。具体大家参考DataLearner上InternLM 20B系列的模型信息卡:

此前,他们也开源过一个高质量2TB、几十亿条可商用的中文数据集书生·万卷,大家也可以参考:https://www.datalearner.com/blog/1051692866081331