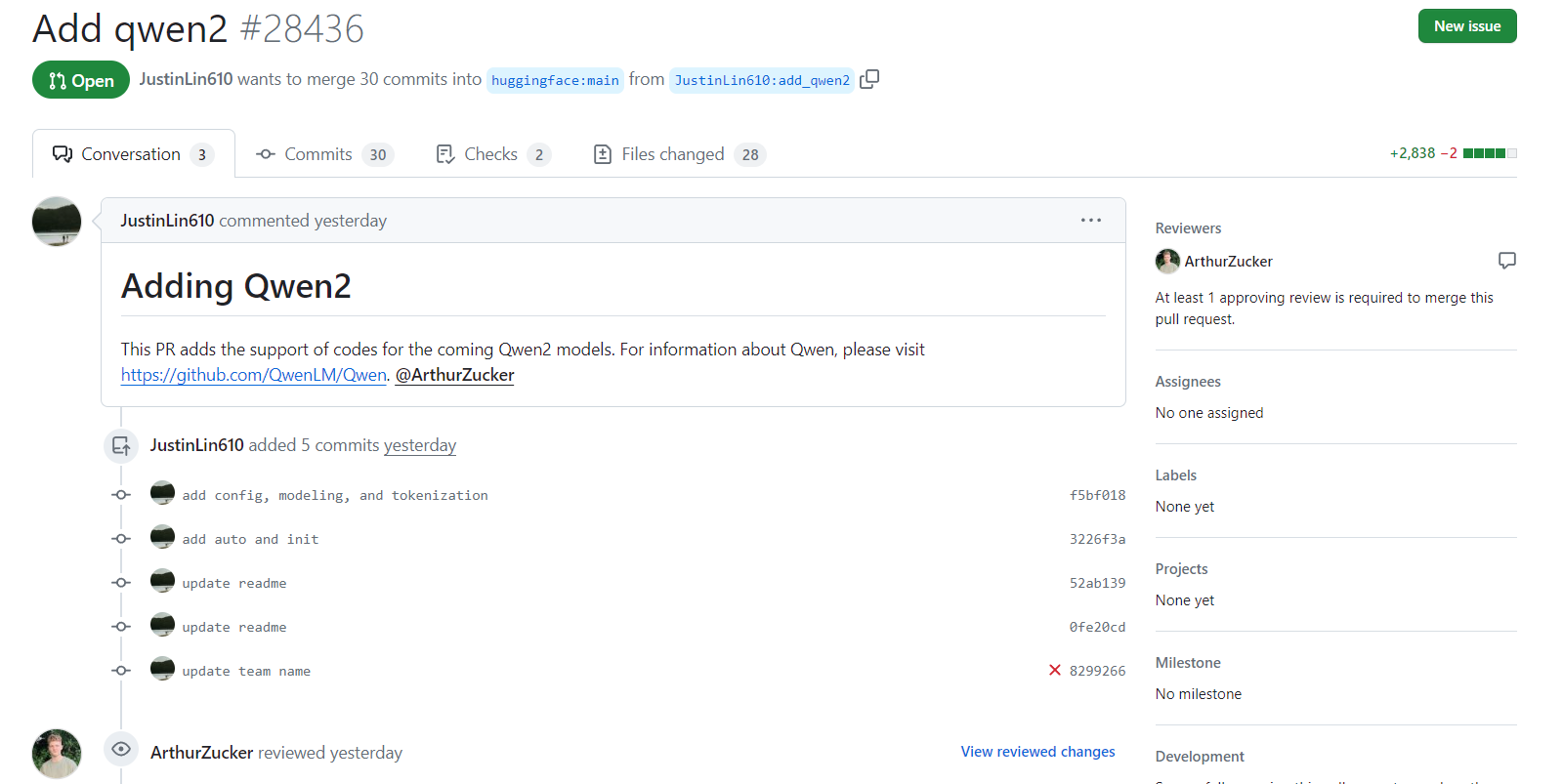

阿里巴巴的第二代通义千问可能即将发布:Qwen2相关信息已经提交HuggingFace官方的transformers库

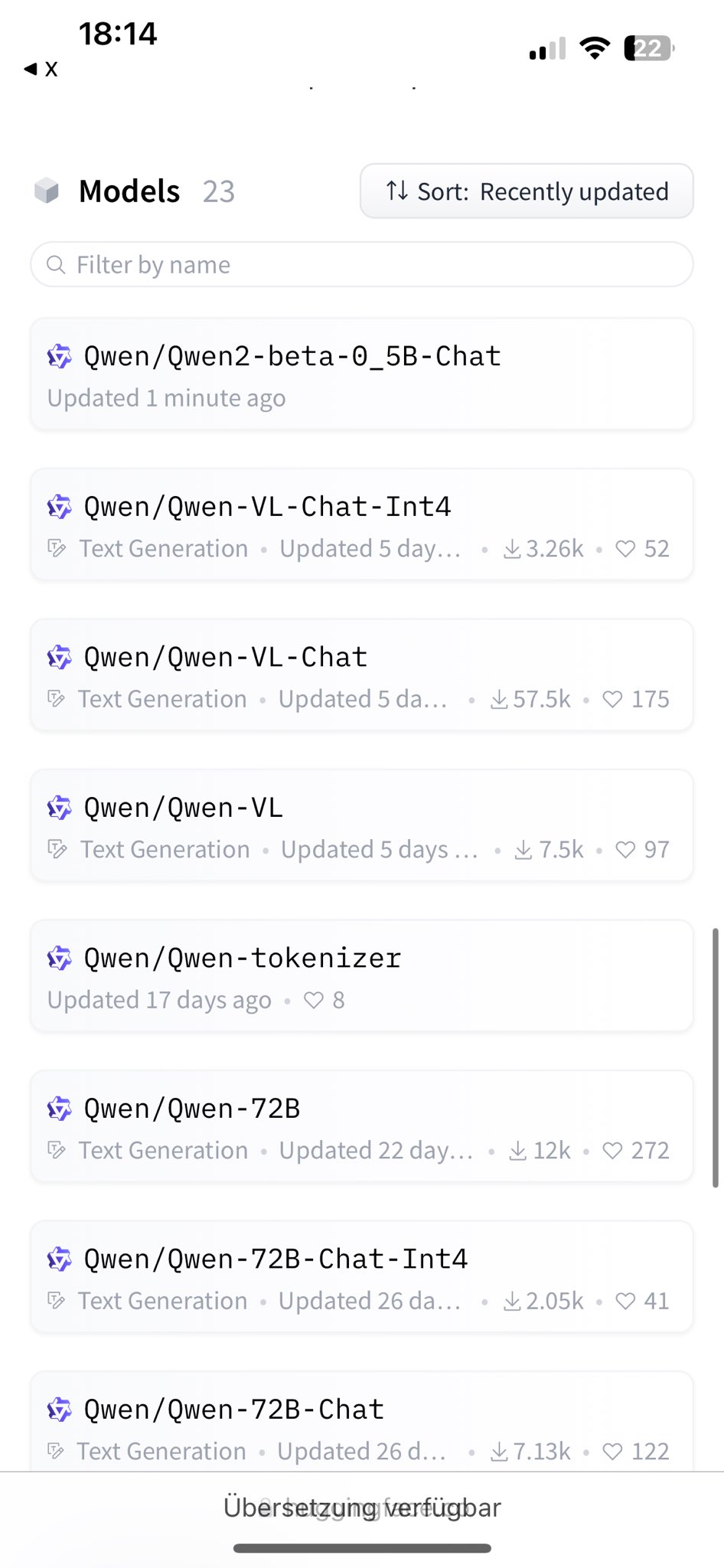

------------2023年1月31日更新------------ 在HuggingFace上发现了一个可能是5亿参数规模的Qwen2模型,其名称是0.5B,这意味着可能有一个仅需1GB显存就能允许的Qwen2模型。

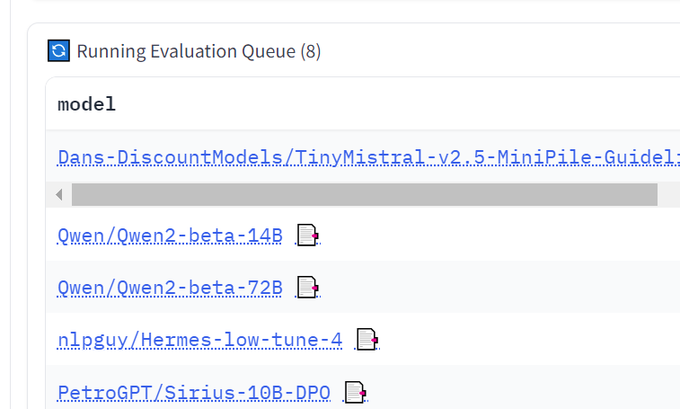

------------2023年1月30日更新------------ 有用户发现Leaderboard上有Qwen2的模型在测试,包括Qwen2-14B、Qwen2-72B,这意味着第二代的Qwen模型至少已经有70亿参数、140亿参数和720亿参数三个不同规模版本。

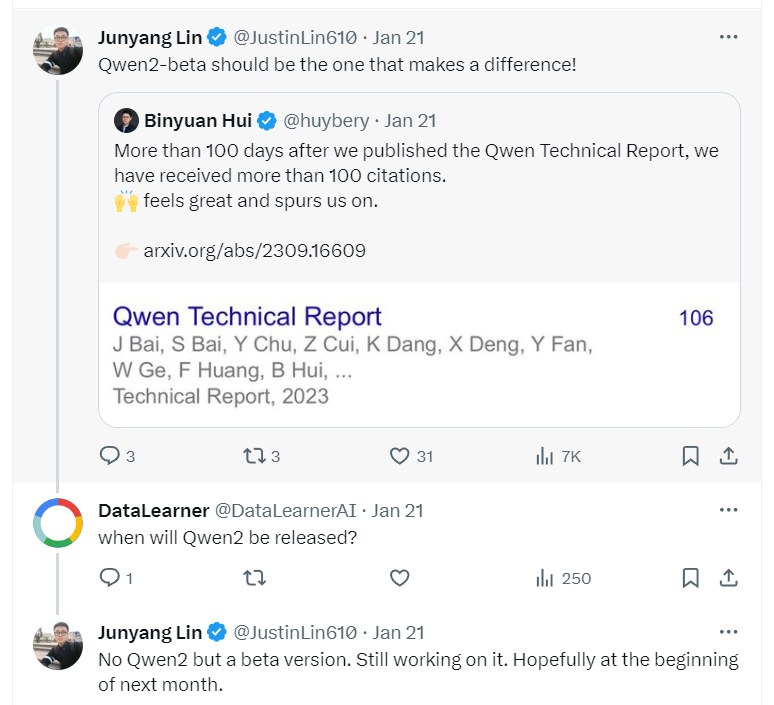

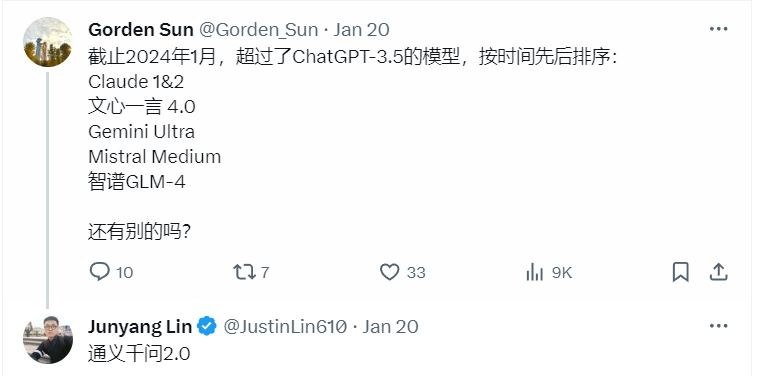

------------------------ Qwen团队成员在推特回复Qwen2目前只有beta,可能在下个月初发布。