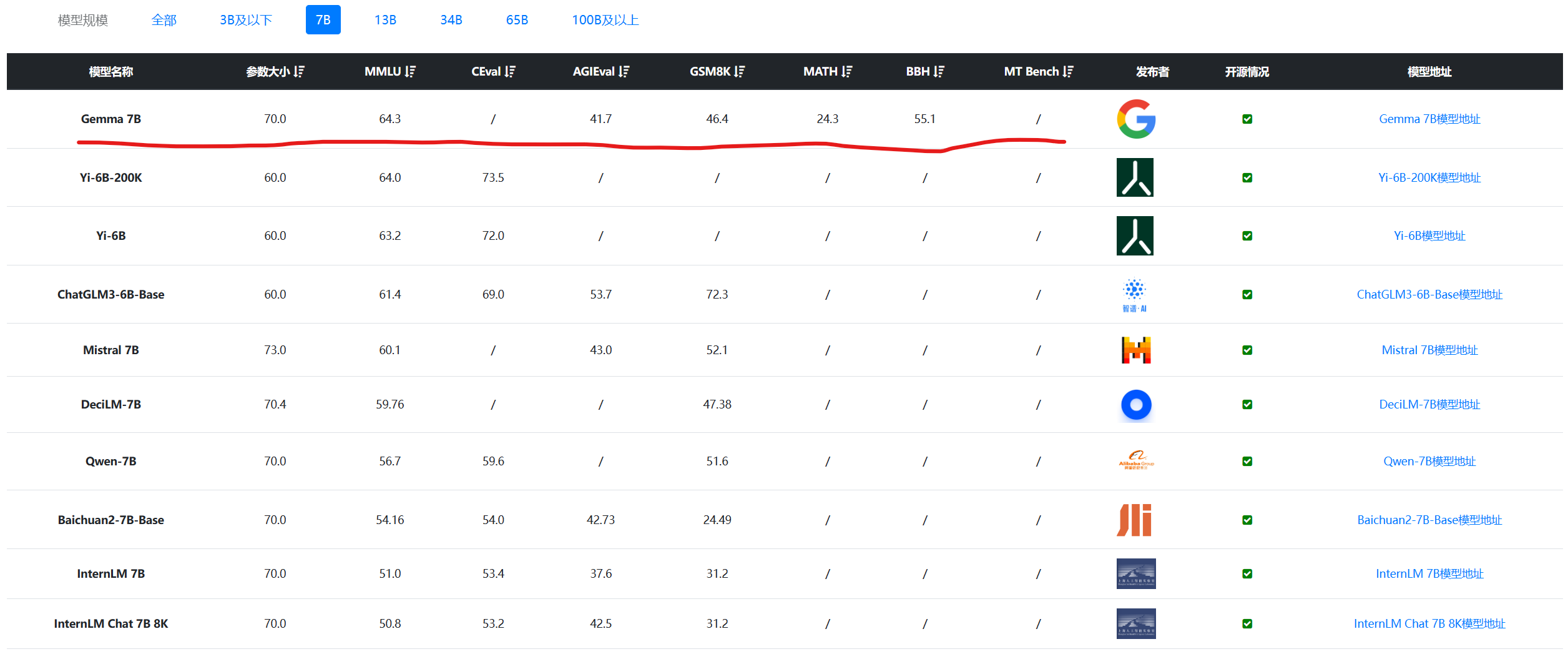

重磅!谷歌开源Gemini同源技术大模型Gemma,分别为70亿参数和20亿参数,同等规模参数评测极其优秀!

Google Gemini是谷歌最新推出的和OpenAI竞争的大语言模型。尽管Gemini褒贬不一,但是Gemini模型的影响力是巨大的。而现在更加令人激动的是谷歌开源了2个新的不同参数规模的模型,分别是Gemma 7B和Gemma 2B,其技术与Gemini模型一致。但是这两个开源模型完全公开,可以商用授权。

Gemma模型简介

Gemma模型是谷歌开源的大语言模型的名称。目前有2个不同参数规模的4个版本,分别如下: