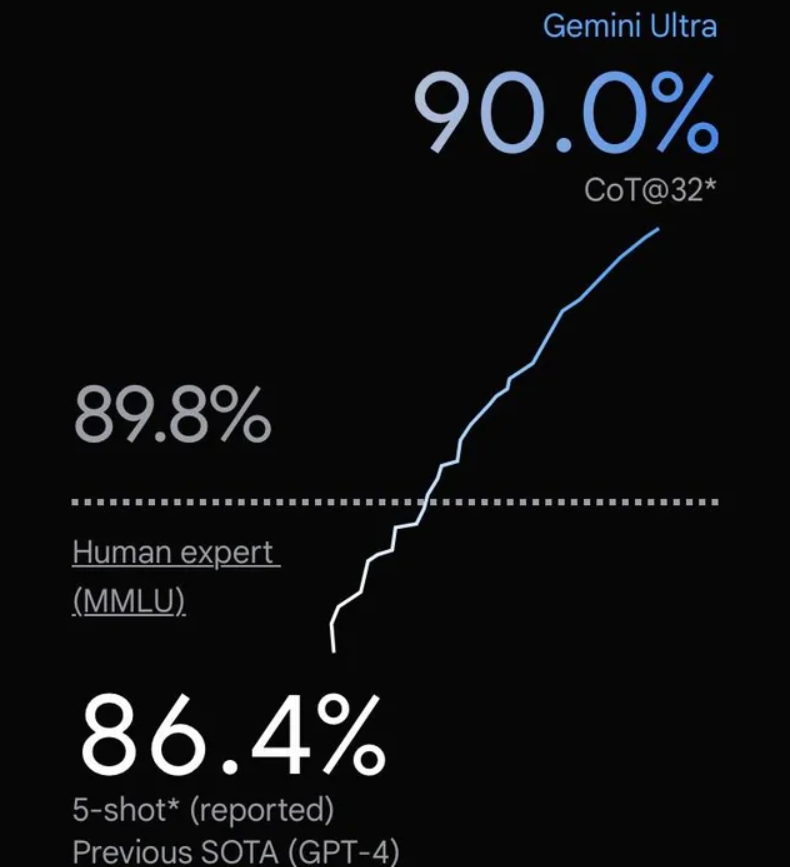

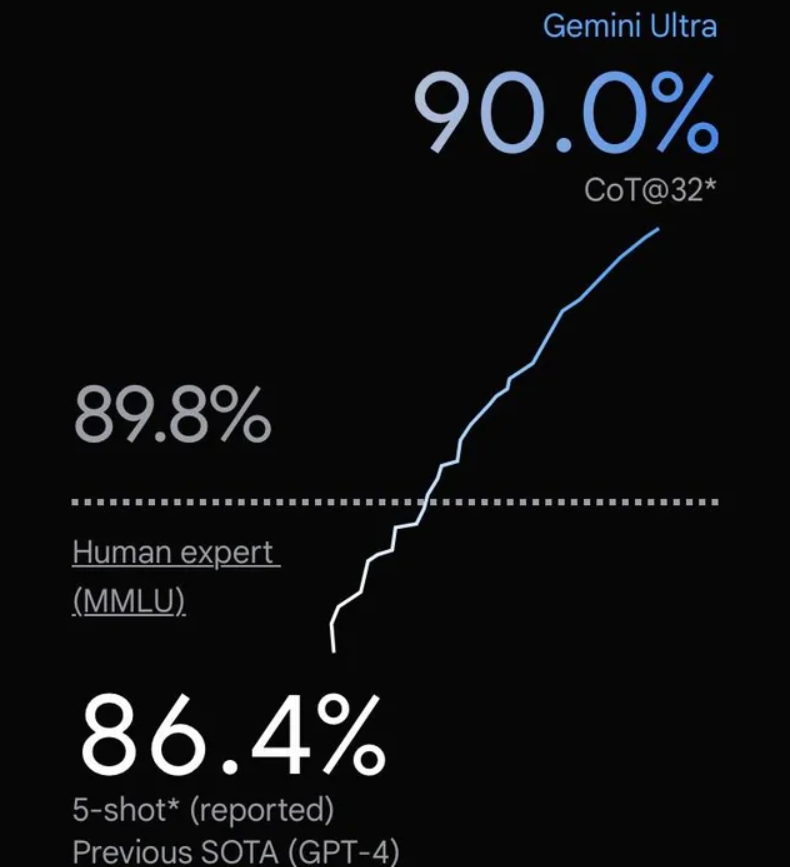

谷歌发布号称超过GPT-4V的大模型Gemini:4个版本,最大的Gemini的MMLU得分90.04,首次超过90的大模型

谷歌在几个小时前发布了Gemini大模型,号称历史最强的大模型。这是一系列的多模态的大模型,在各项评分中超过了GPT-4V,可能是目前最强的模型。

加载中...

谷歌在几个小时前发布了Gemini大模型,号称历史最强的大模型。这是一系列的多模态的大模型,在各项评分中超过了GPT-4V,可能是目前最强的模型。

欢迎关注 DataLearner 官方微信,获得最新 AI 技术推送

Gemini系列是多模态大模型,支持文本、语音、图片和视频,输出,原生支持32K的输入序列!

Gemini分为三个版本,最大的是Gemini-Ultra,然后是Gemini-Pro,最小的是Gemini-Nano;

Gemini不同版本的总结如下:

Gemini-Ultra是最大规模参数版本,没有公布具体参数,据猜测超过了3000亿规模,在科学推理、策略规划等复杂任务上具有很好的表现;

Gemini-Ultra在各项评测的结果都超过了GPT-4V;在自然语言处理相关的评测中,结果如下:

Gemini-Ultra将会在明年早些时候更新到Bard中。

Gemini-Ultra的模型信息卡地址:https://www.datalearner.com/ai-models/pretrained-models/gemini-ultra

Gemini-Pro是比Ultra小一点版本的模型,也没有公布参数,据猜测在1000亿以上,在自然语言理解、可视化、分析等方面工作能力较强;

Gemini Pro据称已经在昨天的Google Bard上更新了,有Google Bard权限的童鞋可以使用对比;

Gemini-Pro的模型信息卡地址:https://www.datalearner.com/ai-models/pretrained-models/gemini-pro

其中Gemini-Nano分为两个版本:一个是18亿参数的Gemini-Nano1,一个是32.5亿参数的Gemini-Nano2,通过在较大规模模型蒸馏得到;

Gemini-Nano部署和推理可以使用4-bit量化版本获得最好的性能和成本的平衡,目标是移动设备部署;

Gemini-Nano的模型信息卡地址:https://www.datalearner.com/ai-models/pretrained-models/gemini-nano

这部分和OpenAI一样,没有过多的细节,只知道这个模型是Decoder-only的transformer模型,但是针对谷歌的TPU和大规模训练做了优化。使用了多种不同的attention机制,包括multi-query attention。

Gemini的视频理解是通过将视频编码为大上下文窗口中的一系列帧来实现的。视频帧或图像可以自然地与文本或音频交织在一起,作为模型输入的一部分。模型可以处理可变的输入分辨率,以便在需要细粒度理解的任务上投入更多的计算资源。此外,Gemini可以直接摄取来自通用语音模型(USM)特征的16kHz音频信号。这使得模型能够捕捉那些通常在音频被简单地映射到文本输入时会丢失的细微差别。

谷歌提到Gemini-Pro模型:

我们基础设施和学习算法的内在可扩展性使我们能够在几周内完成预训练,利用的资源只是Ultra的一部分

也就是说这个Gemini-Pro只用几周就训练完了。

Gemini的训练数据来自网页文档、书籍和代码的数据,并包括图像、音频和视频数据。Gemini使用SentencePiece分词器,谷歌发现在整个训练语料库的大样本上训练分词器可以改善推断出的词汇表,进而提高模型性能。

Gemini模型可以高效地对非拉丁文字进行分词,这反过来又可以提高模型质量以及训练和推理速度。训练最大模型的令牌数量是根据Hoffmann等人(2022年)的方法确定的。

Gemin是分阶段性地训练,以在训练过程中改变数据集的成分:在训练结束时增加与域相关数据的权重。发现数据质量对于高性能模型至关重要,并且认为在寻找预训练的最佳数据集分布方面仍有许多有趣的问题尚待解决。

Gemini-Ultra在MMLU的得分上超过了90,是目前已知的最强的基座大模型,超过了GPT-4V,同时在GSM8K上获得了94.4的得分,也是目前数学能力最强的模型。

DataLearner的模型评测排行榜单收集结果如下:

可以看到,Gemini在代码评测中有76分,而GPT-4是82分,但实际上GPT-4官方公布但是67分,82分是微软测出的。谷歌官方对比用的是OpenAI官方数据。

上述两个评测排行地址来自DataLearnerAI,具体参考: DataLearnerAI大模型综合能力评测数据排行:https://www.datalearner.com/ai-models/llm-evaluation DataLearnerAI大模型代码评测数据排行:https://www.datalearner.com/ai-models/llm-coding-evaluation

具体的对比结果如下:

|评测任务| Gemini-Ultra | Gemini-Pro | GPT4 | GPT3.5 | PalLM2L | Claude2 | Inflect | Grok1 | LLAMA2 | |--------|--------|------|--------|---------|---------|---------|-------|--------| | MMLU | 90.04% | 79.13% | 87.29% | 70% | 78.4% | 78.5% | 79.6% | 73.0% | 68.0% | | GSM8K | 94.4% | 86.5% | 92.0% | 57.1% | 80.0% | 88.0% | 81.4% | 62.9% | 56.8% | | MATH | 53.2% | 32.6% | 52.9% | 34.1% | 34.4% | — | 34.8% | 23.9% | 13.5% | | BIG-Bench-Hard | 83.6% | 75.0% | 83.1% | 66.6% | 77.7% | — | — | 51.2% | | HumanEval | 74.4% | 67.7% | 67.0% | 48.1% | — | 70.0% | 44.5% | 63.2% | 29.9% | | Natural2Code | 74.9% | 69.6% | 73.9% | 62.3% | — | — | — | — | | DROP | 82.4 | 74.1 | 80.9% | 64.1% | 82.0% | — | — | — | | HellaSwag | 87.8% | 84.7% | 95.3% | 85.5% | 86.8% | — | 89.0% | 80.0% | | WMT23 | 74.4 | 71.7 | 73.8 | — | 72.7 | — | — | — |

可以看到,除了HellaSwag的评测,其它的评测结果中,Gemini-Ultra都是强于GPT-4V的。

"HellaSwag" 是一个常识推理的数据集,用于评估自然语言处理(NLP)模型的能力,特别是在生成文本和理解复杂情境的语境中。这个数据集包含了需要模型完成句子或段落,从而显示出其对世界知识的理解和预测能力的任务。这类评测通常用于测试和比较不同的语言模型,以确定它们在理解和生成自然语言方面的性能。

Gemini在多模态的能力上也很强。并且最小版本的Gemini-nano也有多模态能力,Gemini和GPT-4V在多模态的评测对比如下:

目前Gemini-Pro已经更新到Google Bard中,而Gemini Ultra将会在明年早些时候更新到Google Bard。Gemini提供API访问,大概在12月13日Google Cloud上可以申请。

| 51.1% |

| 75.1% |

| MathVista (testmin) | 53.0% | 45.2% | 30.6% | 27.3% | 49.9% |

| AI2D (test) | 79.5% | 73.9% | 51.0% | 37.9% | 78.2% |

| VQAv2 (test-dev) | 77.8% | 71.2% | 67.5% | 62.7% | 77.2% |