大模型评测的新标杆:超高难度的“Humanity’s Last Exam”(HLE)介绍

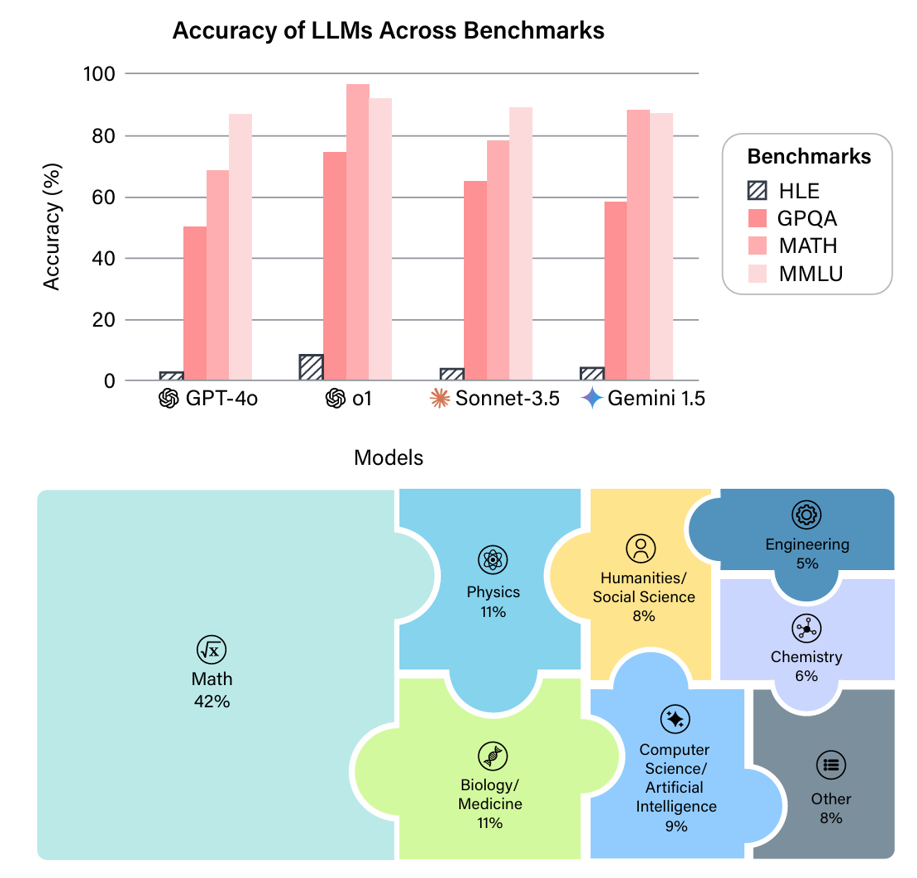

近年来,大语言模型(如GPT-4、Claude、Gemini)的能力突飞猛进,但它们是否真的接近人类专家的水平?答案可能令人意外。以广泛使用的评测基准MMLU(大规模多任务语言理解)为例,GPT-4在2023年首次发布时,其准确率仅为86.4%,但到了2025年,最新的GPT-4o在MMLU上的准确率已超过95%(图1)。这种“评测饱和”现象意味着,现有基准已无法区分顶尖模型的真实能力——就像一场考试,如果所有学生都能考满分,考试就失去了意义。为此,Safety for AI和Scale AI的研究人员推出了Humanity’s Last Exam大模型评测基准。这是一个全新的评测基准,旨在成为大模型“闭卷学术评测的终极考验”。