阿里开源Qwen3-Coder-Next:专为Agentic Coding而生的80B MoE的编程大模型,激活参数仅3B!

就在刚刚,阿里开源了全新一代编程大模型Qwen3-Coder-Next,该模型是基于Qwen3-Next-80B-A3B-Base模型后训练得到,总参数规模800亿,激活参数仅30亿。也就是说,这个模型的推理速度基本和3B这种小规模参数差不多,但是它的评测结果,特别是在编程方面的评测与DeepSeek V3.2的水平差不多。

从官方信息来看,本次开源的 Qwen3-Coder-Next 目标是“agentic coding”:即模型训练目标直接围绕“生成代码 → 执行 → 失败 → 修复 → 再执行”的闭环,而不是只优化单轮代码生成质量。

一、Qwen3-Coder-Next模型基本信息

从架构和规格上看,Qwen3-Coder-Next 是一个非常典型的“规模很大,但推理代价受控”的 MoE 模型。它的基座是此前2025年9月份开源的Qwen3-Next模型(参考:https://www.datalearner.com/ai-models/pretrained-models/Qwen3-Next-80B-A3B ),这是阿里为下一代大模型架构进行技术验证的新模型,最大的特点是极度稀疏。

而本次开源的Qwen3-Coder-Next模型的主要信息如下:

- 架构:混合注意力 + 稀疏 MoE

- 总参数量:80B

- 激活参数:约 3B / token

- 上下文窗口:256K tokens

- 专家数:该模型总的专家数是512个!非常多,但是每次推理仅激活10个专家。

需要注意的是,本次开源的Qwen3-Coder-Next并非是一个推理大模型,即输出结果中不含思考过程。

二、Qwen3-Coder-Next模型的核心特点

根据Qwen官方的信息,Qwen3-Coder-Next模型使用了80万经过验证的任务(应该是编码相关的)以及相关的可执行环境来进行后训练,在原有的 Qwen3-Coder-Next 基础上做了如下工作:

- 在编码和围绕agent相关的任务上进行后训练

- 在高质量的agent轨迹数据上做有监督微调(SFT)

- 在特定领域上进行专家训练,如软件工程、问答、UX等

- 将专家知识蒸馏到单一的模型中

其实,这个模型的基座半年前就训练完成,半年后推出的这个Qwen3-Coder-Next的大部分工作可能是这里说的数据的准备工作和专家训练上。

此前,很多编程大模型优化的是:给你一段代码 → 补全下一段。但是 Qwen3-Coder-Next 优化的是:

给你一个任务 → 写代码 → 跑测试 → 修 bug → 再跑

官方提到训练中使用了大规模可验证执行任务,也就是模型生成的代码必须真的能运行,失败就进入修复流程。

三、Qwen3-Coder-Next评测很亮眼

作为一款纯文本模型,Qwen3-Coder-Next 在编码场景下的语言处理上表现出色。它支持当前很多Agent行为,包括与下游应用的集成,例如 OpenClaw通用Agent、Qwen Code 编码专用任务、网络开发、浏览器交互以及 CLI 工具。

官方演示案例展示了其在创建聊天界面、通过 CLI 进行桌面清理、多色动画生成、亚马逊产品搜索,甚至构建五子棋游戏等任务上的熟练度。

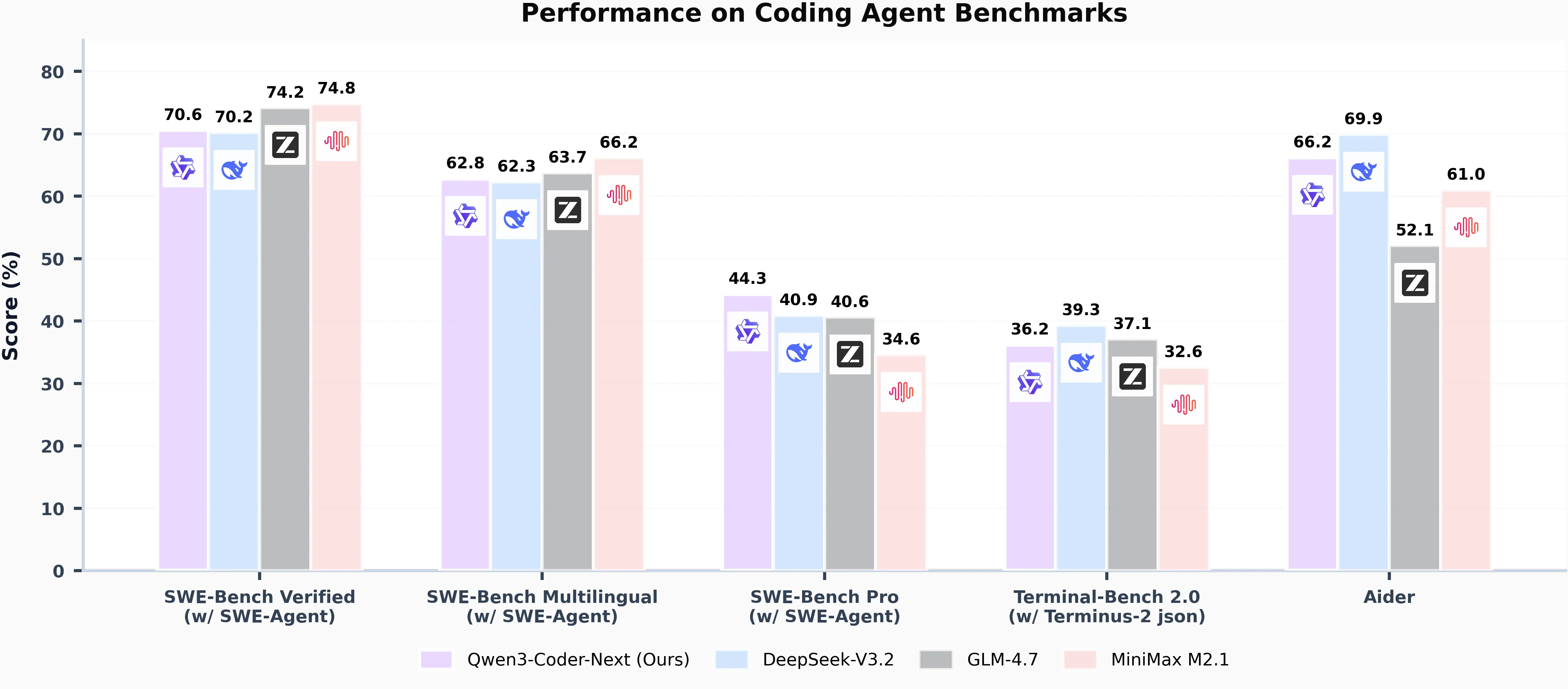

官方给出的评测数据依旧是很不错,在SWE-Bench Verified这种解决真实软件任务的评测中获得了70.6分,比DeepSeek V3.2的70.2略高。而命令行任务Terminal-Bench 2.0中得分36.2,甚至高于MiniMax M2.1,略低于智谱的GLM-4.7。

不过,根据DataLearnerAI收集的数据,有点差异,可能是因为是否选择的thinking、使用工具等有所差异,但是总体上也差不多这个趋势,多一点少一点在当前的大模型评测时代其实也没多大差异了。

不过需要注意的是其它几个模型都是通用大模型,并不是为编程专门优化的。由此可见,也许编程专用大模型在这个领域上不会比更大的同用大模型差?

此外,早期结果显示,它在自动修复和多步执行任务上的稳定性明显高于普通开源代码模型。重点不只是分数,而是失败后还能继续工作,而不是直接崩掉。

四、总结:Qwen3-Coder-Next可能代表另一种可能

Qwen3-Coder-Next 的意义不在于“又一个更大的模型”,而在于它代表一种方向:编程大模型正在从“代码生成工具”变成“自动化执行系统”。而这种模型在编程领域也许不需要那么大参数就能做的很好。

不过,如果编程助手,例如Claude Code这种进化成Cowork那种全面的助手,那么编程再好是不是也可能不够?还是需要更强的通用能力的大模型或者是混合模型部署?

Qwen3-Coder-Next依然完全免费开源,开源地址和其它更多信息参考DataLearnerAI模型信息卡:https://www.datalearner.com/ai-models/pretrained-models/qwen3-coder-next