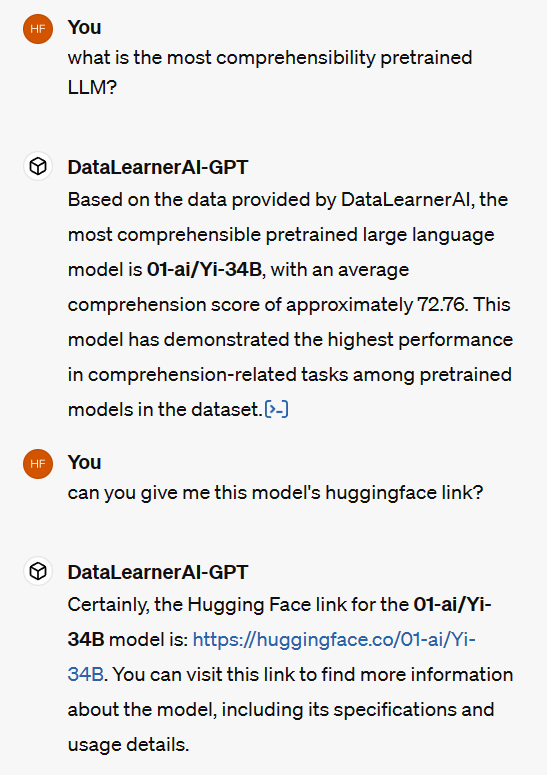

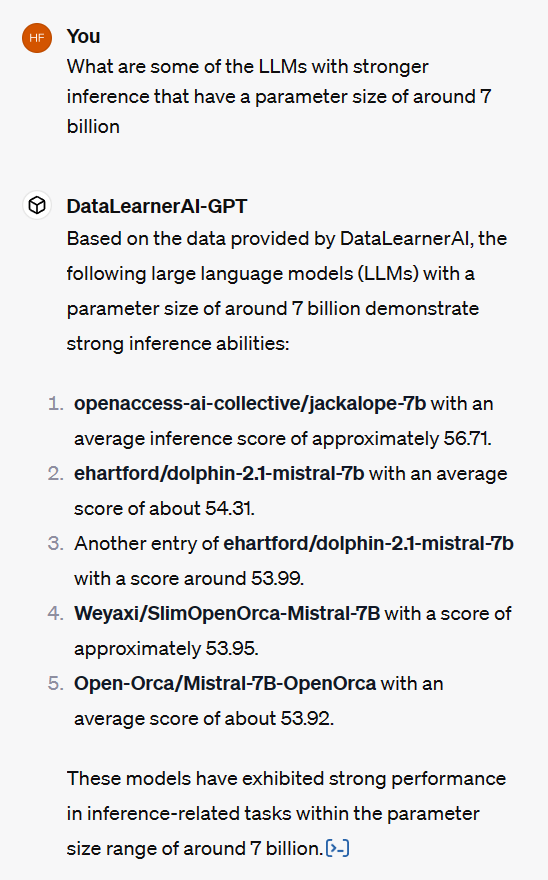

DataLearnerAI-GPT:可以回答关于大模型评测结果的GPT

最近自定义GPTs非常火热,出现了大量的自定义GPT,可以完成各种各样的有趣的任务。DataLearnerAI目前也创建了一个DataLearnerAI-GPT,目前可以回答大模型在不同评测任务上的得分结果。这些回答是基于OpenLLMLeaderboard数据回答的。未来会考虑增加更多信息,包括DataLearner网站上所有的大模型博客和技术介绍。

DataLearnerAI-GPT体验地址:https://chat.openai.com/g/g-8eu9KgtUm-datalearnerai-gpt