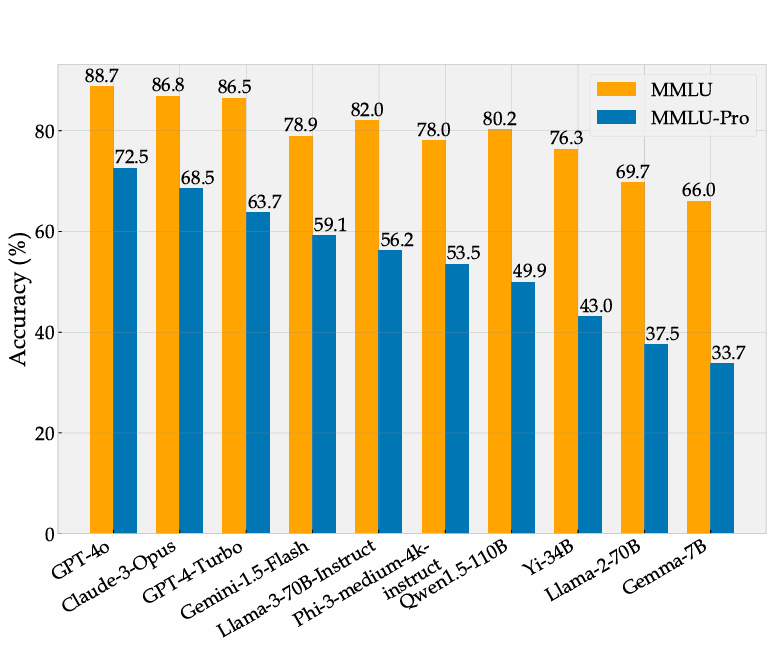

MMLU Pro大模型评测基准介绍:MMLU的进化版本,可以更好区分大模型普遍知识和推理能力的通用评测标准

MMLU Pro的最新排行参考DataLearnerAI收集的MMLU Pro大模型排行榜信息:https://www.datalearner.com/ai-models/llm-benchmark-tests/16

大模型已经对很多行业产生了巨大的影响,如何准确评测大模型的能力和效果,已经成为业界亟待解决的关键问题。生成式AI模型,如大型语言模型(LLMs),能够生成高质量的文本、代码、图像等内容,但其评测却相对很困难。而此前很多较早的评测也很难区分当前最优模型的能力。

以MMLU评测为例,2023年3月份,GPT-4在MMLU获得了86.4分之后,将近2年后的2024年年底,业界最好的大模型在MMLU上得分也就90.5,提升十分有限。

为此,滑铁卢大学、多伦多大学和卡耐基梅隆大学的研究人员一起提出了MMLU Pro版本评测基准。该评测基准采用了更高难度、更广泛的知识内容、更好区分性问题来对当前大模型进行通用能力评测。

MMLU评测的问题

在当前的大模型评测系统中,MMLU是被最广泛采用的评测基准。MMLU(Massive Multitask Language Understanding)评测基准旨在全面衡量模型在多个不同领域中的语言理解和推理能力。该基准由华盛顿大学和斯坦福大学的研究人员提出,主要用于评估语言模型在多任务、多领域的知识推理和理解能力。MMLU包括了57个不同的任务,涵盖了多个学科和领域,任务种类繁多,涉及从基础常识推理到复杂的学术性问题。