2025年2月27日,微软正式发布了其全新系列的大型语言模型——Phi-4系列。这一系列包含了三个创新性的模型:Phi-4-Mini、Phi-4-Multimodal和一款经过推理优化的Phi-4-Mini。此次发布的模型不仅在性能上展现出色,更在多模态能力与推理任务中实现了显著突破。其中,Phi-4-Multimodal是一个仅仅包含56亿参数规模的多模态大模型,但是支持文本、语音、图片的输入,十分强大。

微软开源Phi-4 mini系列大模型

微软开源Phi-4 mini系列大模型

欢迎关注 DataLearner 官方微信,获得最新 AI 技术推送

微软发布的Phi-4系列模型总体介绍

在本次发布的Phi-4系列中,微软推出了三款具有不同特点的模型,每款都在特定领域表现出色。

首先,Phi-4-Mini是一款体积紧凑、但在数学推理和编程任务中具有强大能力的语言模型,能够在较小的参数量下与更大规模的模型一较高下。其参数规模38亿,但是评测上与很多70亿参数规模的模型不相上下。

其次,Phi-4-Multimodal将文本、视觉和语音/音频三种输入模态有效结合,通过创新的Mixture-of-LoRAs技术,能够同时处理多种输入方式,且在多个多模态任务中表现出色。

最后,Phi-4-Mini的推理优化版本进一步增强了其在逻辑推理和复杂问题求解方面的能力,充分利用了高质量推理数据集进行训练。可以理解为当前开源的最小参数规模版本的推理大模型了。

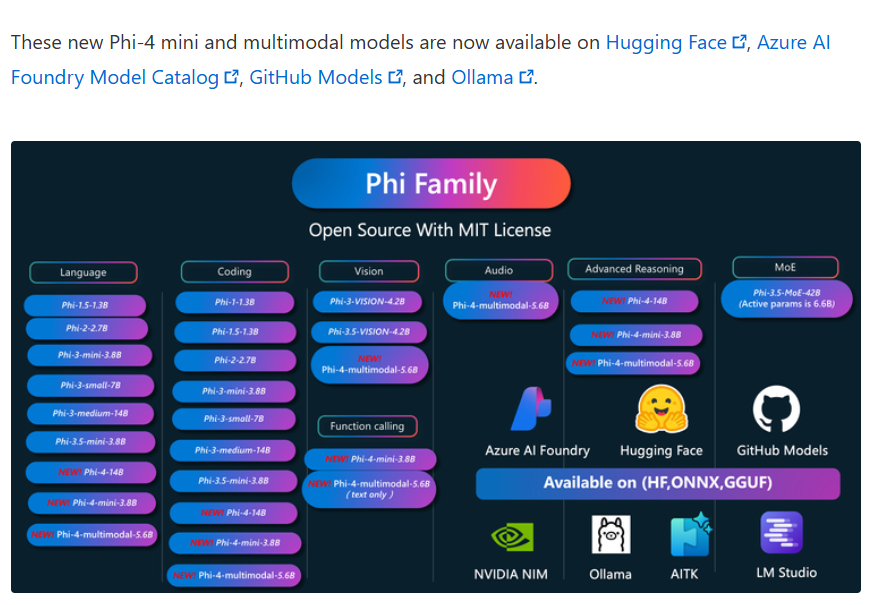

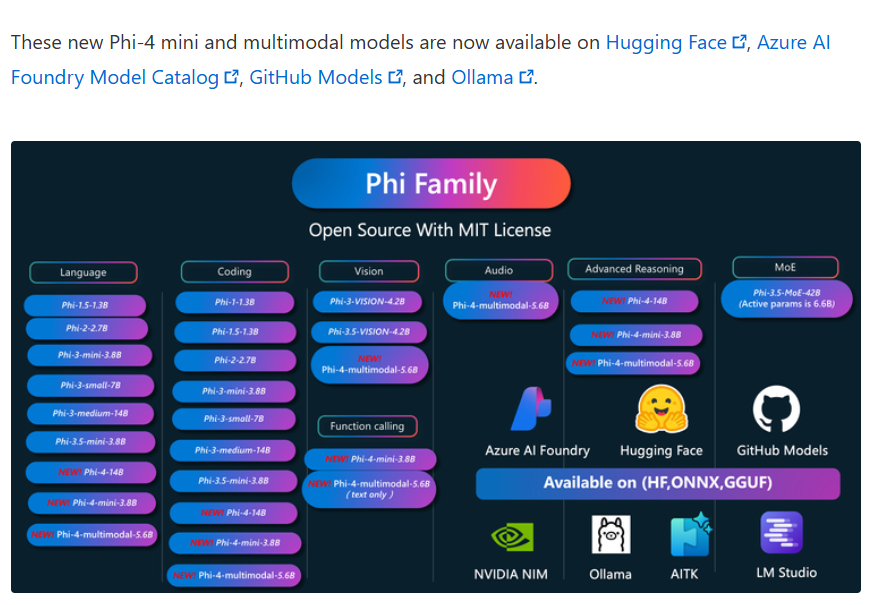

本次发布的三个模型均为MIT开源协议,意味着可以免费商用。

Phi-4-Mini(3.8B):紧凑且强大的语言模型

Phi-4-Mini是一款仅有38亿参数的语言模型,尽管参数量较小,但其在数学、编程以及复杂推理任务中的表现,堪比更大规模的模型。这款模型的出色表现得益于微软在训练数据上的精心设计,尤其是针对数学和编程任务的高质量数据集,使得Phi-4-Mini能够快速解决涉及复杂推理和代码编写的任务。该模型在5万亿数据上进行预训练,其词汇表达到了20万,具体参数如下:

Phi-4-Mini的表现超越了许多类似大小的开放源代码模型,并与更大模型在特定领域的任务表现相当。例如,在数学任务中,Phi-4-Mini在某些测试中的成绩已经接近甚至超越了7B级别的大型模型。其在编程任务上的表现也值得称道,尤其是在代码生成、调试和文档编写任务中,帮助开发者提高工作效率。

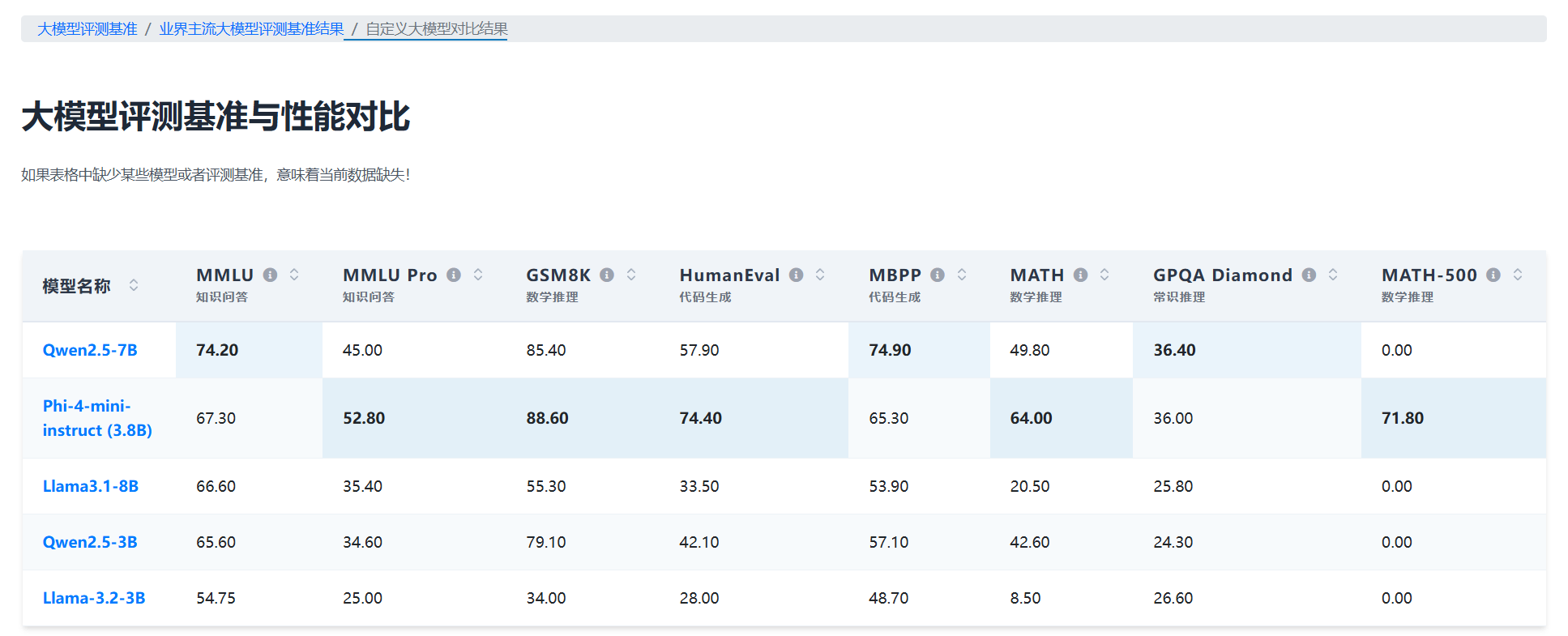

下图展示了DataLearnerAI上Phi-4-mini大模型与其它同级别大模型的对比结果:

上图中,我们可以清晰看到Phi-4-mini的强悍,除了在个别评测上不如Qwen2.5-7B外,它在其它评测上都是最强的。特别是数学推理能力上,远超同类别甚至更大规模的模型。

Phi-4-Multimodal:引领多模态任务的新标准

Phi-4-Multimodal是微软首次推出的多模态模型,它不仅支持文本输入,还能够处理图像和语音/音频输入。通过创新性的Mixture-of-LoRAs技术,Phi-4-Multimodal能够在同一个模型中集成不同类型的输入,不仅不会降低语言处理能力,还能提升多模态任务的执行效率。它的文本模型底座就是前面的Phi-mini-4,外加多模态模型训练得到。

Phi-4-multimodal-instruct最大特色在于:

- 多模态能力:支持同时处理文本、图像与音频信息。

- 128K上下文长度:相比于之前的模型,Phi-4支持更长的上下文处理。

- 多语种支持:该模型支持包括英语、中文、法语、德语等在内的22种语言,且在语音处理上支持7种语言。

Phi-4采用了多模态Transformer架构,具有56亿参数,并结合了先进的视觉和语音编码器。其训练数据包括:

- 5万亿个文本

- 230万小时的语音数据

- 11亿个图像-文本配对数据

- 训练时间为28天,使用了512个A100-80G GPU进行分布式训练。训练数据的截止时间为2024年6月,因此其基于的知识库无法涵盖2024年6月之后的新信息。

根据报告,Phi-4-Multimodal在多个多模态基准测试中取得了优异成绩。在单图像的视觉-语言任务中,Phi-4-Multimodal的表现超越了许多开源的视觉-语言模型,特别是在图表理解和科学推理任务中,效果也是很不错的。其在语音识别和语音翻译任务中的表现也极为出色,具体来说:

- 在自动语音识别(ASR)和语音翻译(ST)性能上表现突出,超越了专家级ASR模型WhisperV3和ST模型SeamlessM4T-v2-Large。

- 在Huggingface OpenASR排行榜上排名第一,词错误率为6.14%,相比目前最佳模型的6.5%(截至2025年1月17日)。

- 是第一个开源的能够执行语音总结的模型,其表现接近GPT4o。

- 在语音问答任务上与类似模型(如Gemini-1.5-Flash和GPT-4o-realtime-preview)存在差距,相关改进工作正在进行中,预计将在下一版本中增强该能力。

Phi-4-Mini(推理优化版):突破推理能力的极限

推理优化版的Phi-4-Mini是一款特别为逻辑推理任务进行调优的模型。在模型训练过程中,微软为Phi-4-Mini引入了大量高质量的推理数据,特别是链式思维(Chain-of-Thought,CoT)数据,从而使得该模型在处理复杂的推理任务时展现出超乎寻常的能力。尽管该模型的参数量仍保持在38亿级别,但其推理表现已经达到或超越了许多7B及以上的模型,尤其是在多步推理和逻辑推理的测试中表现出色。

为了提升Phi-4-Mini的推理能力,微软使用了60亿个推理CoT(链式思维)数据进行预训练,并通过采样过滤不正确的输出,以确保推理数据的高质量。训练过程中还包括了大约200K个精选的高质量CoT样本,用于多领域的推理任务。其与业界其它大模型推理能力对比:

此版本的Phi-4-Mini被训练来处理包括科学推理、数学问题以及更广泛的复杂问题解决任务,能在许多需要推理的任务中展现出令人印象深刻的准确性和逻辑性。

Phi-4 mini系列大模型的总结

从这次发布的三款模型来看,微软的Phi-4系列展示了在不同领域的技术突破和创新。Phi-4-Mini的推理能力及数学编程表现,不仅证明了小型语言模型在高效推理任务中的潜力,也为资源有限的应用场景提供了强有力的解决方案。Phi-4-Multimodal则标志着即使是很小参数规模的大模型,也能做多模态的理解,尤其是在图像与语音结合的任务中,它能够无缝处理多种输入模态,开创了将多模态任务融为一体的新篇章。

更为重要的是,微软在这三款模型中的创新设计,尤其是Mixture-of-LoRAs和推理优化技术,展现了它们在提升模型多任务处理能力和推理能力方面的巨大潜力。这些技术为未来的AI发展奠定了坚实的基础,也为研究人员和开发者提供了一个更强大、更灵活的工具。

总的来说,微软的Phi-4系列大模型为当前的人工智能领域注入了新的活力。随着未来更多数据集和任务的加入,预计这些模型将继续突破更多瓶颈,不仅在学术研究中发挥重要作用,也将在商业应用中带来显著的影响。微软的这些进展,无疑为AI领域的多模态整合和推理能力的提升指明了方向。

百度在周末发布了2个新一代文心一言大模型,分别是没有推理能力的ERNIE 4.5以及有推理能力的ERNIE X1,即日起可以免费使用