加载中...

加载中...

Follow DataLearner WeChat for the latest AI updates

2025年3月25日,DeepSeekAI低调开源了DeepSeek-V3-0324大模型。作为DeepSeek-V3的重要升级版本,该模型在推理能力、中文写作、前端开发以及功能调用等多个关键领域实现了显著提升。在MMLU Pro等评测上,已经成为了非推理大模型中最强的模型,部分评测结果超过GPT-4.5模型。

根据模型提供的配置信息,DeepSeekV3-0324依然是MoE大模型,包含256个路由专家和1个共享专家,每个token使用8个专家推理。DeepSeekV3-0324通过RoPE可以扩展到最高163840上下文长度(160K)。模型词汇表大小是129280个。与DeepSeekV3相比,这些参数都没有变化,这意味着大概率是原有模型继续训练或者后训练的结果~

尽管模型架构等技术方面没有变化,但是相比较DeepSeek V3,DeepSeek V3-0324升级却很多,核心是推理能力显著增强。主要总结如下:

针对开发者关心的代码生成质量方面,DeepSeekV3-0324的能力显著增强,主要包括:

在第二点中,已经有多人一句话生成了800行前端网页,很美观。如下图所示:

在官方的介绍中,DeepSeek V3-0324在文本生成质量方面也有明显提示,看介绍应该是用了R1生成的结果做了后训练:

此外,在多轮对话和交互方面也有提升:

为了支持更好的联网生成效果,DeepSeek V3-0324在报告类请求的分析深度和输出细节方面也有增强,具体来说有如下2点提升:

最后,DeepSeek V3-0324在函数调用方面也有了优化,主要修复了此前V3版本中的函数调用准确性问题,这意味着在构建AI Agent应用中,DeepSeek V3-0324可能会有更好的效果,具体包含:

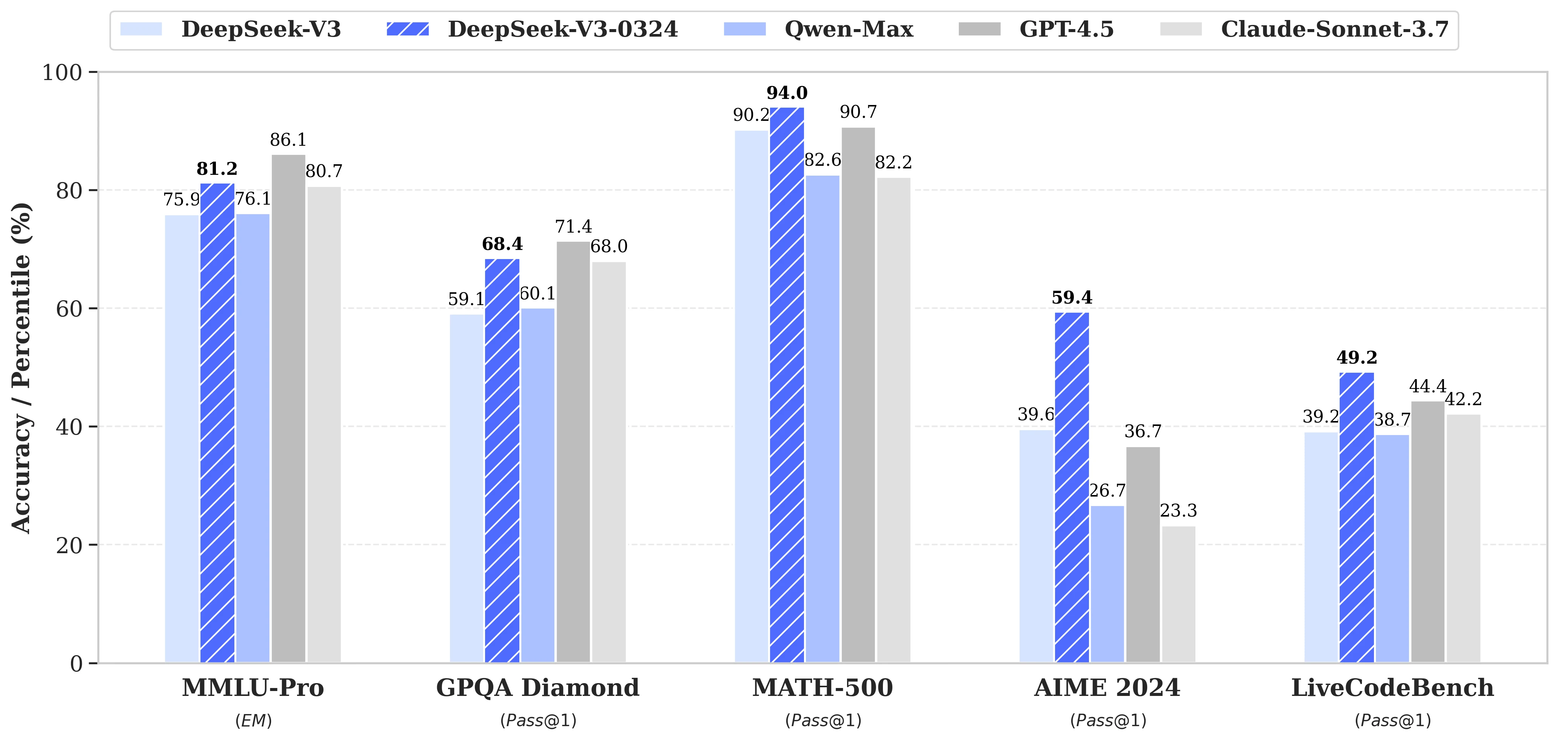

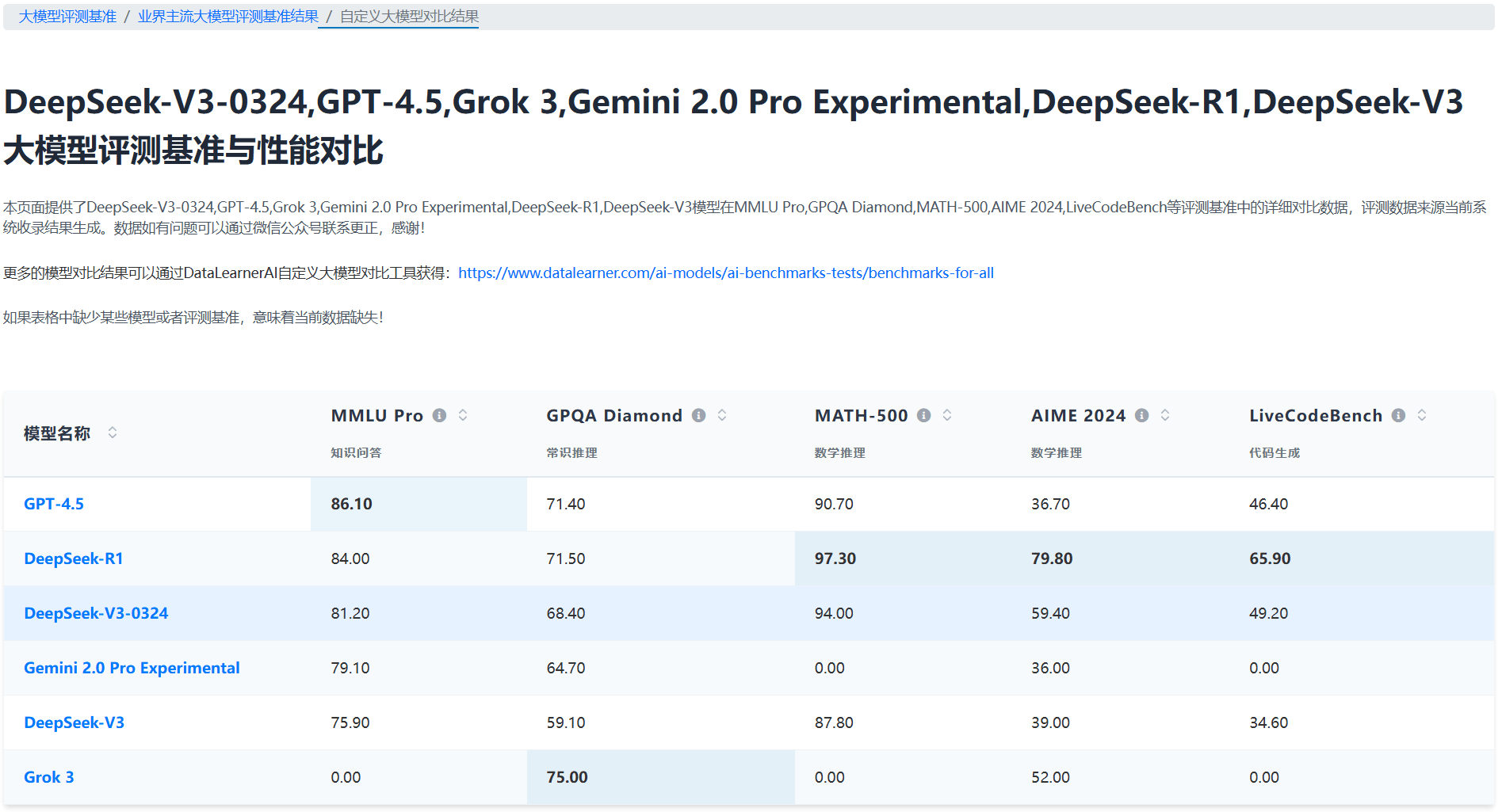

DeepSeek-V3-0324在多个权威基准测试中展现出突破性进步,相比较DeepSeek V3,DeepSeek V3-0324在多个评测指标中都有显著提升:

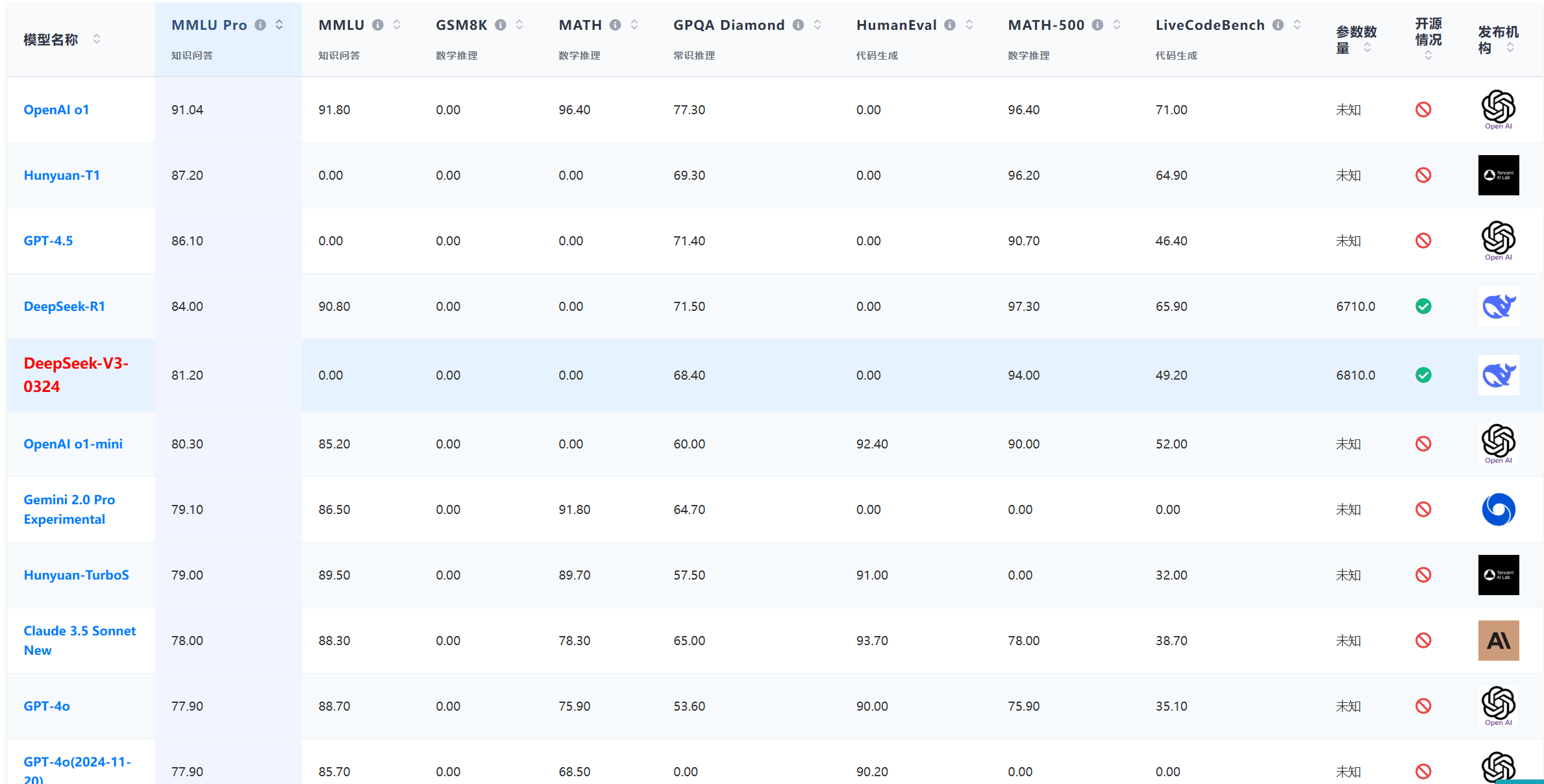

而根据DataLearnerAI的大模型官方评测排行榜,以MMLU Pro这种高难度综合知识评测为例,DeepSeek V3-0324已经是仅次于GPT-4.5的非推理大模型。

甚至,在AIME2024的评测中,DeepSeekV3-0324甚至超过了Grok3,成为仅次于DeepSeek-R1的模型。

而在LiveCodeBench的编程方面也是非常强悍!

值得注意的是,API调用采用了创新的温度参数映射机制。

在大模型服务接口中,模型的温度参数(Temperature)直接影响输出的随机性:

许多开发者习惯直接使用 API 默认参数(通常为 temperature=1.0),但 DeepSeek-V3 的最佳实践表明,T=0.3 在多数场景下能提供更稳定、可靠的输出。直接沿用默认值可能导致输出质量波动。为此,如果开发者设置的温度值是0-1之间,官方会默认乘以0.3的系数,也就是如果你接口设置的温度参数为1,那么实际用的是0.3,如果你设置的温度超过了1,那么官方会默认帮你减去0.7。

DeepSeek-V3-0324此次升级并非简单的参数调整,而是在模型核心能力上实现了多维突破。特别是在专业领域推理(GPQA +9.3)和医学推理(AIME +19.8)方面的显著提升,使其在垂直领域的应用价值大幅提高。温度参数的智能映射机制和搜索模板的规范化,也体现出产品团队对用户体验的深度思考。

关于DeepSeek V3-0324模型可以在官网免费使用(关闭深度思考),它的开源地址和其它信息参考DataLearnerAI的模型信息卡地址:https://www.datalearner.com/ai-models/pretrained-models/DeepSeek-V3-0324