加载中...

加载中...

Follow DataLearner WeChat for the latest AI updates

GLM-4.1V-Thinking是智谱AI(Zhipu AI)与清华大学KEG实验室联合推出的多模态推理大模型。这款模型并非简单的版本迭代,而是通过一个以“推理为中心”的全新训练框架,旨在将多模态模型的能力从基础的视觉感知,推向更复杂的逻辑推理和问题解决层面。多模态理解能力接近720亿的Qwen2.5-VL-72B。

本次发布的模型有2个版本,分别是基础版本的GLM-4.1V-Base和带推理能力的GLM-4.1V-Thinking。

GLM-4.1V-Thinking 的发布并非孤立事件,它伴随着一个基础模型 GLM-4.1V-9B-Base 共同开源。也是智谱训练模型的一个顺序。首先,智谱构建一个潜力巨大的视觉语言基础模型GLM-4.1V-9B-Base,再通过精细化的对齐和强化学习,充分释放其在复杂任务上的推理潜能。

该模型的核心亮点可以概括为以下几个方面:

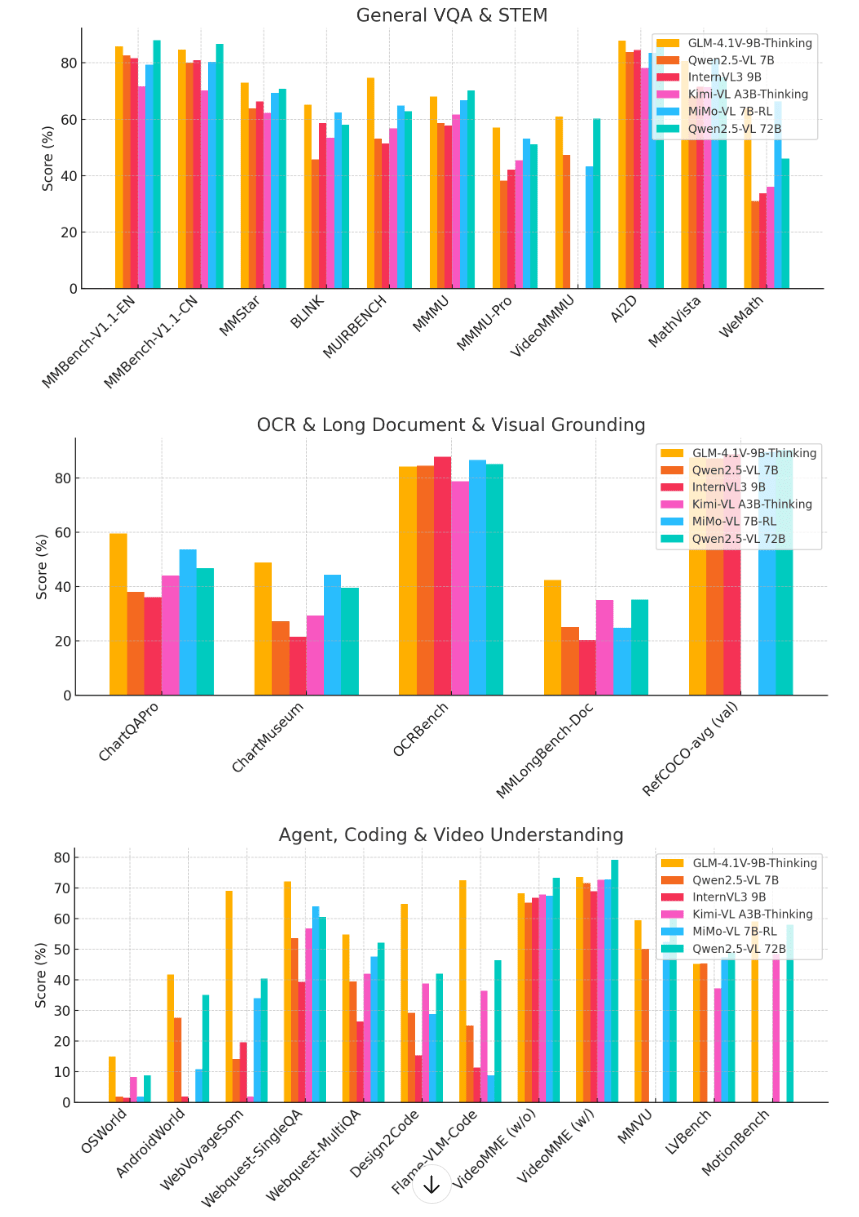

GLM-4.1V-Thinking 在横跨8大类、28个主流多模态基准测试中的表现非常惊喜。

从这个评测结果数据中,我们可以看到下面几个关键情况:

智谱开源的这个多模态推理大模型一个很重要的创新是引入了**可扩展强化学习与课程采样(Reinforcement Learning with Curriculum Sampling, RLCS)**机制,我们简单介绍一下。

传统的多模态模型在经过监督微调(SFT)后,虽然能理解指令并生成内容,但在处理需要多步骤、长链条思考的复杂问题时,往往力不从心。智谱AI认为SFT阶段的核心作用并非注入新知识,而是将模型的输出格式与人类期望的“思考过程(<think>)+最终答案(<answer>)”对齐。这一步仅仅是“扶上马”。

要让模型学会如何“跑得好、跑得远”,就需要强化学习(RL)阶段。RL通过一个精密的奖励系统,对模型的每一步思考和最终答案进行评估和反馈,引导模型自主探索更优的解题路径,从而真正提升逻辑推理的质量和准确性。

强化学习的挑战在于效率和稳定性。如果训练样本过于简单,模型学不到新东西;如果过于困难,模型又会因频繁受挫而难以收敛。RLCS 正是为此而设计。

该机制巧妙地融合了“课程学习”(Curriculum Learning)的思想,即由易到难地安排学习内容。它在训练过程中实时评估每个样本对于当前模型的难度,并动态调整采样策略:

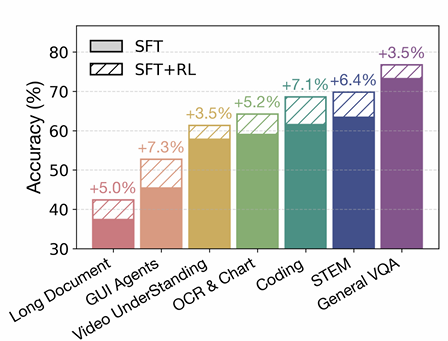

通过这种动态的“因材施教”,RLCS 显著提升了训练效率和模型的性能上限。技术报告中的数据显示,在引入RL后,模型在多个任务上的准确率获得了高达 +7.3% 的巨幅提升,直观地证明了该框架的有效性。

上图清晰展示了,相较于仅经过SFT的模型,增加了RL训练后,模型在各个维度的能力均得到了实质性增强。

GLM-4.1V-Thinking 的发布,为多模态领域的研究和应用注入了新的活力。最关键的是,这两个模型都是MIT开源协议开源的,意味着可以完全免费商用!且消费级显卡也能部署!(18GB显存以上,量化后可以期待更低显存资源)

关于GLM-4.1V-9B模型的开源地址和在线演示地址可以参考DataLearnerAI的大模型信息卡:

GLM-4.1V-9B-Thinking:https://www.datalearner.com/ai-models/pretrained-models/GLM-4_1V-9B-Thinking GLM-4.1V-9B-Base:https://www.datalearner.com/ai-models/pretrained-models/GLM-4_1V-9B-Base