正则化和数据增强对模型的影响并不总是好的:The Effects of Regularization and Data Augmentation are Class Dependent

1,494 阅读

正则化是一种基本技术,通过限制模型的复杂性来防止过度拟合并提高泛化性能。目前的深度网络严重依赖正则化器,如数据增强(DA)或权重衰减,并采用结构风险最小化,即交叉验证,以选择最佳的正则化超参数。然而,正则化和数据增强对模型的影响也不一定总是好的。来自Meta AI研究人员最新的论文发现,正则化是否有效与类别高度相关。

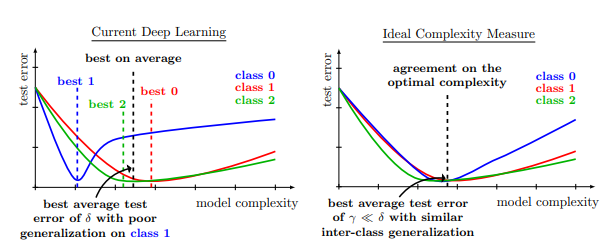

下图就是一个例子,当模型使用了某些正则化技术之后(例如DA),不同类别最优结果对应的模型复杂度是不一样的。也就是说,虽然在大多数类别上表现很好,但是依然有一些类别表现很糟糕。

在这项研究中,作者证明了DA或权重衰减等技术产生了一个复杂度降低的模型,该模型在不同类别中表现不同。从交叉验证中发现的最佳DA或权重衰减量在某些类别上会导致灾难性的模型表现,例如,在Imagenet的resnet50上,仅通过在训练期间引入随机的DA,"谷仓蜘蛛 "的分类测试精度就从68%下降到46%。更令人惊讶的是,这种性能下降也出现在引入无信息的正则化技术,如权重衰减。这些结果表明,我们对不断提高泛化性能的追求--在所有类别和样本上的平均值--使我们的模型和正则化器在某些类别上默默地牺牲了性能。这种情况在将模型部署到下游任务时可能变得很危险,例如,在Imagenet预训练阶段引入随机DA时,部署在INaturalist上的Imagenet预训练resnet50在类#8889上的表现从70%下降到30%。这些结果表明,设计没有类别依赖性偏差的新型正则器是一个非常重要的问题。

arXiv原文: