最近一段时间深度学习大模型的重要进展(2022年4月初)

今晚已经是本周的最后一天了,最近的一些深度学习算法方面的进展做个总结吧,感觉都是挺不错的,供大家参考。

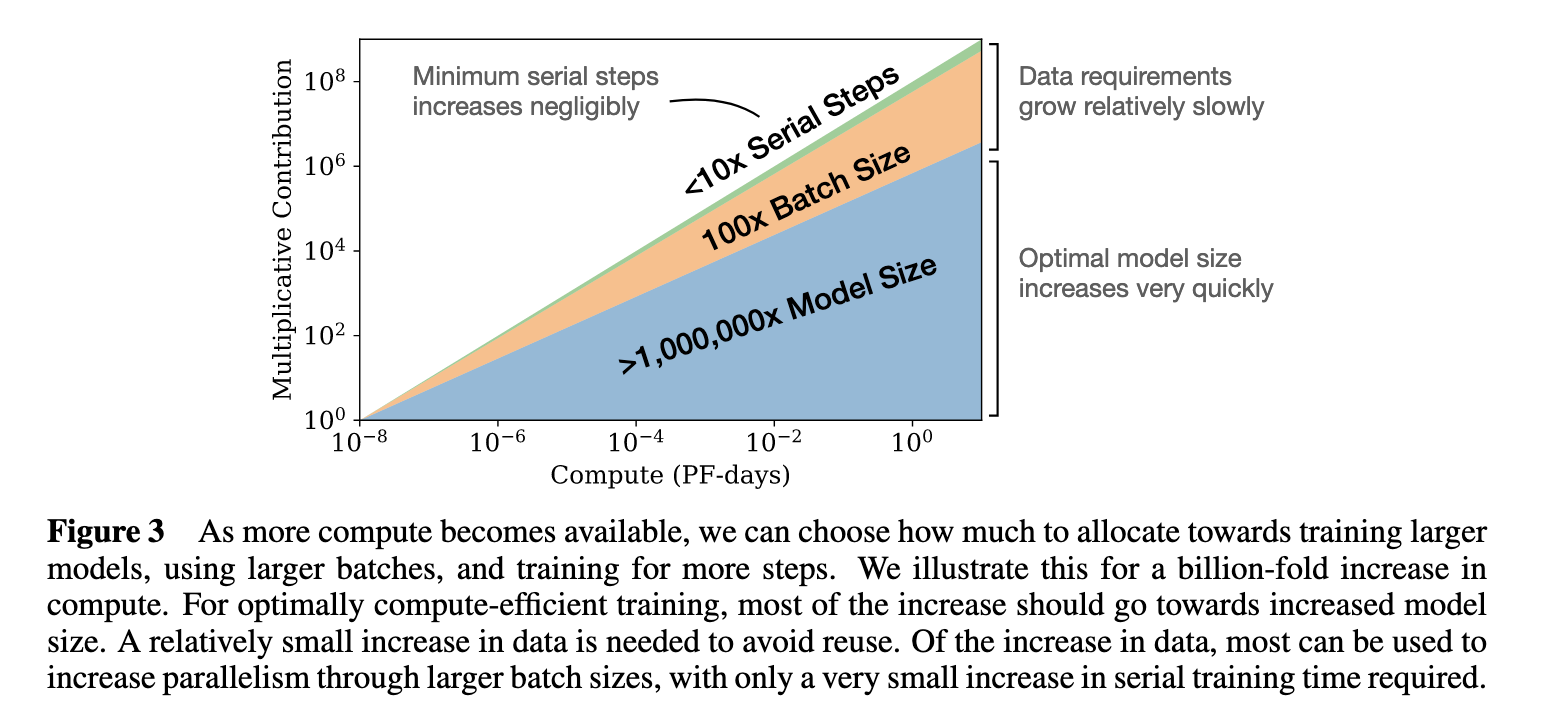

一、Chinchilla:更少参数的模型,更好的效果

首先是DeepMind提出的新的关于新的模型大小规律的论文,他们认为可以用较少参数的模型配合一定的数据获得更加优秀的模型性能,所提出的Chinchilla模型,参数700亿,但是性能超于了几千亿参数的Gopher、GPT-3等;

更多参考:https://www.datalearner.com/blog/1051649049249455

二、谷歌新系统Pathways首秀:5400亿的超大语言模型PaLM

其次是谷歌的PaLM,这是一个文本生成的预训练模型(5400亿参数),最大的特点是利用谷歌最新的深度学习加速器Pathways系统训练的,PaLM展示了Pathways系统的首次大规模使用,将训练扩展到6144个芯片,这是迄今为止用于训练的最大的基于TPU的系统配置;

更多详情:https://www.datalearner.com/blog/1051649127577094

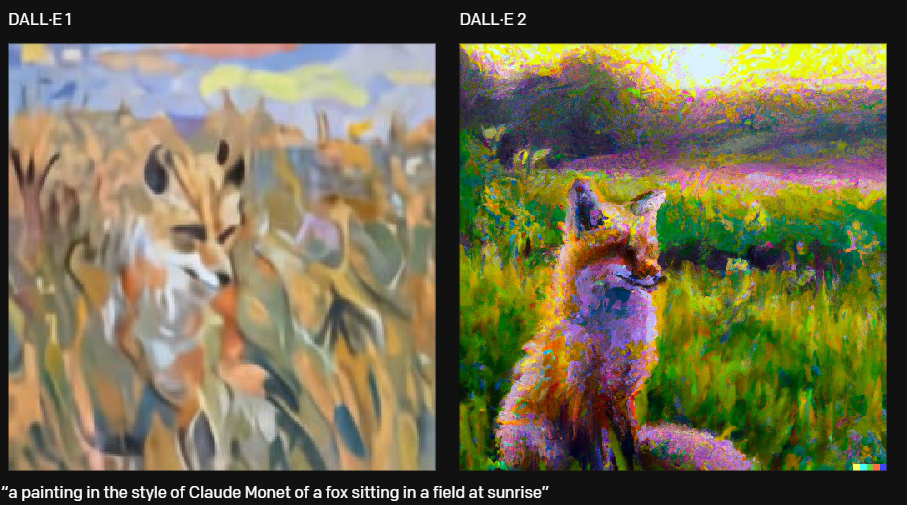

三、更加经验的图像生成模型,第二代DALL·E2

然后是OpenAI的DALL·E2,第二代的图像生成模型,更加逼真的风格和丰富的元素,效果简直令人经验,不仅可以是写实的照片,也可以是某种艺术风格的绘画,甚至有人那它设计了to-do list的界面,HTML进度条,比手残的我强太多。

更多详情:https://www.datalearner.com/blog/1051649258738940

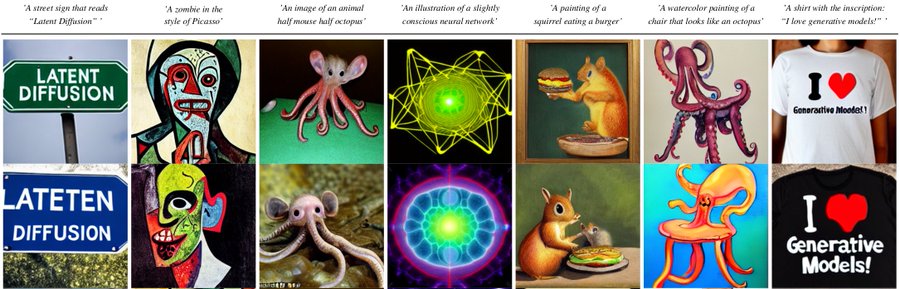

四、文本合成的新高度:扩散模型的最新能力Latent Diffusion Models

接下来是CompVis(VQGAN背后的团队,来自德国海德堡大学研究小组,Ruprecht-Karls-University)发布的新的图像扩散模型(Diffusion Models)。DMs是变分自编码器模型(Variational Auto-Encoder,VAE)的一类,通过将图像的形成过程分解为去噪自动编码器的连续应用过程,OpenAI团队发现,它生成图片的质量效果比GAN模型更加优秀。这次的模型是一个14.5亿参数的模型,在LAION-400M数据集上训练(NeurlPS2021)。从公布的图片来看,它似乎具有前所未有的文本合成能力。在图片上合成文字是最大的亮点,它可以在任意复杂的图片场景下合成新的文字内容,非常自然(看样子以后设计师出图或者后期在电影植入广告方便了)。

有很多人尝试了这个模型,合成文本的确非常优秀。

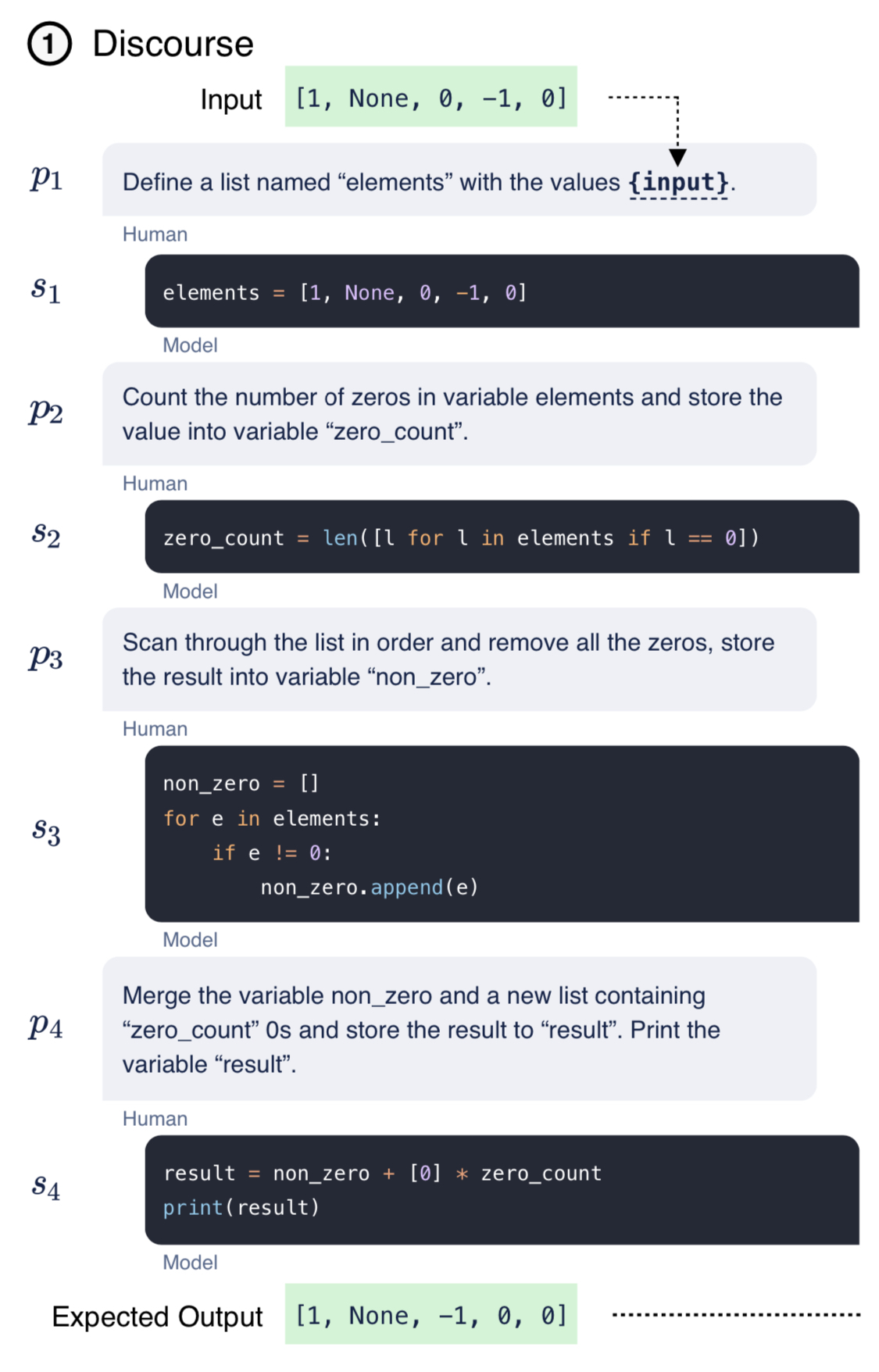

五、会写代码的语言模型:CodeGen

Salesforce的研究人员在前几天提交了一个非常有意思的论文,它可以把自然语言直接转换成代码。他们的提出的CodeGen模型是一个大型的语言模型,是一种会话式的语言模型。CodeGen使编程像说话一样简单,可以将英文描述转换为可用的Python代码—这将允许任何人编写代码,即使他们没有编程经验。

更多详情:https://www.datalearner.com/blog/1051648967411619

尽管自然语言的描述有一定限制,但已经比代码好多了。

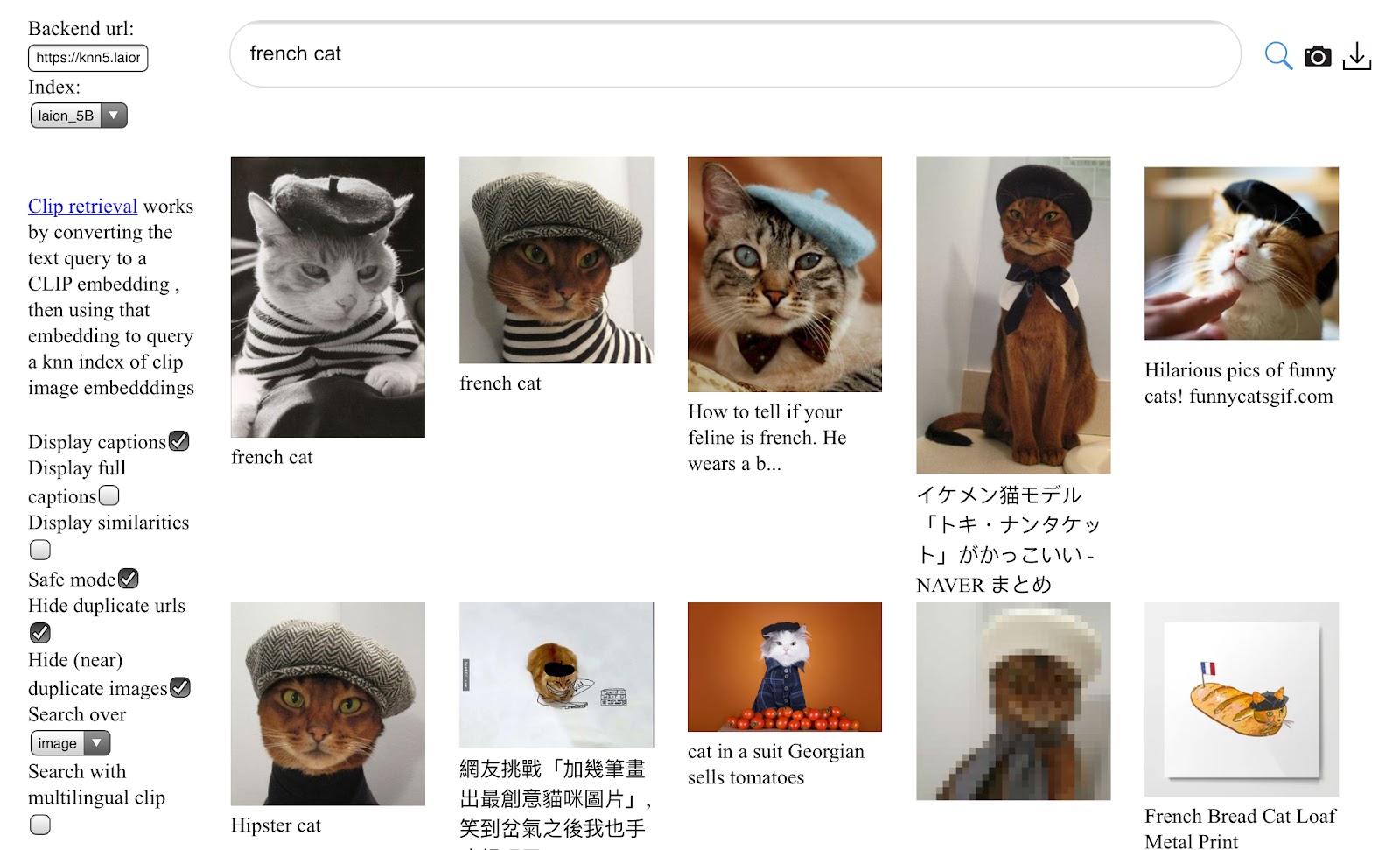

六、新一代超大规模多模态数据集LAION 5B!58.5亿条图像-文本对数据

是的,你没看错,58.5亿条图像-文本对组成的数据。比LAION-400M大14倍,LAION-400M是之前世界上最大的公开访问的图像-文本数据集。

像ALIGN、BASIC、Turing Bletchly、FLORENCE和GLIDE这样的大型图像-文本模型与之前的旗舰模型如CLIP和DALL-E相比,表现得越来越好。它们中的大多数都是在数十亿的图像-文本对上训练出来的,不幸的是,直到现在还没有这种规模的数据集公开可用。为了解决这个问题,Christoph Schuhmann等人提出了LAION 5B,一个用于研究目的的大规模数据集,包括58.5亿个经过CLIP过滤的图像-文本对(CLIP是OpenAI的一个模型工具,判断文本与图像关联度的),其中23亿样本是英语,22亿样本来自100多种其他语言,10亿样本有不允许某种语言分配的文本(例如名字)。目前数据集已经公布在Hugging Face上(Hugging Face发展真是不错)。