大型语言模型的新扩展规律(DeepMind新论文)——Training Compute-Optimal Large Language Models

3月29日,DeepMind发表了一篇论文,"Training Compute-Optimal Large Language Models",表明基本上每个人--OpenAI、DeepMind、微软等--都在用极不理想的计算方式训练大型语言模型。论文认为这些模型对计算的使用一直处于非常不理想的状态。

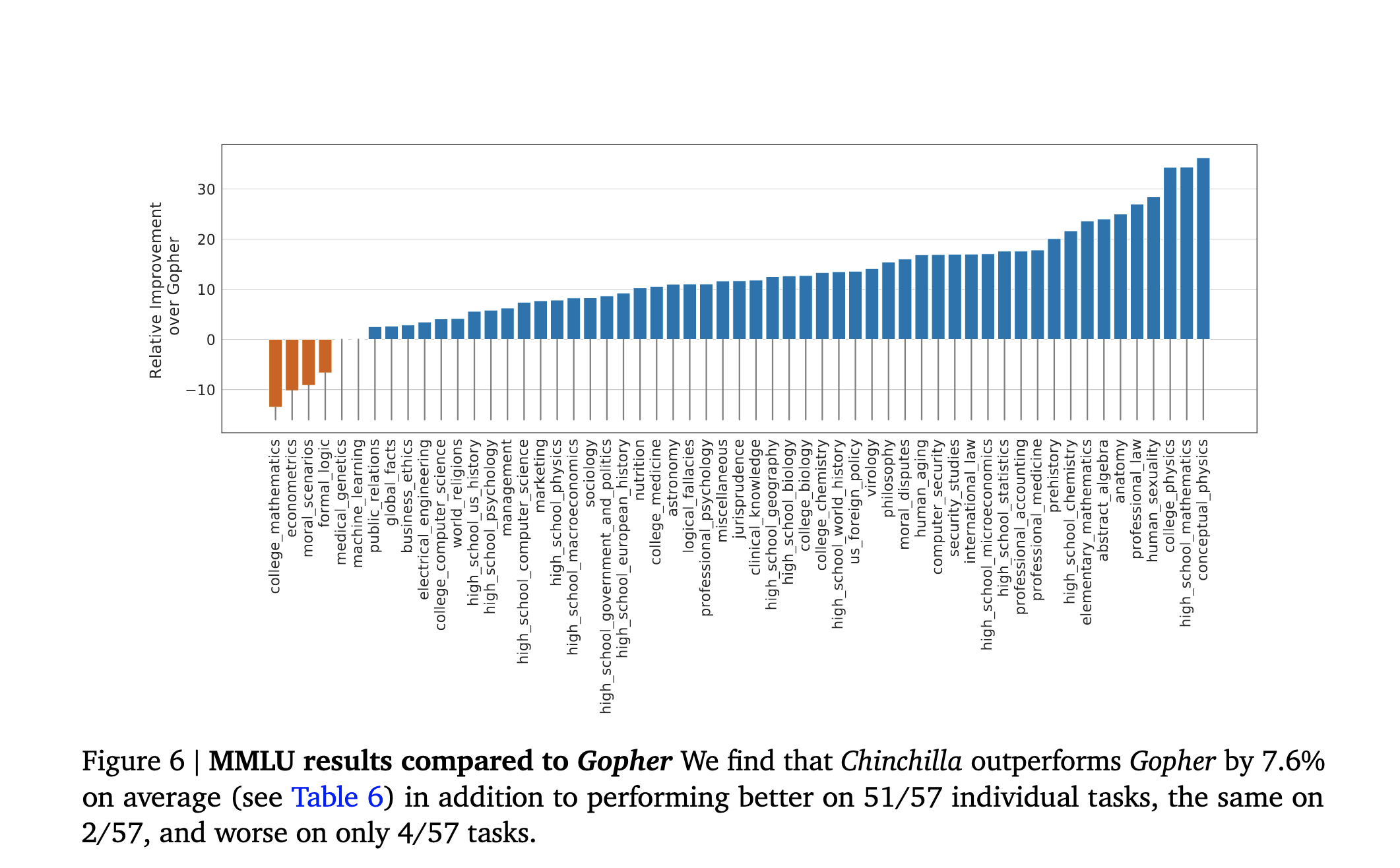

为此,DeepMind提出了新的优化使用计算的新比例法则,训练了一个新的、700亿个参数的模型,其性能超过了更大的语言模型,包括1750亿个参数的GPT-3和DeepMind自己的2700亿个参数的 "Gopher"。

2020年,OpenAI提出了缩放法则(scaling laws),此后被用来(至少是隐含地)指导大型模型的训练。

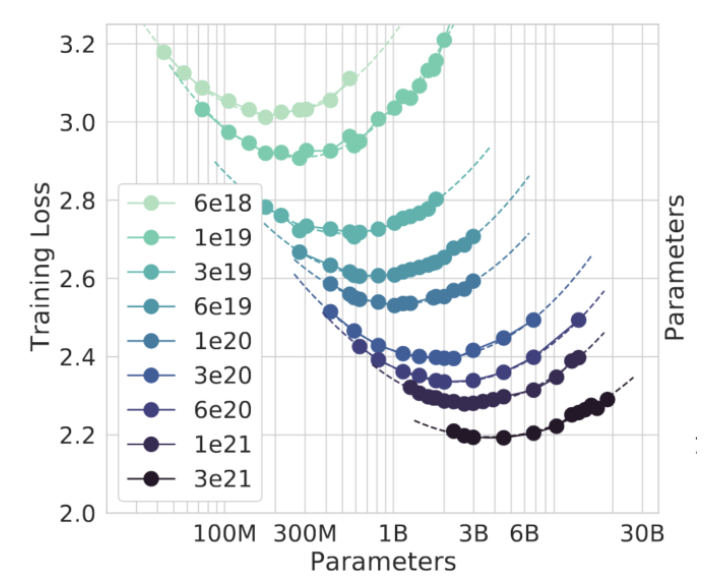

这些缩放法则试图回答几个问题。其中一个问题是 "给定一定数量的计算,我应该训练多大的模型才能获得最佳性能?"

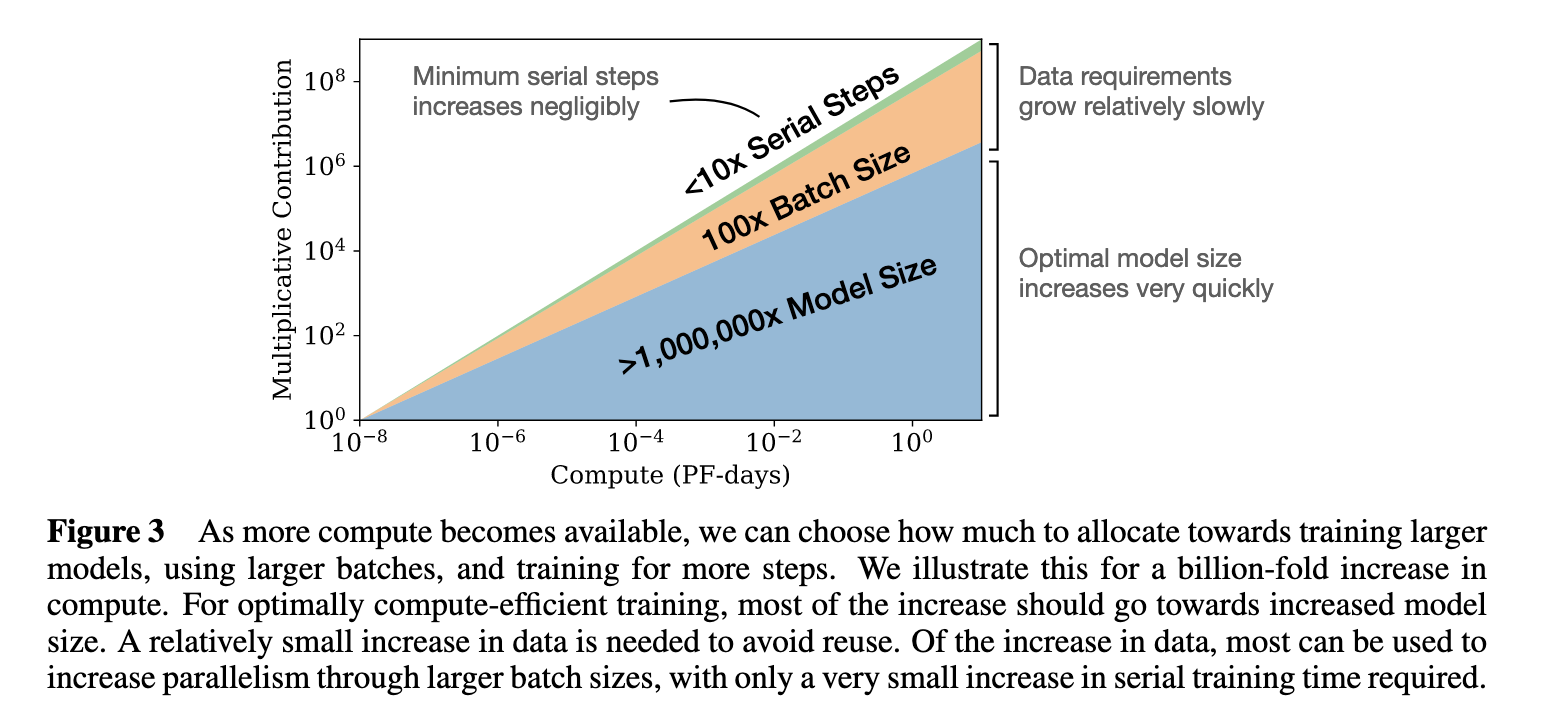

答案不是 "尽可能大的模型",因为对于一个固定数量的计算,更大的模型必须在更少的数据上训练。因此,在10本书上训练一个100万参数的模型与在一本书上训练一个1000万参数的模型所需要的浮点运算(FLOPs)是一样多的。

对于像GPT-3这样的大型语言模型,这些替代方案看起来更像是在40%的互联网档案上训练一个200亿个参数的模型,或者在4%的互联网档案上训练一个2000亿个参数的模型,或者沿着同一边界的任何一个无限的点。

这种规模的计算并不便宜--因此,如果你要在一个比你的玩具版模型大100倍的模型上每次训练花费1000万美元,你就需要比直觉更好的原则来指导你如何在 "模型看到的数据量 "和 "模型应该有多大 "之间分配这些计算。