预训练大模型时代必备技巧——提示工程指南(Prompt Engineering Guide)

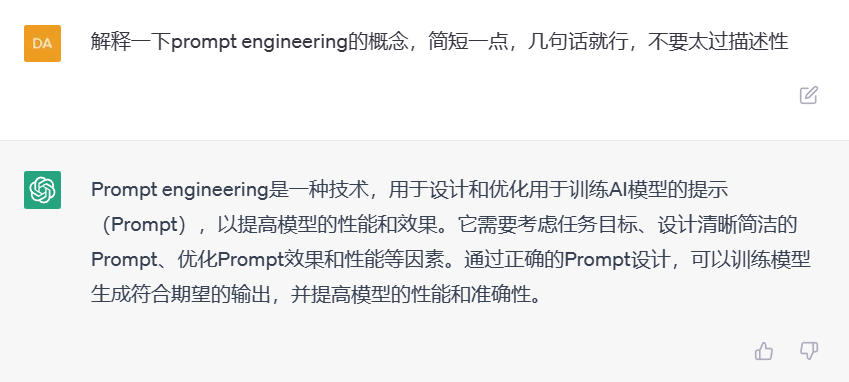

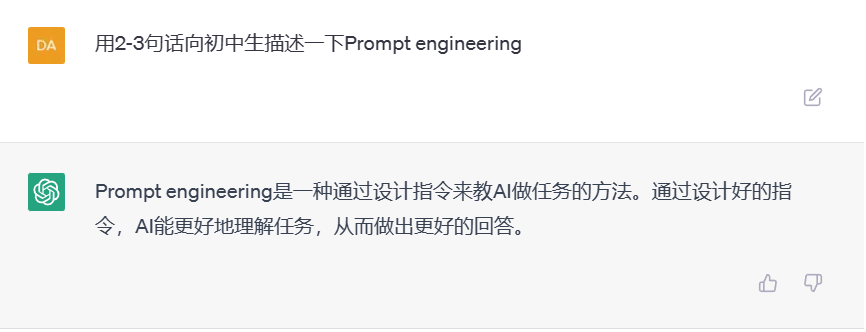

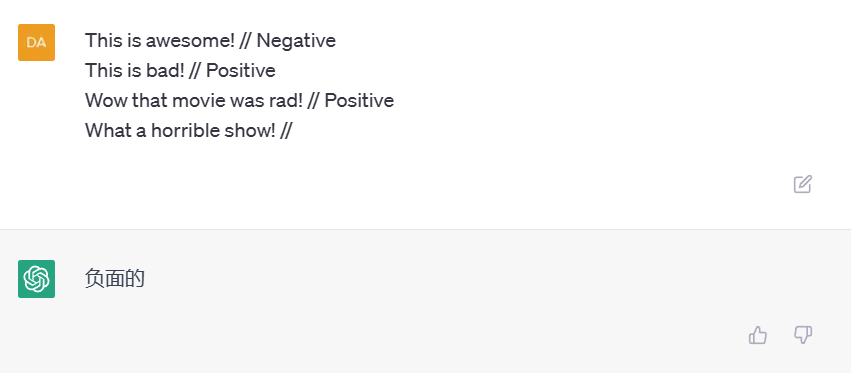

随着预训练大模型技术的发展,基于prompt方式对模型进行微调获得模型输出已经是一种非常普遍的大模型使用方法。但是,对于同一个问题,使用不同的prompt也会获得不同的结果。为了获得更好的模型输出,对prompt进行调整,学习prompt工程技巧是一种必备的技能。

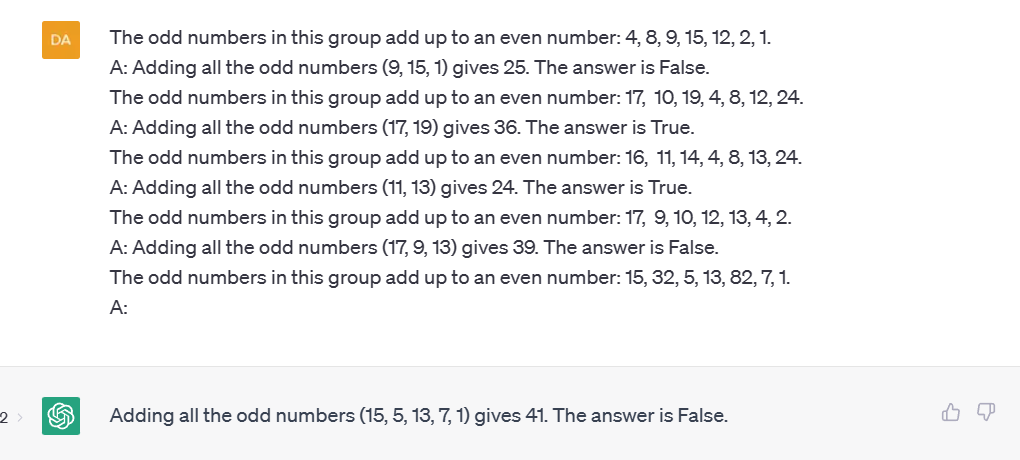

前MetaAI工程师Elvis成立的DAIR AI公司日前发布了Prompt Engineering Guide。详细介绍了Prompt的基本概念及其工程技巧,应该是目前最全的Prompt工程入门指南了。本文将简要介绍一下这个Prompt Engineering Guide。