最强AI对话系统ChatGPT不完全使用指南——已发掘功能展览!

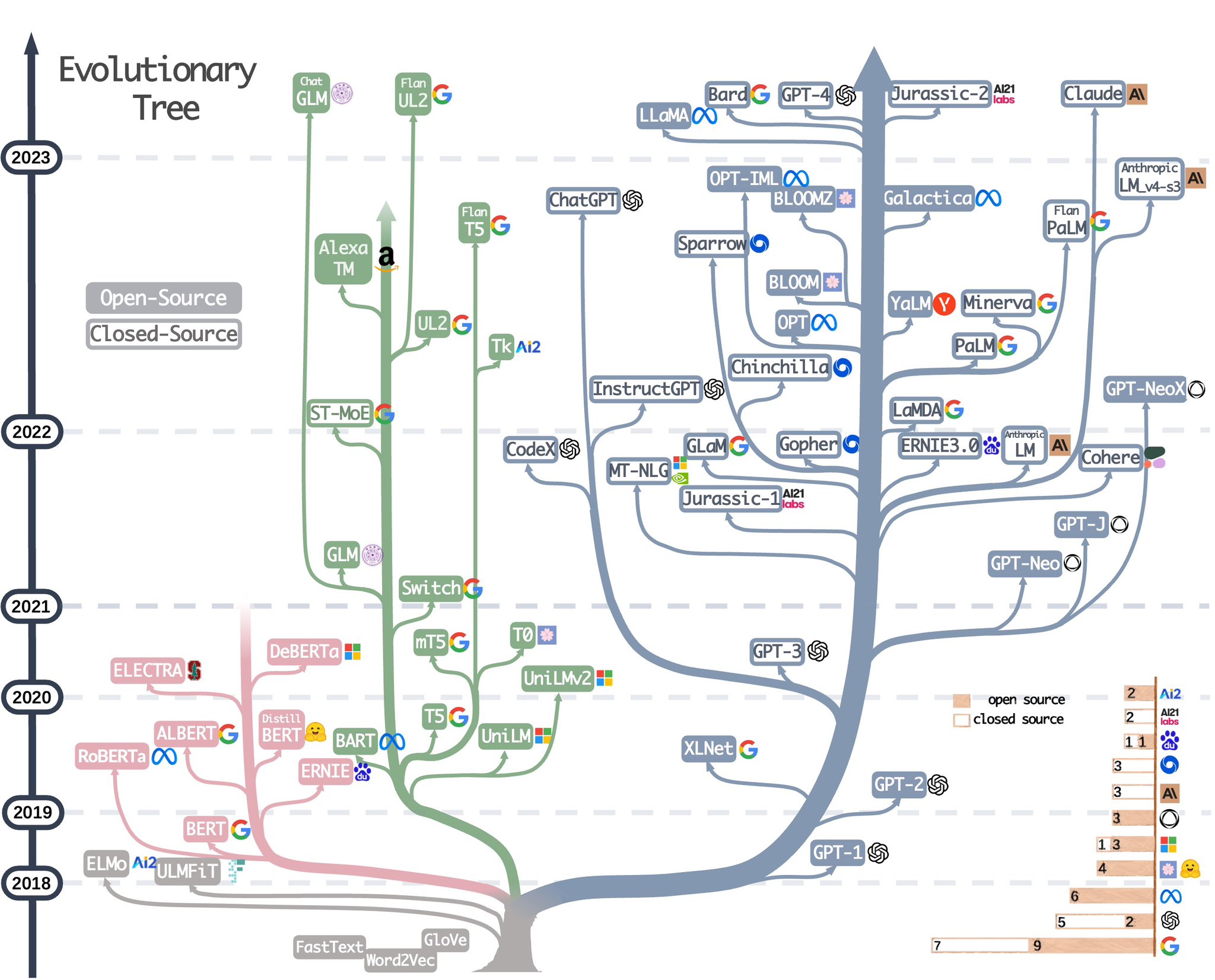

12月1日OpenAI官宣了其目前最强的AI对话系统之后,大家发现这个强大的系统能做的事情远超过大家的想象。我们也在第一时间发布了相关的博客:https://datalearner.com/blog/1051669904657253 。由于这个系统实在是太过强大,大家发现的能力越来越强。连Musk也在几个小时之前感叹这个系统是so much better at bullshit than they are!在这篇博客中,我们将收集关于这个系统目前的使用案例,给大家一个更加全面的展示结果。