Falcon-40B:截止目前最强大的开源大语言模型,超越MetaAI的LLaMA-65B的开源大语言模型

昨天,HuggingFace的大语言模型排行榜上突然出现了一个评分超过LLaMA-65B的大语言模型:Falcon-40B,引起了广泛的关注。本文将简要的介绍一下这个模型。截止2023年5月27日,Falcon-40B模型(400亿参数)在推理、理解等4项Open LLM Leaderloard任务上评价得分第一,超过了之前最强大的LLaMA-65B模型。

加载中...

昨天,HuggingFace的大语言模型排行榜上突然出现了一个评分超过LLaMA-65B的大语言模型:Falcon-40B,引起了广泛的关注。本文将简要的介绍一下这个模型。截止2023年5月27日,Falcon-40B模型(400亿参数)在推理、理解等4项Open LLM Leaderloard任务上评价得分第一,超过了之前最强大的LLaMA-65B模型。

欢迎关注 DataLearner 官方微信,获得最新 AI 技术推送

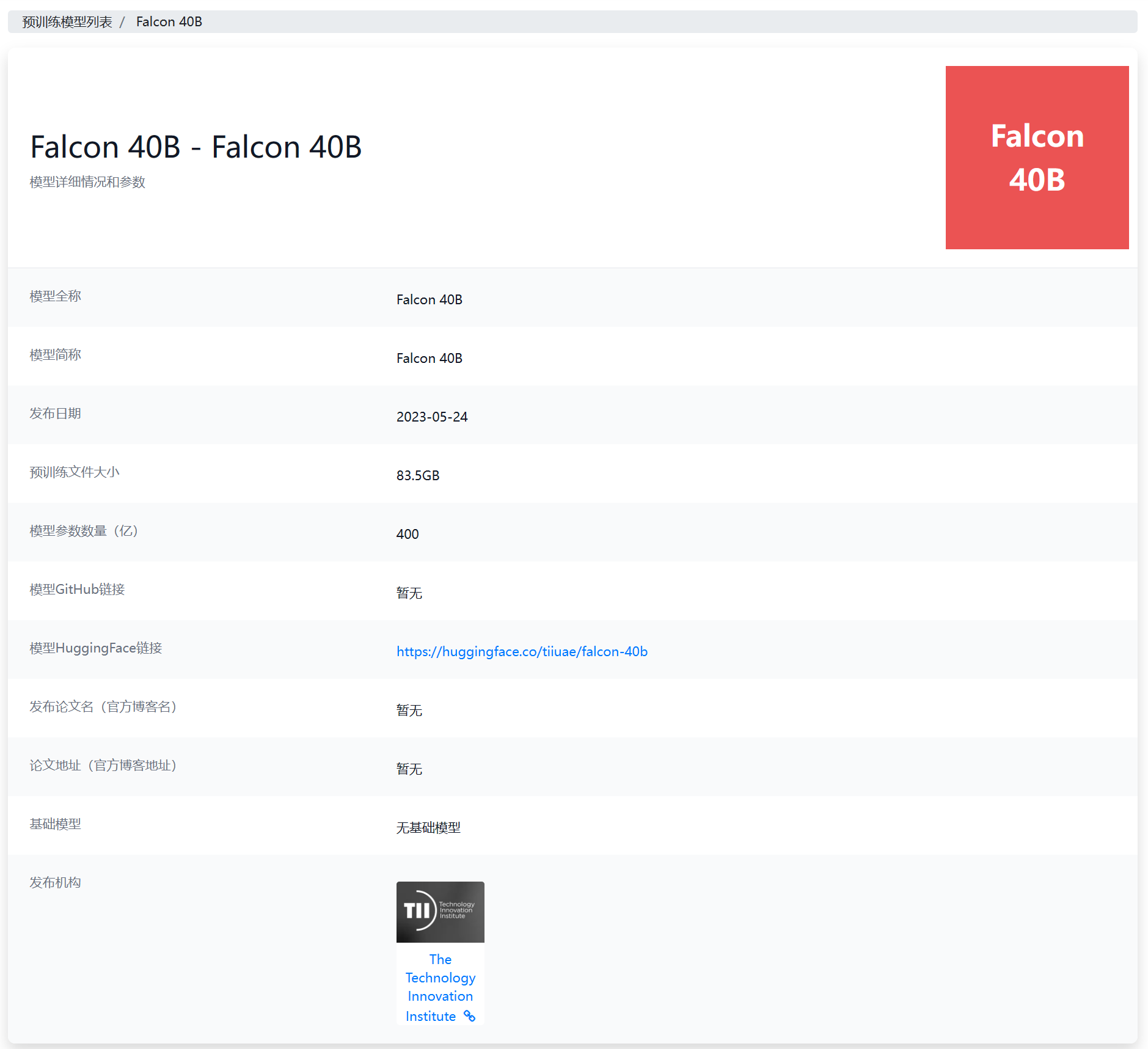

Falcon-40B模型是一个全新的开源大语言模型,由TII(The Technology Innovation Institute:https://datalearner.com/ai-organizations/TII )发布。

Falcon-40B模型参数400亿,根据官方的介绍,该模型相关的主要信息如下:

从上面的信息可以看到,这是一个在训练资源上有着很高效率的模型,它的训练计算消耗是GPT-3的75%、Chinchilla的40%,是Google PaLM-62B的80%。

官方还公布了Falcon-40B的训练参数:

官方建议,大家可以使用Falcon-40B作为基础模型,针对特定任务进行微调。如果你希望使用类似ChatGPT那样的问答能力,则建议使用他们微调后的模型 Falcon-40B-Instruct。

Falcon-40B另一个很重要的特点是数据集质量很高。由TII从公开的网络中收集爬取,经过大量的过滤(包括删除成人内容、删除机器生成的文本等)以及重复数据删除后得到了一个仅50万亿tokens的预训练数据集。此外,他们还扩展了精心挑选的研究论文和社交媒体的对话内容以提高训练效果。

Falcon-40B模型训练的数据集是TII自己收集的,主要包括:

可以看到,其中最主要的数据集就是英文的RefinedWeb数据集。该数据集也是由TII收集,并以Apache2.0协议开源。该数据集大小是约500-650GB的压缩文件,解压之后大约几个T,获取方法如下:

from datasets import load_dataset

rw = load_dataset("tiiuae/falcon-refinedweb")

上述方法使用的是HuggingFace的datasets库,可以直接下载,这个下载结果由500GB,解压后由2.8TB。

除了数据集外,他们还公布了Falcon-40B模型的数据集语言组成情况,Falcon-40B模型支持的语言主要是英语、德语、西班牙语和法语(此外,在意大利语、葡萄牙语、波兰语、荷兰语、罗马尼亚语、捷克语和瑞典语上也可以,只是能力稍微欠缺):

可以看到,没有中文,因此Falcon-40B不支持中文!

Falcon-40B模型的开源协议很有意思,是TII自己创造的一个开源协议。主要内容是它免费授权你做个人或者非商用的研究。但是,如果你想取得商用授权是要付费的。向TII申请之后商用的费用为每年收入的10%(单看协议中8.2节的c条款的话似乎是超过100万美元收入部分的10%!年收入不超过100万美元不收费!):

8.2 Where TII grants permission for You to make Commercial Use of the relevant Work, then for that purpose You shall be considered a Commercial User, and: (a) In its written grant of permission, TII shall set the royalty rate that will apply to you as a Commercial User as a percentage of revenue ( “Relevant Percentage”), where, unless otherwise specified in the grant of permission, the Relevant Percentage shall be 10%; and (b) Each year on the anniversary of the date upon which you were granted permission by TII to make Commercial Use of the relevant Work (the “Anniversary Date") You shall account to TII in writing in full for all revenue you have received in the previous 12 months which is attributable (whether directly or indirectly) to Your use of the relevant Work (“Attributable Revenue”); and

这是不是意味着你得向TII透露你的财务信息呢!

Falcon模型目前有3个版本:

| arXiv, PubMed, UPSTO, etc. |

| 2B |

| Czech | 3% | 2B |

| Swedish | 2% | 1B |